补全llm知识体系的地基:初始化

初始化的出发点:希望初始化的参数在一个性能比较好的区间上

- 如果参数较为极端,例如出现了输入与输出的分布相差很远,那么在深层的神经网络中,就可能带来梯度爆炸(分布在目标函数陡峭的区间)/梯度消失(例如数值过大进入了softmax的平缓区间)

- 理想状态是,Normalization方法将输入控制在一个N(0, 1),而每一层的初始化参数能使得输出向量的二阶矩/原点矩/模长尽可能保持在类似范围内,防止极端梯度

从分布中采样:

- 均匀分布:结果单一但有界

- 正态分布:可能出现极端值

- 截尾正态分布:只有一定范围内的正态

- Xavier初始化:(从全连接的推导)

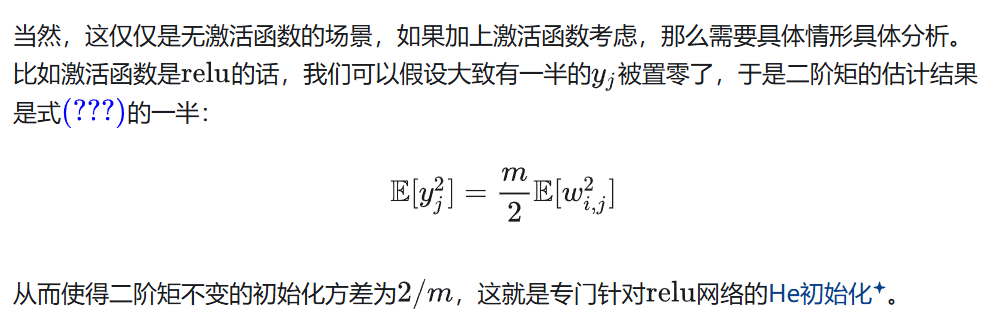

- He初始化:针对ReLU(对于不同的激活函数,初始化的采样来源分布要做相应调整),从N(0, 2/n)中采样全连接权重W

NTK:neural tangent kernel

- 对比Xavier从N(0, 1/n)中采样全连接权重W,来使得W为正交矩阵的同时保持模长不变

- NTK从N(0, 1)中直接采样,再把权重W和输入x的内积除以√n,也能保持模长不变

浙公网安备 33010602011771号

浙公网安备 33010602011771号