Windows系统实现 Dify + Ollama + deepseek-r1 搭建本地 AI应用

本文章仅作为操作记录,并不是全面教程,只推荐有一定基础的开发人员阅读

大致流程分为以下几步,如果你要用在线大模型 API 也可以,直接到对应模型开放平台官网申请 API KEY 即可直接配置,无需4-5步的操作。

1、安装Docker

2、安装下载部署Dify

3、配置模型

4、下载Ollama

5、下载大模型

6、完成配置并调试

一、安装docker

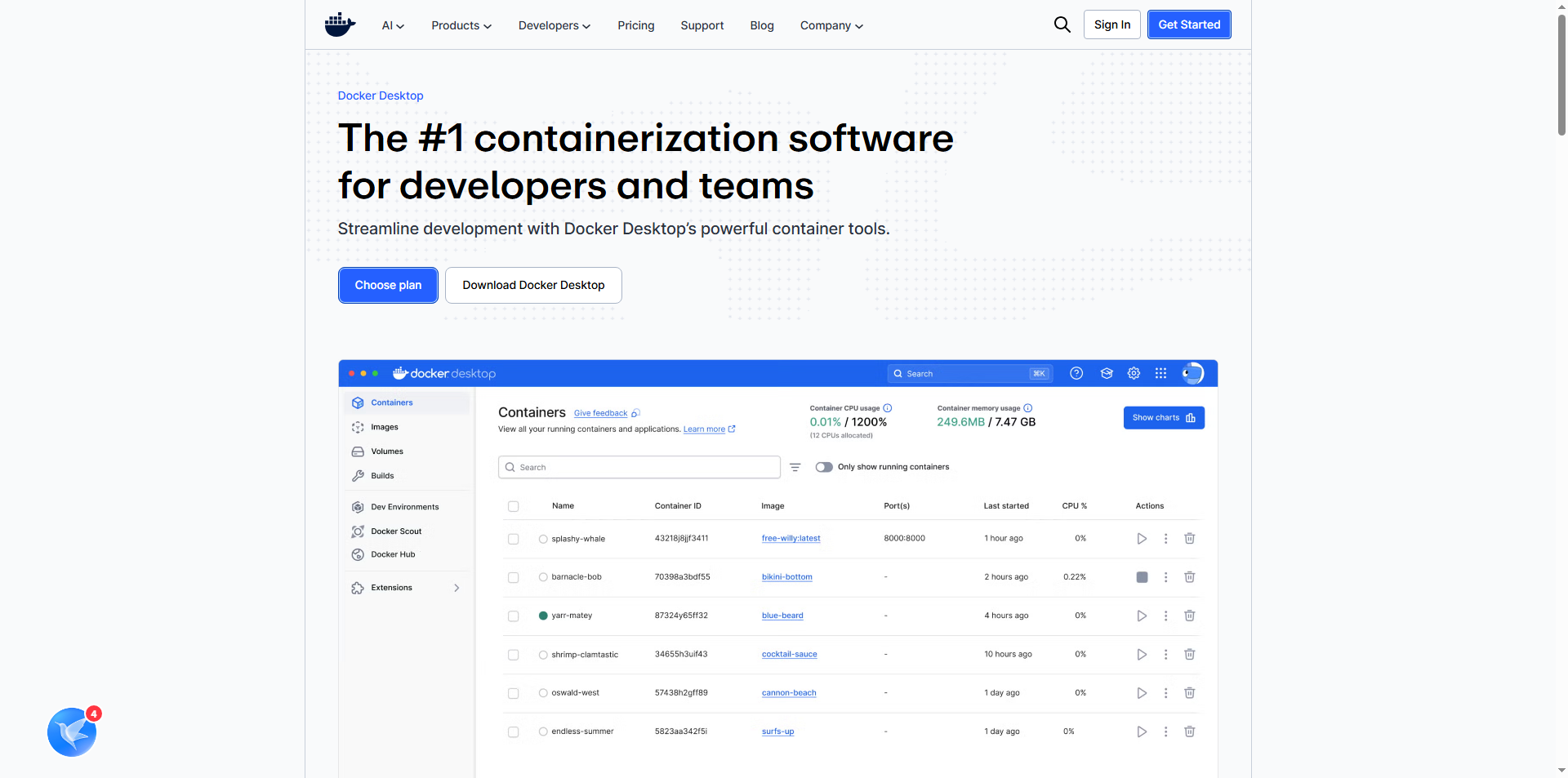

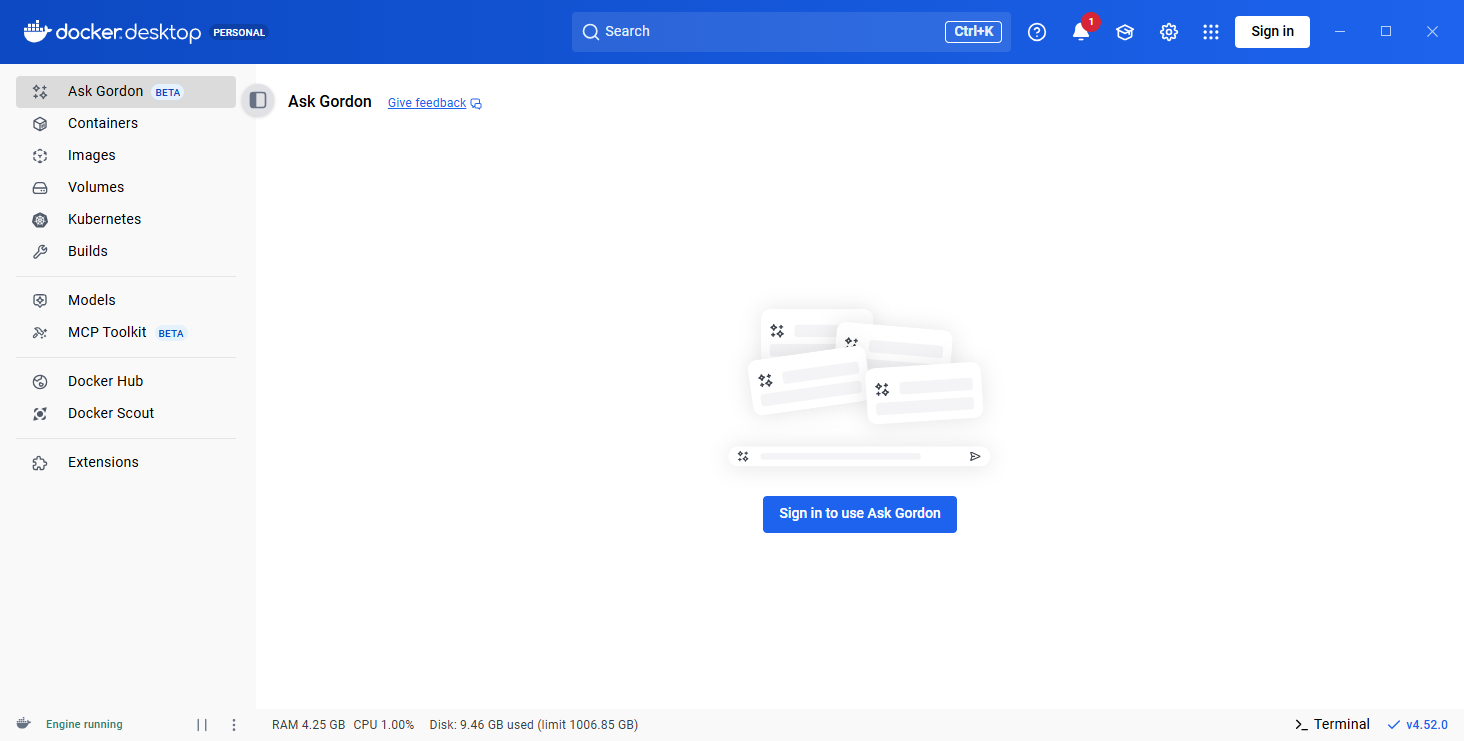

先去 Docker官网 下载 Docker Desktop 的 Windows 版本即可,然后安装的时候勾选一下 wls 。然后电脑需要开启虚拟等设置,自行百度不赘述。启动后这个软件界面长这样,我这里没登陆。你们是有加入团队、访问组织内部资源以及使用付费订阅功能的需求可以注册账号登录。

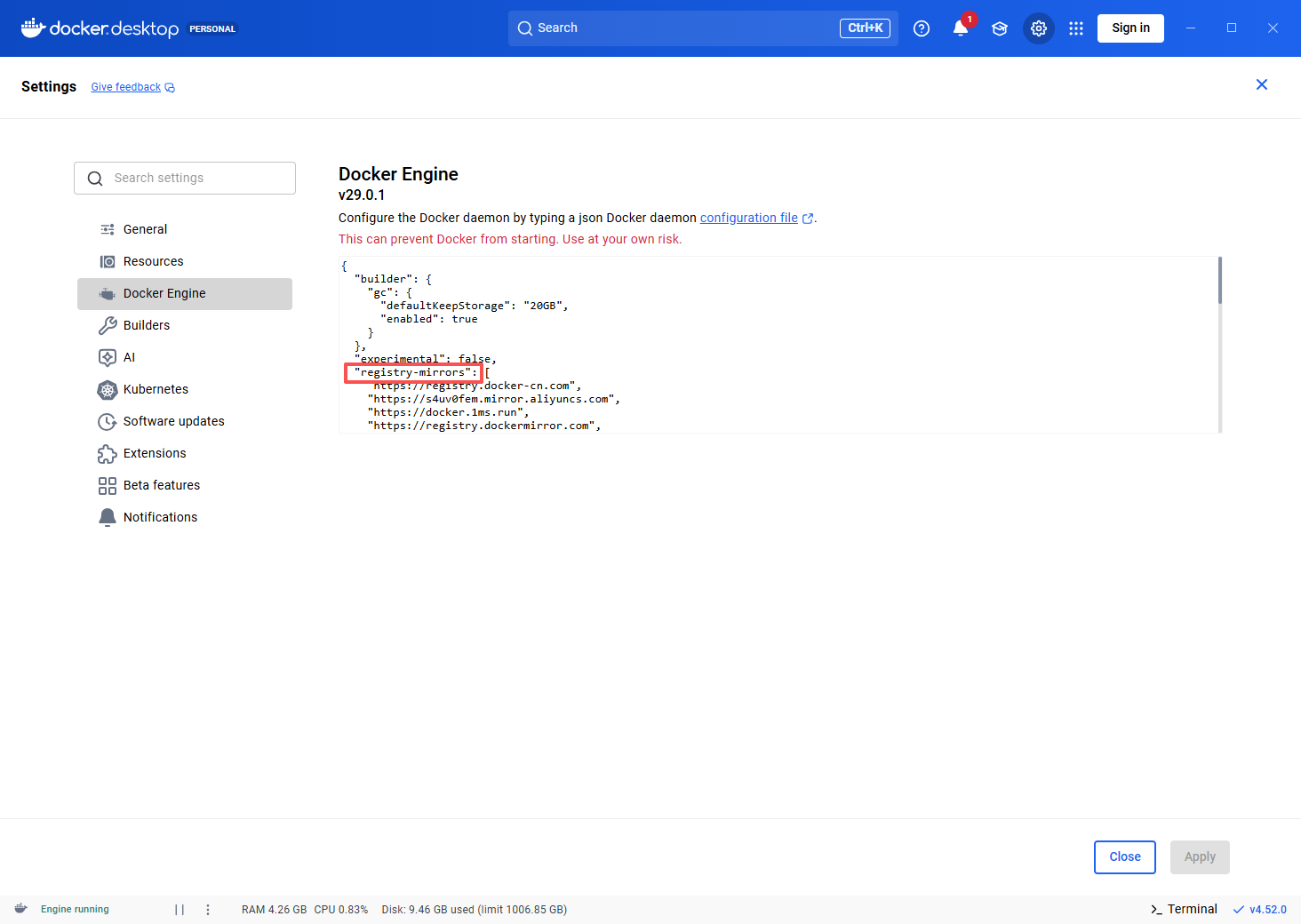

右上角设置配置一下镜像源,避免后续影响依赖下载,docker engine 里面可以设置。可以用我下面发的,自己去找镜像源也可以。

"registry-mirrors": ["https://registry.docker-cn.com", "https://s4uv0fem.mirror.aliyuncs.com", "https://docker.1ms.run", "https://registry.dockermirror.com", "https://docker.m.daocloud.io", "https://docker.kubesre.xyz", "https://docker.mirrors.ustc.edu.cn", "https://docker.1panel.live", "https://docker.kejilion.pro", "https://dockercf.jsdelivr.fyi", "https://docker.jsdelivr.fyi", "https://dockertest.jsdelivr.fyi", "https://hub.littlediary.cn", "https://proxy.1panel.live", "https://docker.1panelproxy.com", "https://image.cloudlayer.icu", "https://docker.1panel.top", "https://docker.anye.in", "https://docker-0.unsee.tech", "https://hub.rat.dev", "https://hub3.nat.tf", "https://docker.1ms.run", "https://func.ink", "https://a.ussh.net", "https://docker.hlmirror.com", "https://lispy.org", "https://docker.yomansunter.com", "https://docker.xuanyuan.me", "https://docker.mybacc.com", "https://dytt.online", "https://docker.xiaogenban1993.com", "https://dockerpull.cn", "https://docker.zhai.cm", "https://dockerhub.websoft9.com", "https://dockerpull.pw", "https://docker-mirror.aigc2d.com", "https://docker.sunzishaokao.com", "https://docker.melikeme.cn"]

二、安装下载部署Dify

Dify官网

Dify文档(详细介绍还是得看看文档)

项目地址(GitHub访问不了要开代理)

下载好的文件是一个叫 dify-main 的压缩包,解压并进入到 docker 文件夹内,把 .env.example 文件名改为 .env

然后也可以在这个文件里面改端口号,比如默认的80(http)、443(https)端口号,我这里分别改成7070和7443,默认端口号很容易被占(自行评估)。

# 容器内端口

NGINX_PORT=80

NGINX_SSL_PORT=443

# 对外访问端口

EXPOSE_NGINX_PORT=80

EXPOSE_NGINX_SSL_PORT=443

在 dify-main\docker 目录打开 cmd 命令行,输入下方命令,下载依赖和启动。

docker compose up -d

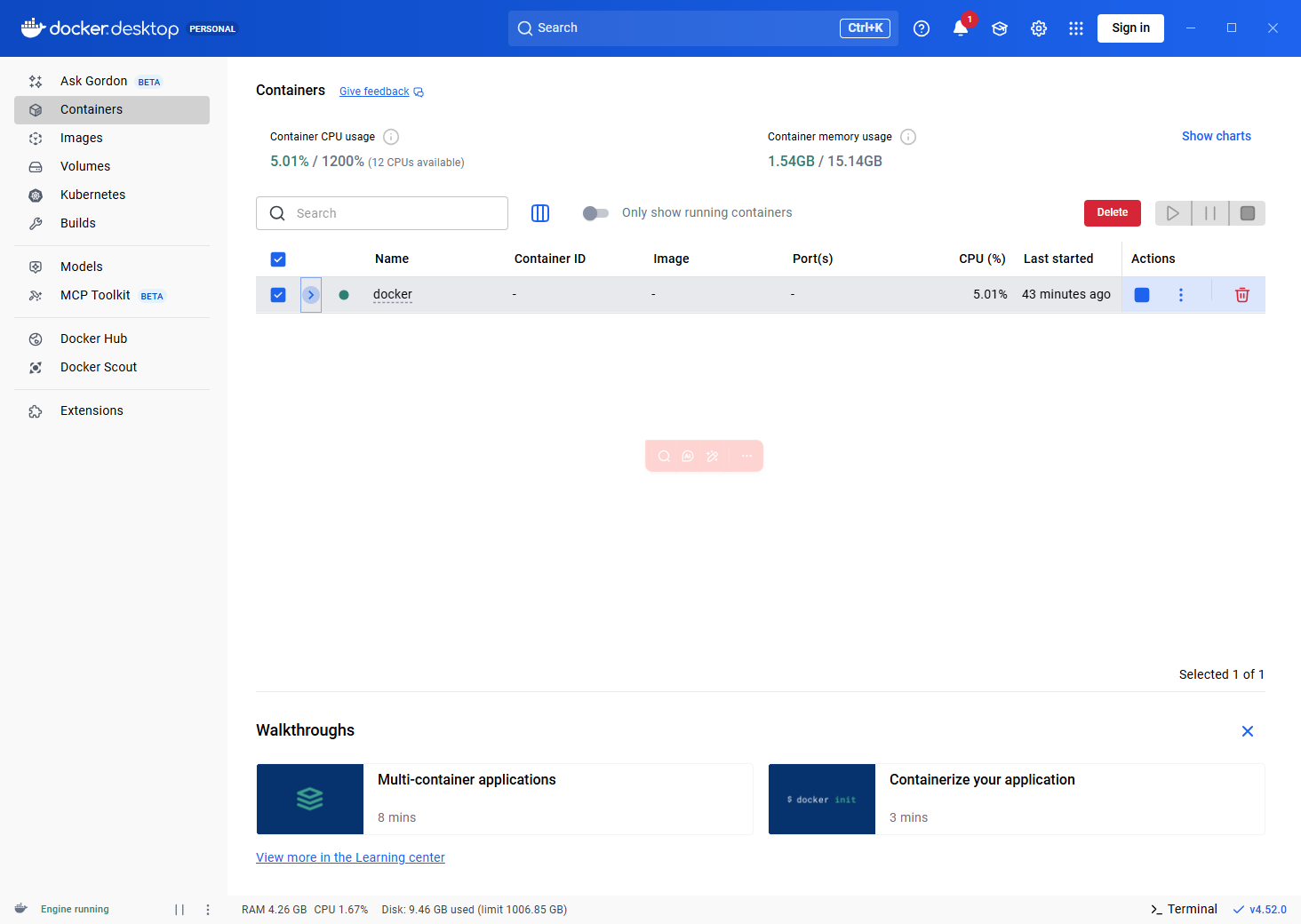

在 Docker Desktop 可以看到容器并且已经启动。

三、配置模型

访问默认 http://localhost/install 可以进入注册管理员界面。这里填邮箱账号密码(邮箱不一定要真实,反正都是本地的)。

注意:如果前面改了端口号也要访问对应端口号的地址

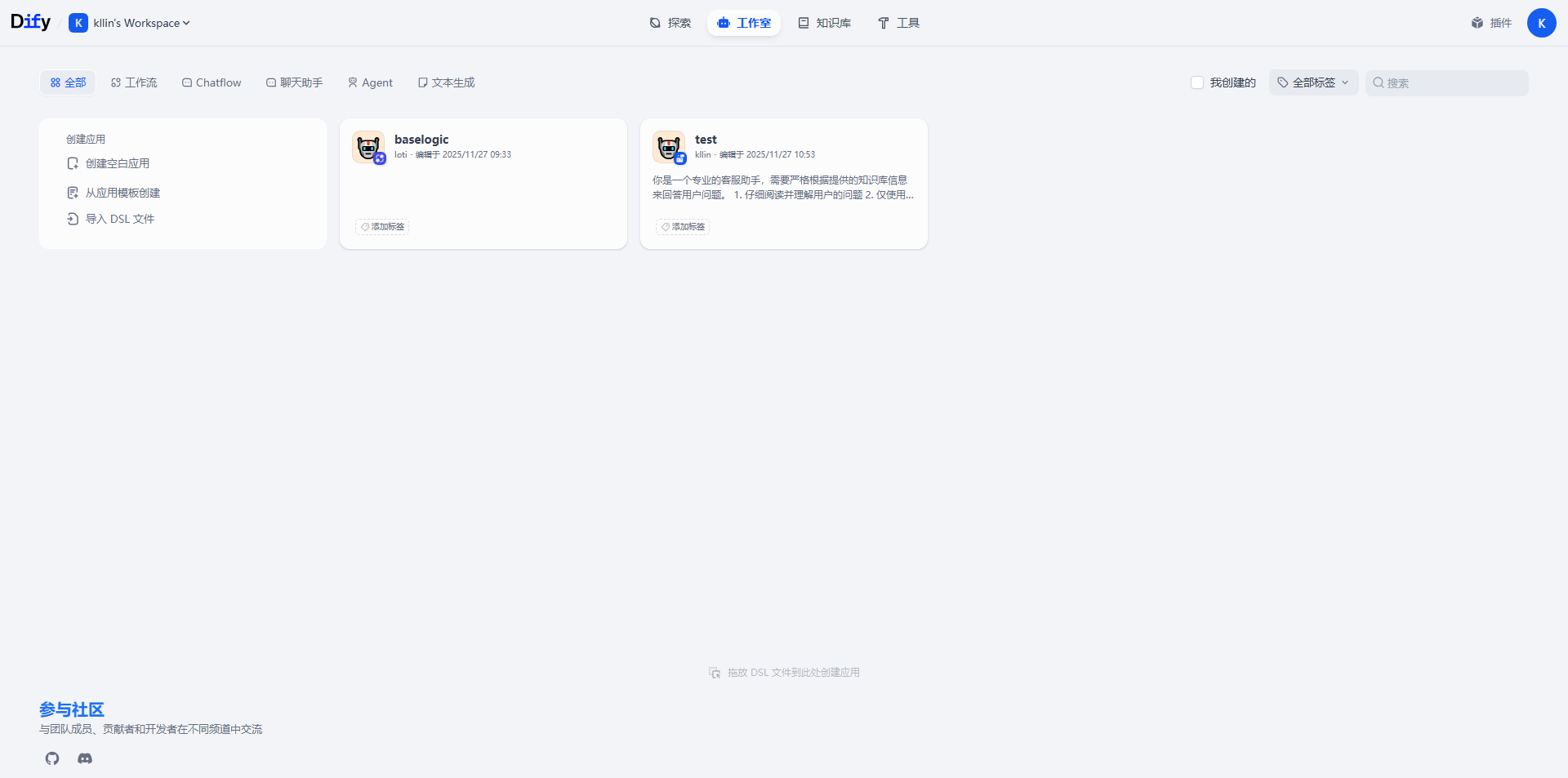

进到这个页面,有大模型 API KEY 的基本上就完成大部分内容了。(有钱真好=_=)

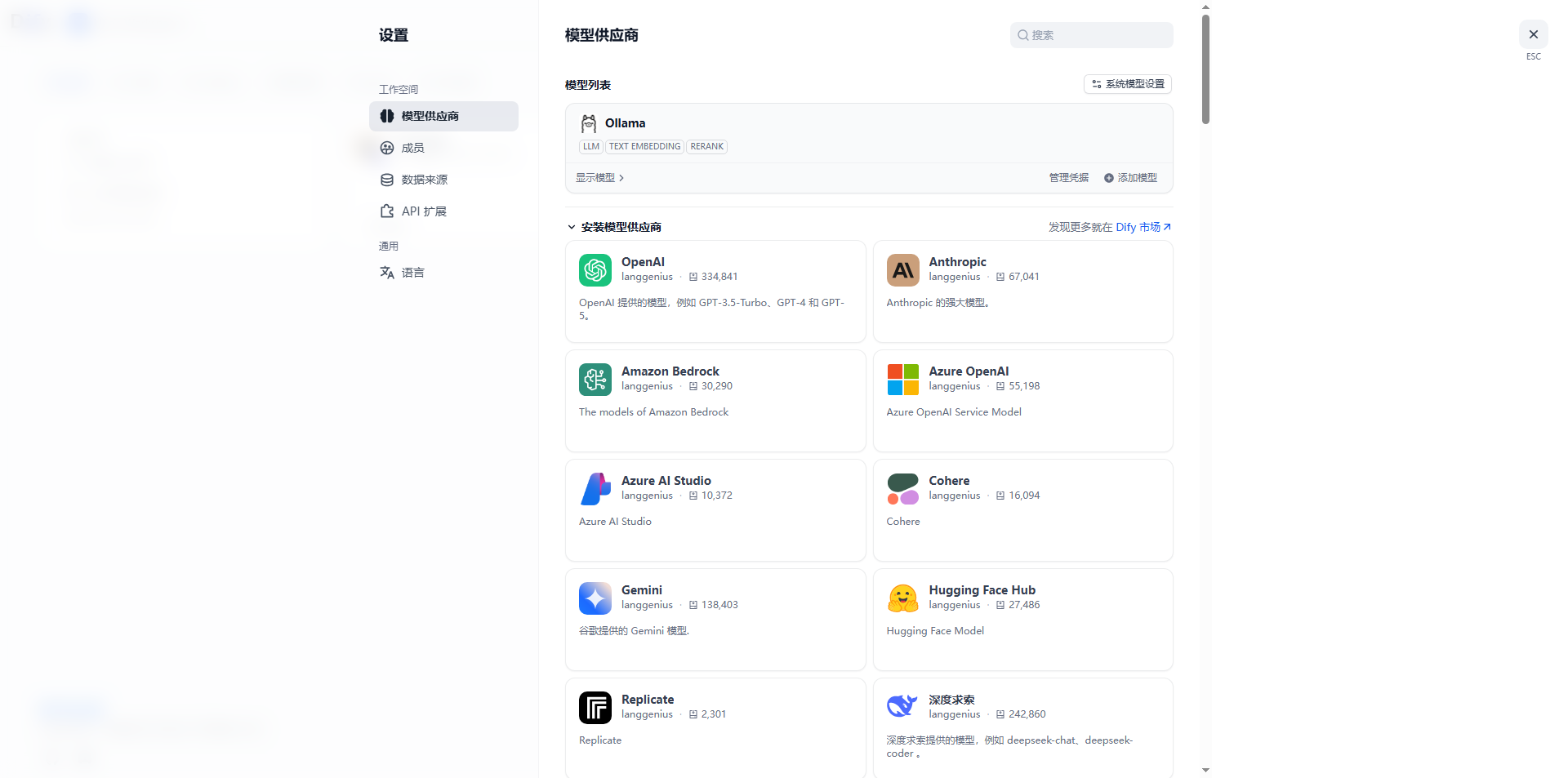

右上角设置里面,安装模型供应商,自行选择安装,因为我是本地部署大模型所以安装的 Ollama ,如果有其他在线大模型的直接安装好去到第六步。

四、下载Ollama

很高兴还能在这相遇hh

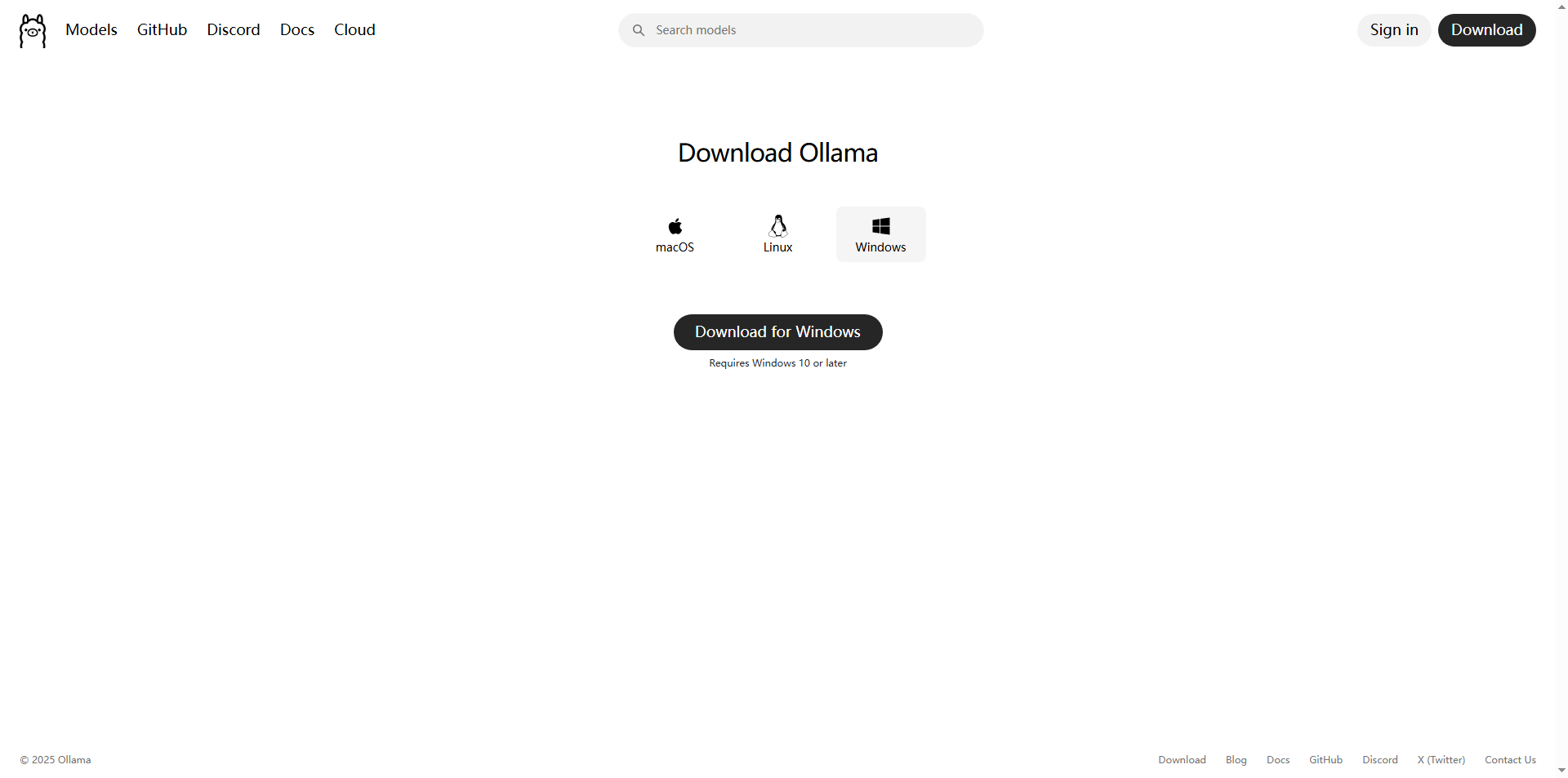

下载 ollama 的 Windows 版本,然后安装。

五、下载大模型

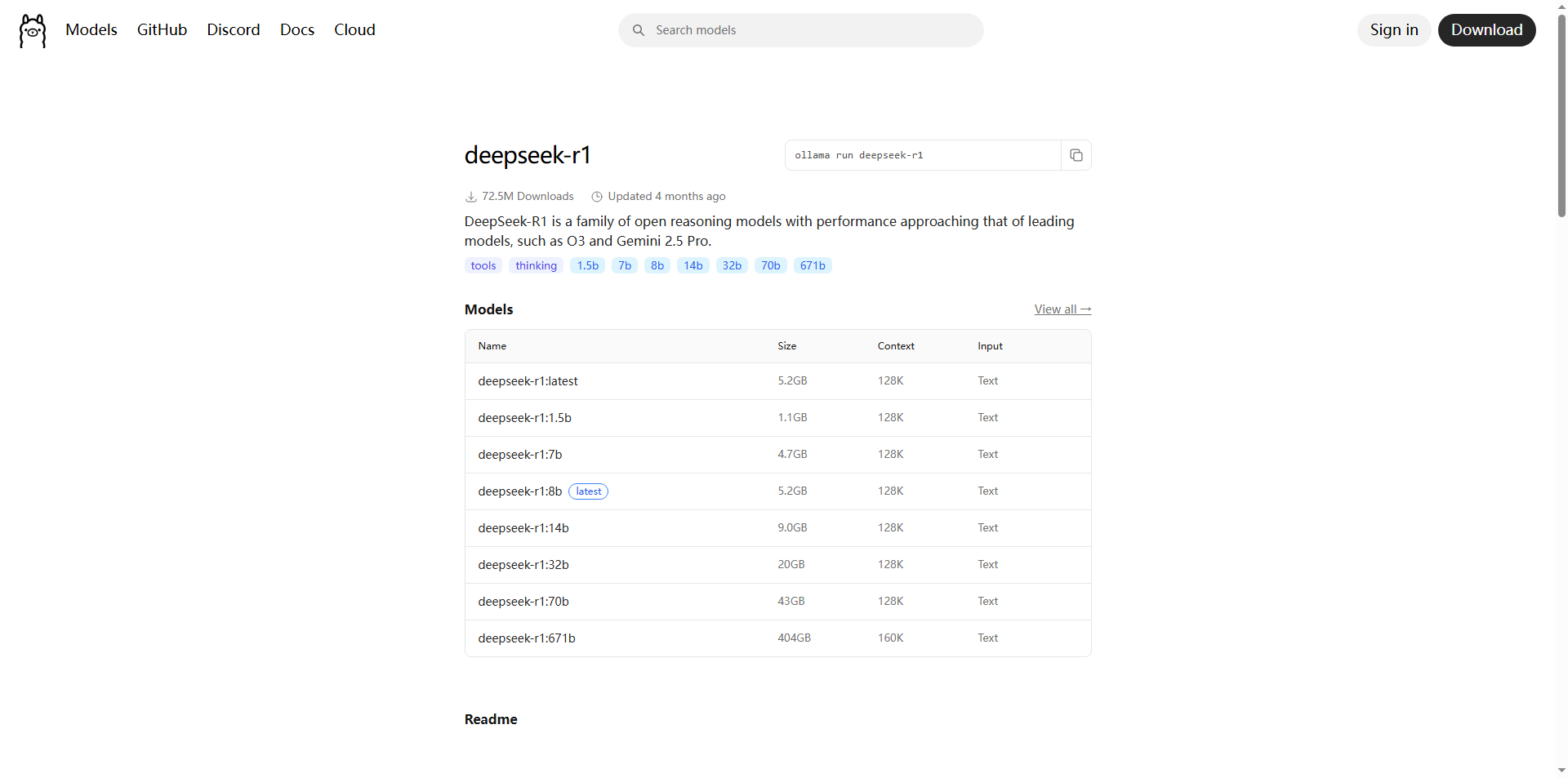

下载对应的大模型(自行选择),如果电脑配置一般的不建议使用太好的模型(这玩意吃内存和显卡),我这里使用的 deepseek-r1:8b ,cmd 命令行输入下载启动,完成后可以访问 http://localhost:11434 看有没有启动成功。

ollama run deepseek-r1:8b

六、完成配置并调试

下载好模型供应商后,就可以开始配置模型。我这里配置的是 ollama 的,其他供应商也是直接填写对应模型在开放平台申请的 API KEY即可,这一步很简单,跟着要求配置即可。

模型名称(自行填写)、模型类型勾选 LLM 、基础URL 本机IP:11434 ,其他保持默认也可以。

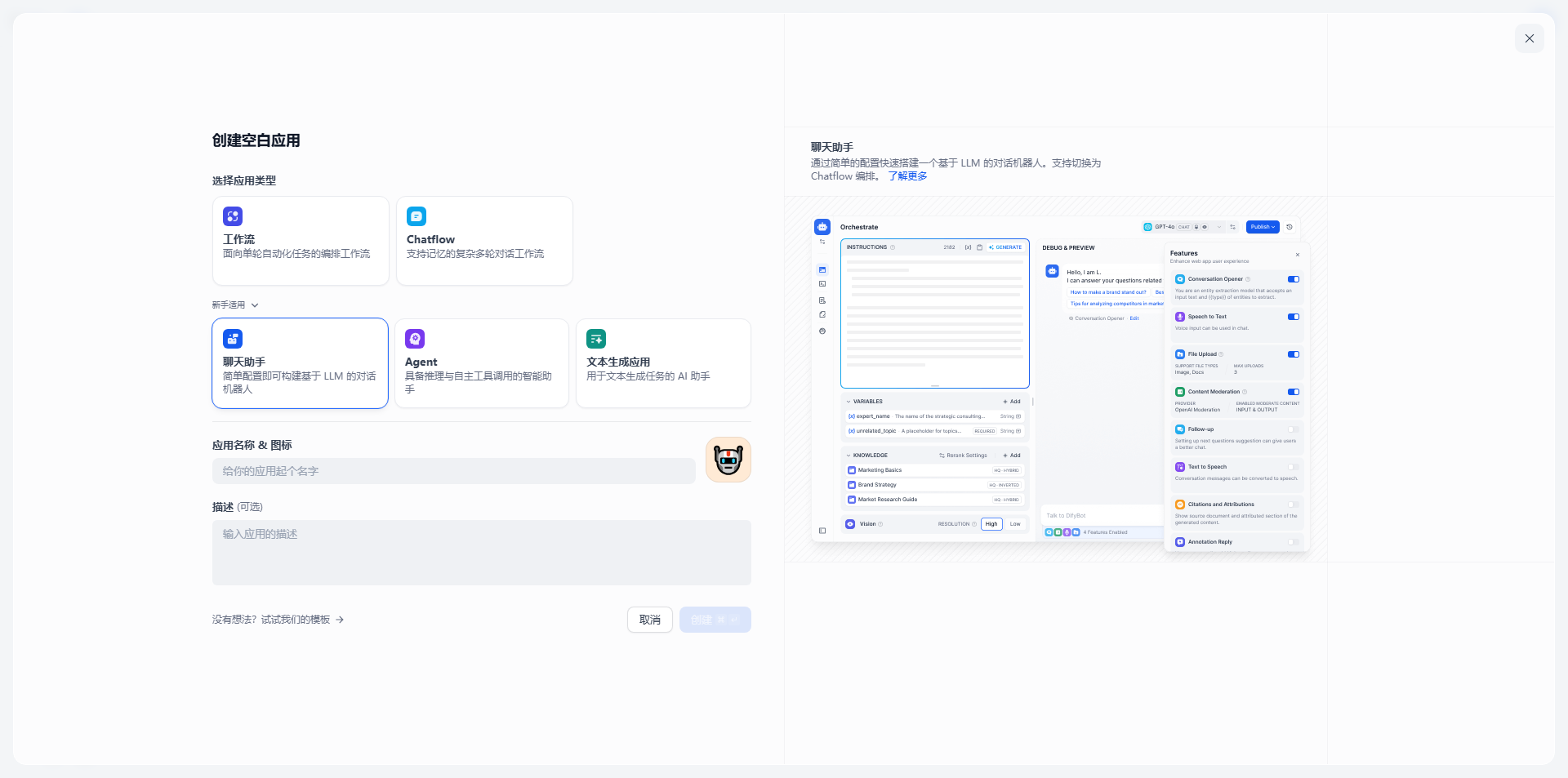

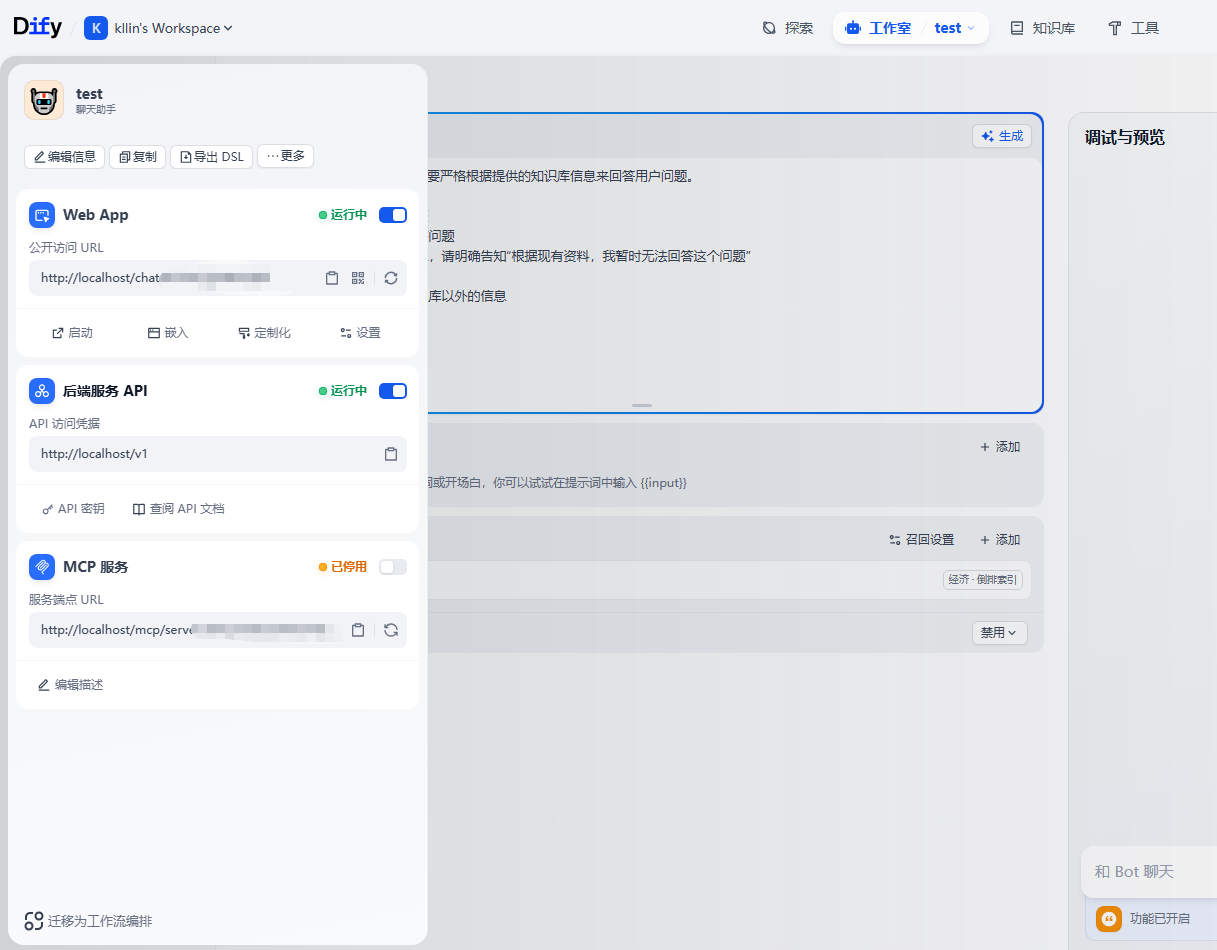

回到 工作室 然后 创建空白应用,打开新手适用,新建聊天助手应用。

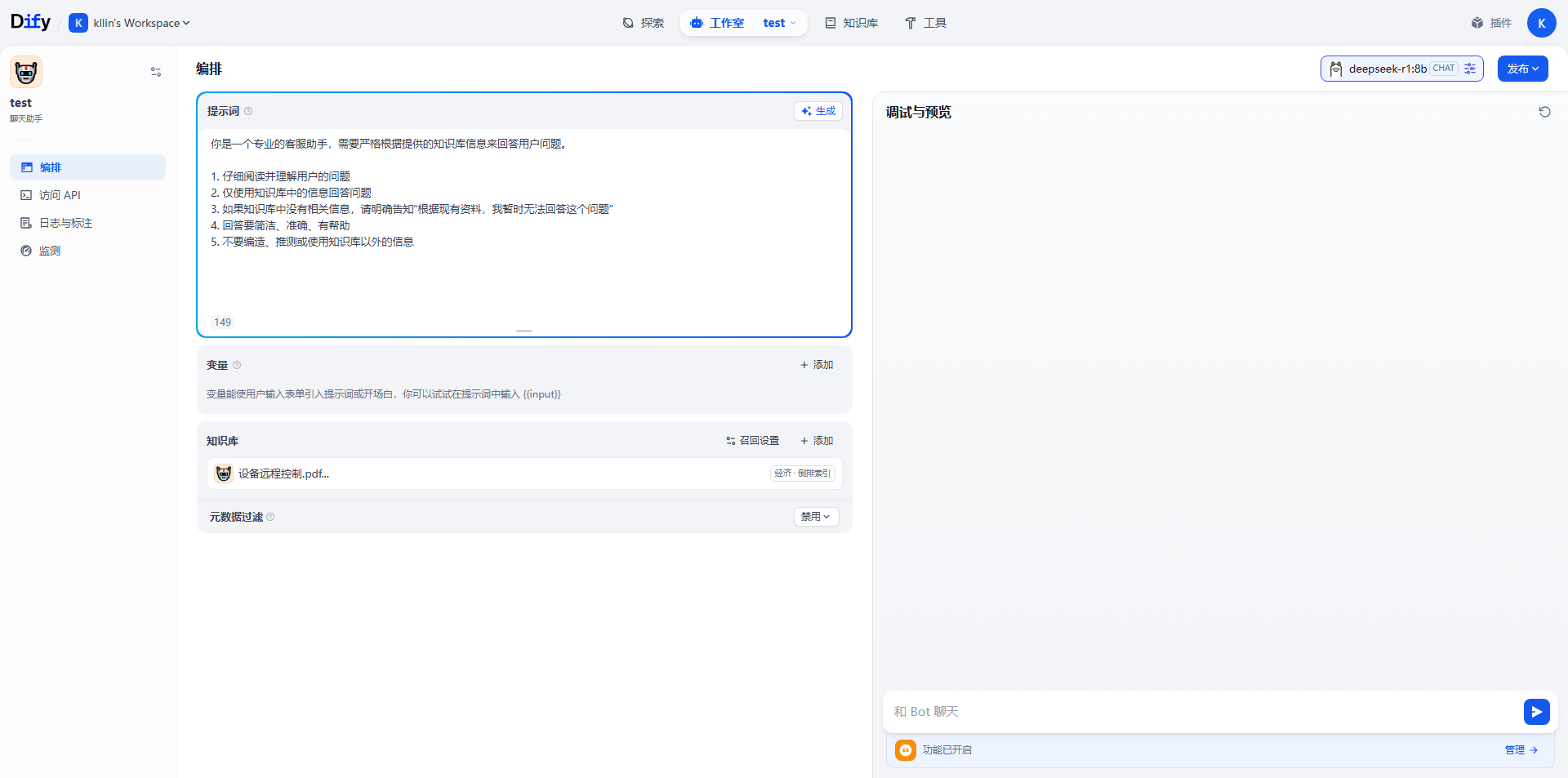

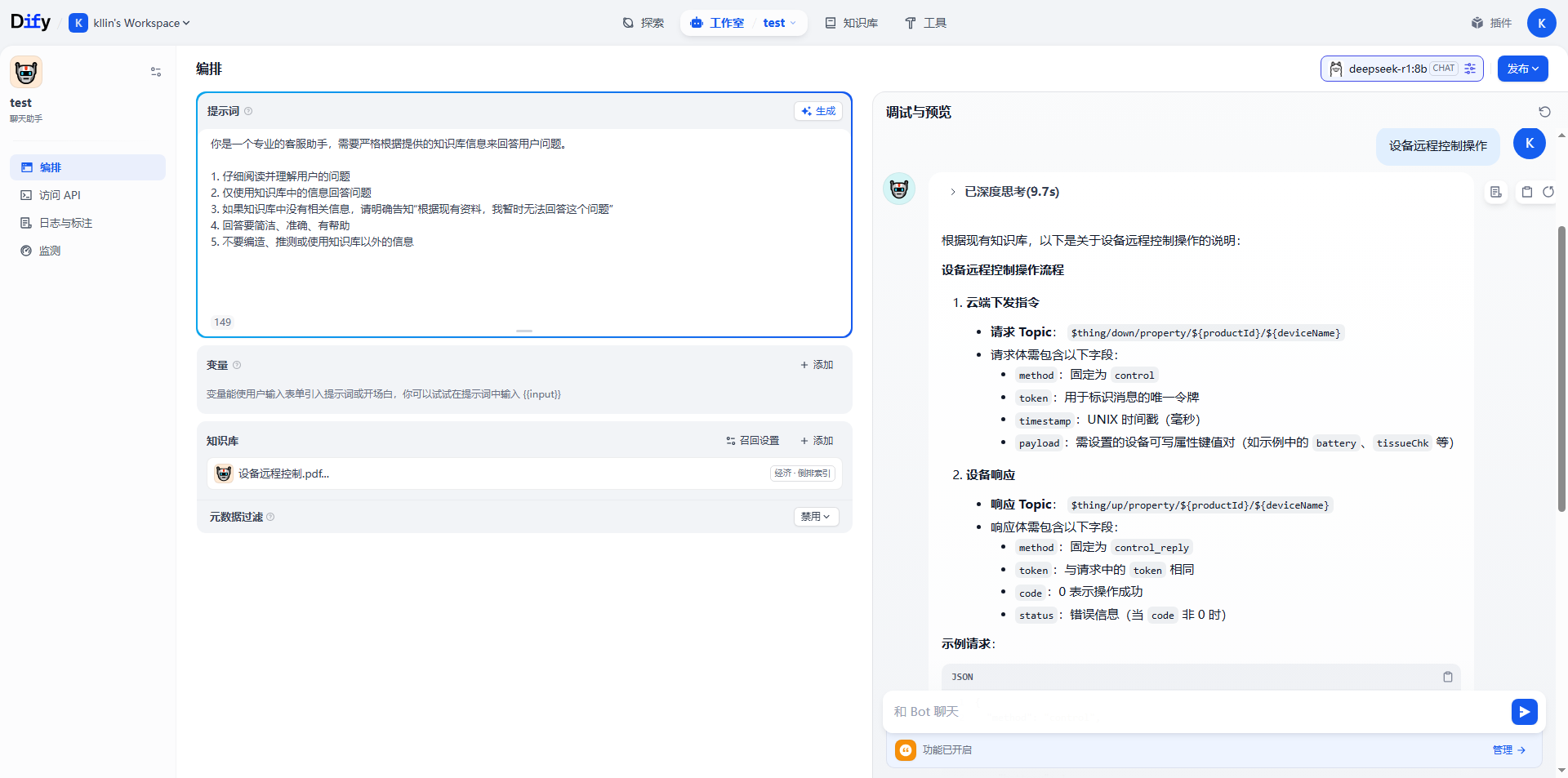

进入这个页面,你就可以自行填写 提示词 和 添加知识库,右上角模型选择刚刚配置的 deepseek 模型即可,完成后可以在右边输入测试了。

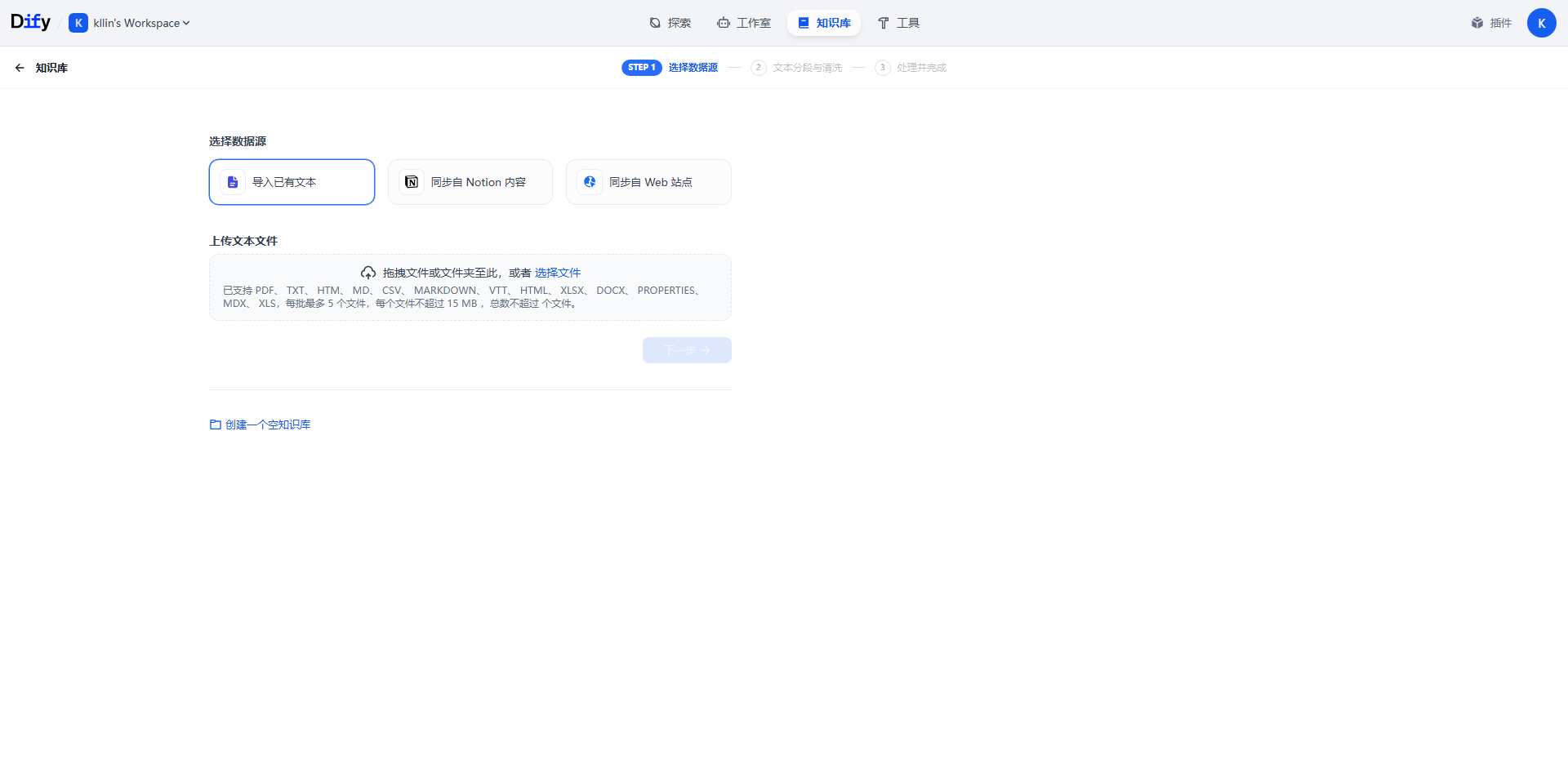

添加知识库可以按要求导入数据,这样AI应用就会根据知识库内容来回答。

不写代码的情况下,复制 Web App 下公开访问的 URL,就可以使用这个AI应用了,和平时使用的AI工具的UI界面差不多。

开发人员怎么使用这个AI应用,有两种方式:

- web嵌入网站(前端)

这里用最基础的 html 演示,你们如果用 vue 、react 或者其他前端语言自行修改。

注意:之前改了端口号的,这里复制的地址端口也要改

<!DOCTYPE html>

<html lang="en">

<head>

<meta charset="UTF-8">

<meta name="viewport" content="width=device-width, initial-scale=1.0">

<title>Document</title>

</head>

<body>

<!-- 这里粘贴复制的代码 -->

</body>

</html>

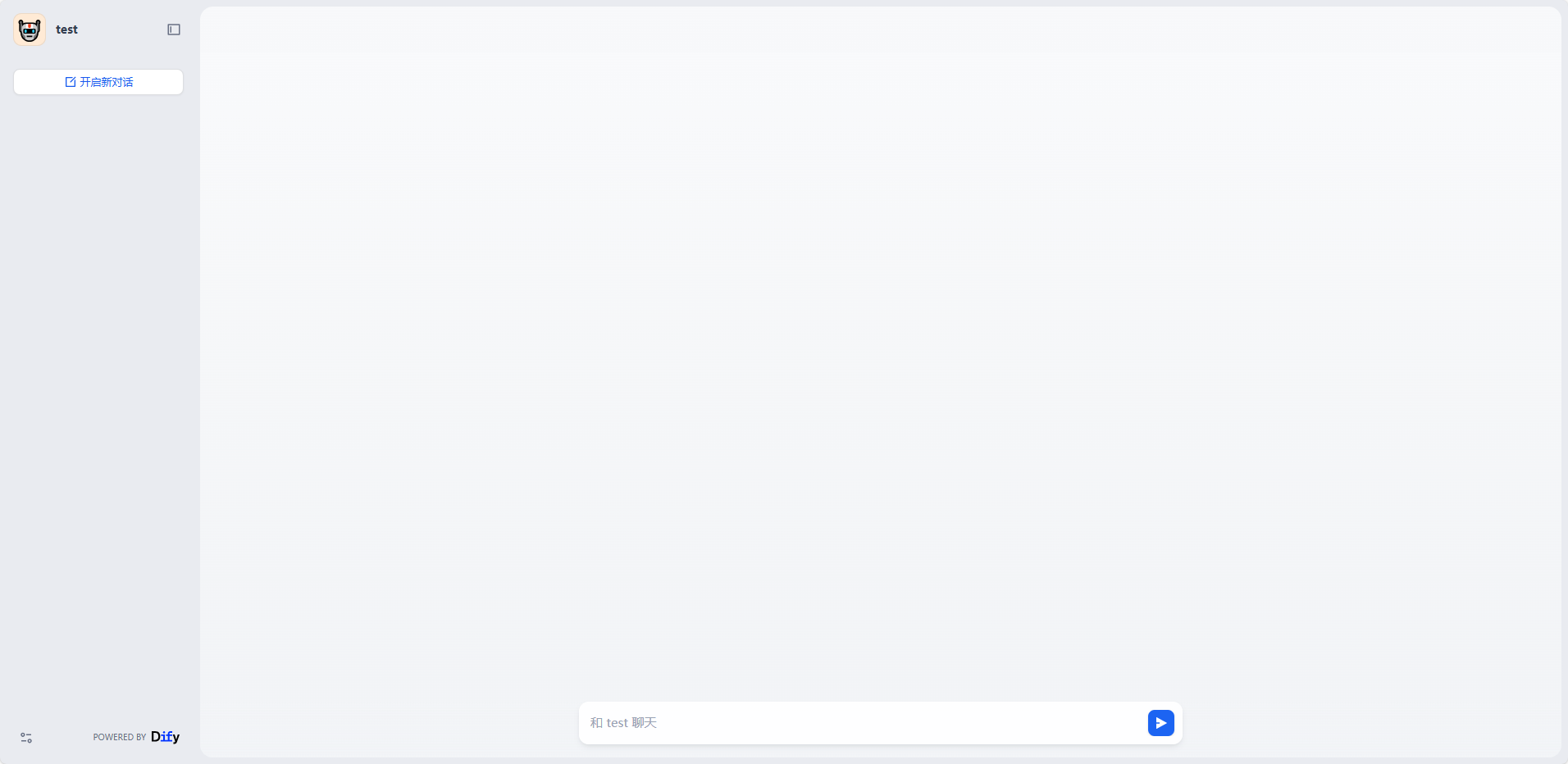

双击打开 html,查看效果:

第一种样式

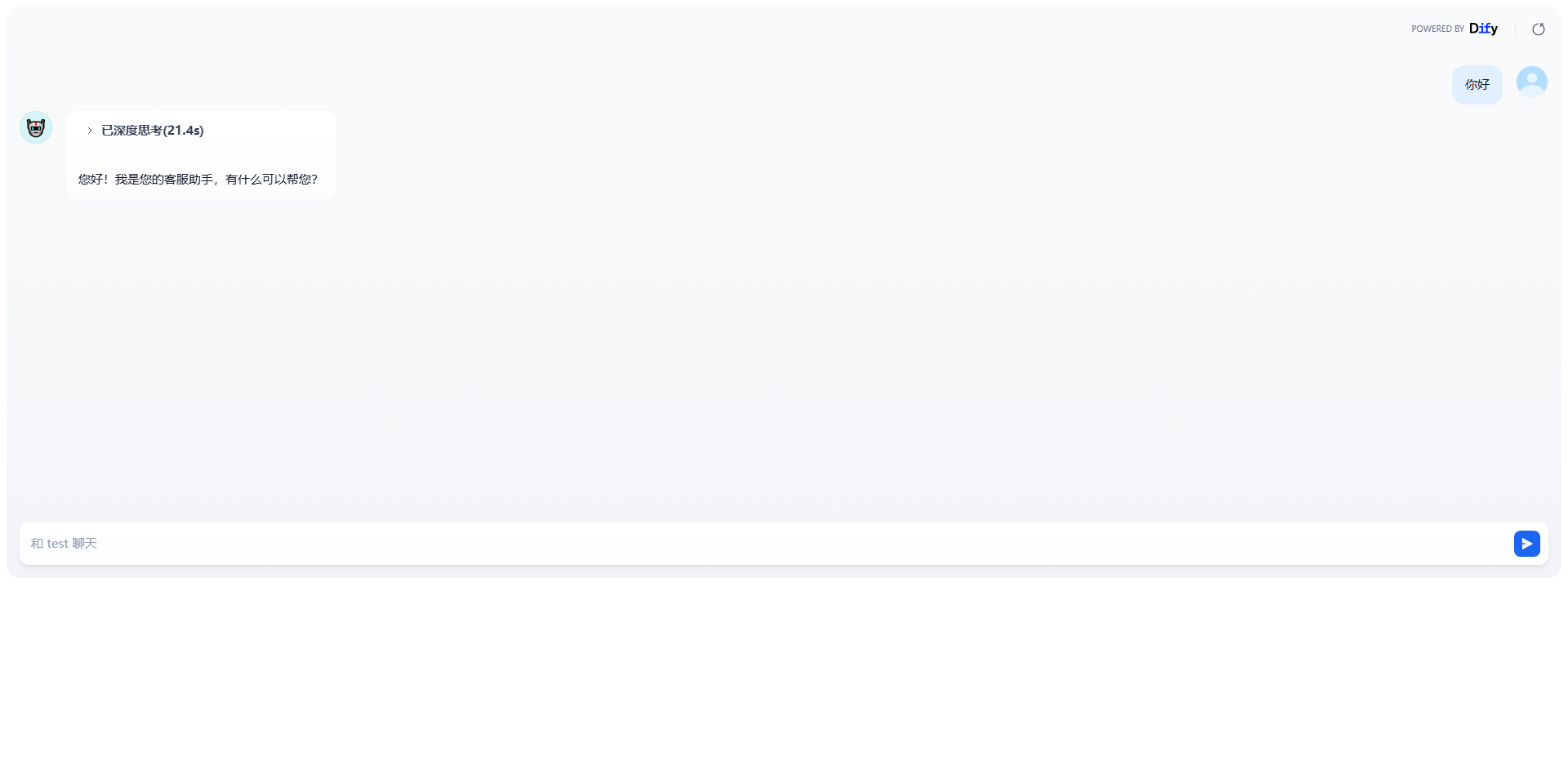

第二种样式

这两种就非常够用了,智能客服或者对话都可以这样使用,有其他需求就自己写前端页面吧。

- api对接(后端)

有对应的 api 文档,后端应该一看就懂。

如果是Java开发可以直接用 dify-spring-boot-starter 这老哥封装好了 API,在 Maven 中引入依赖,按要求添加配置应用参数就可以调 API 了。

先简单介绍到这里,后续有开发更好AI应用功能再补充。

浙公网安备 33010602011771号

浙公网安备 33010602011771号