本地部署大模型

使用软件

- Ollama

- Cherry Studio

声明:

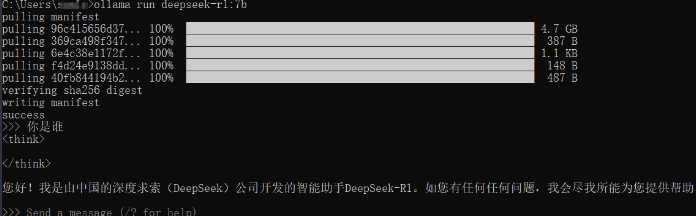

本地部署的大模型非常依赖本地硬件配置,我部署的deepseek 7b的模型,测试发现非常傻瓜,属于不可用状态。

步骤

安装Ollama

- 访问Ollama下载ollama客户端

- 默认安装并启动

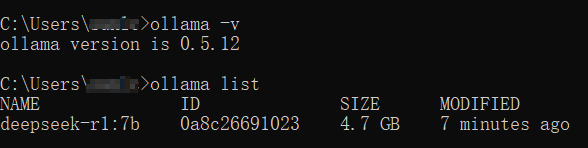

- 验证ollama安装是否成功

ollama -v

- 修改ollama 模型下载位置(可选,C盘空间大的可不忽略)

- D盘中新建Ollama和Ollama_models两个文件夹

- 将C:\Users\xxx\AppData\Local\Programs\Ollama中的文件移动到D:\Ollama下

- 将C:\Users\xxx.ollama 下的文件夹移动到D:\Ollama_models 下

- 修改用户系统变量

- Path变量中将C:\Users\xxx\AppData\Local\Programs\Ollama改为D:\Ollama

- 新建OLLAMA_MODELS变量值维护为D:\ollama_models\models

注:修改完系统变量记得重启系统生效

- 输入命令行验证调整是否正常

根据配置选择合适的模型

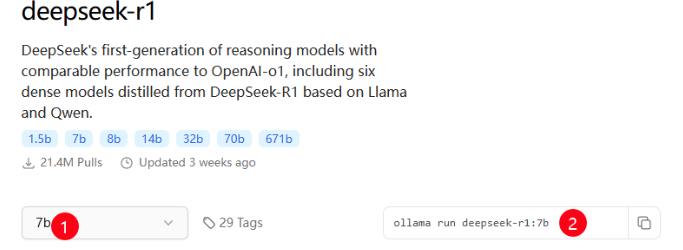

- 访问Ollama Search 确定需要安装的模型,当前常用的模型有deepseek R1、Qwen 2.5等,可按需选择

可按照本地GPU显存(GB) >= 大模型参数(B)/2

- 确认需要安装的模型之后,在命令行上运行run命令等待模型下载安装

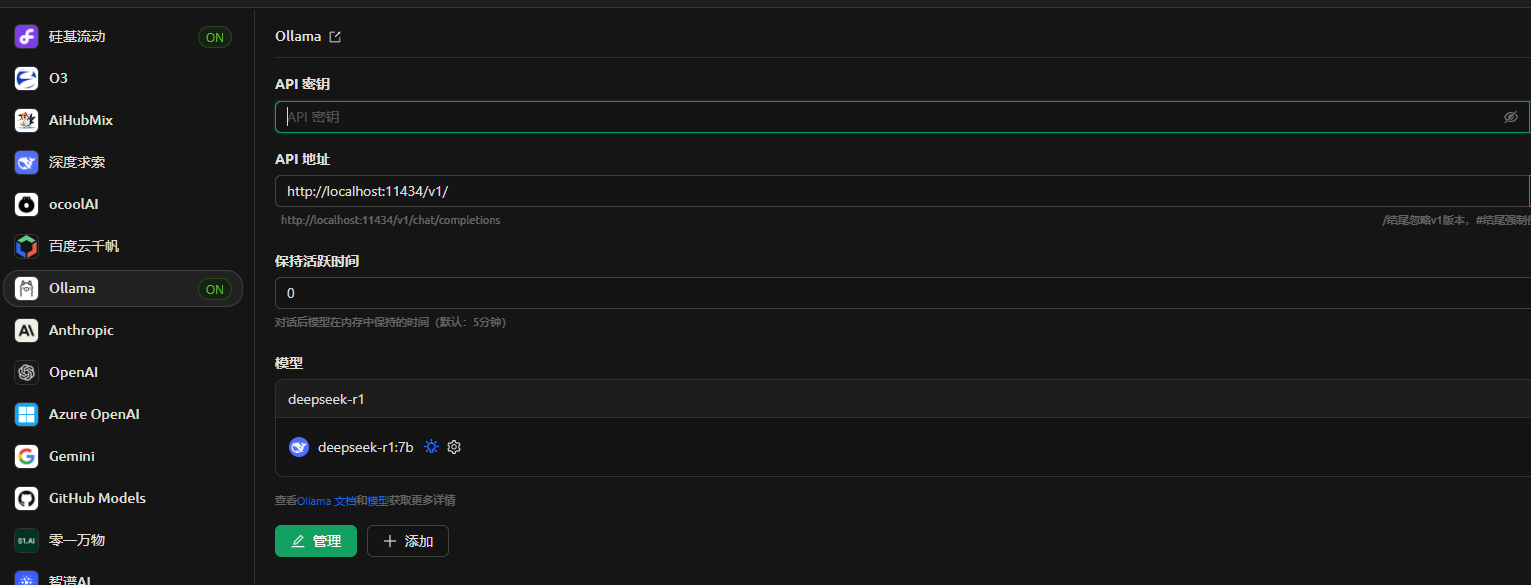

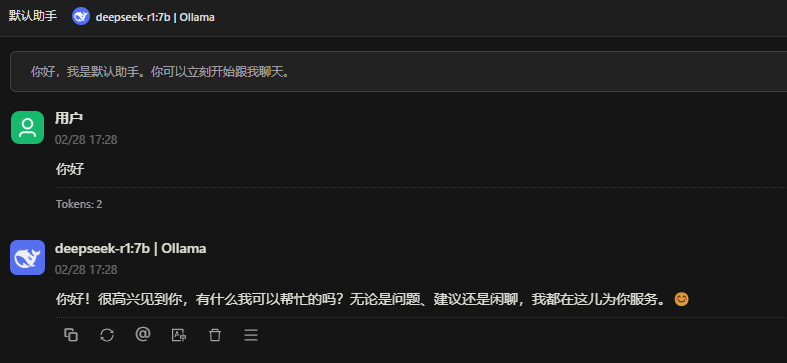

配置Cherry Studio

在设置中添加ollama的模型

助手中选择7b模型,即可开始对话

浙公网安备 33010602011771号

浙公网安备 33010602011771号