理解模型输出配置

理解模型输出配置

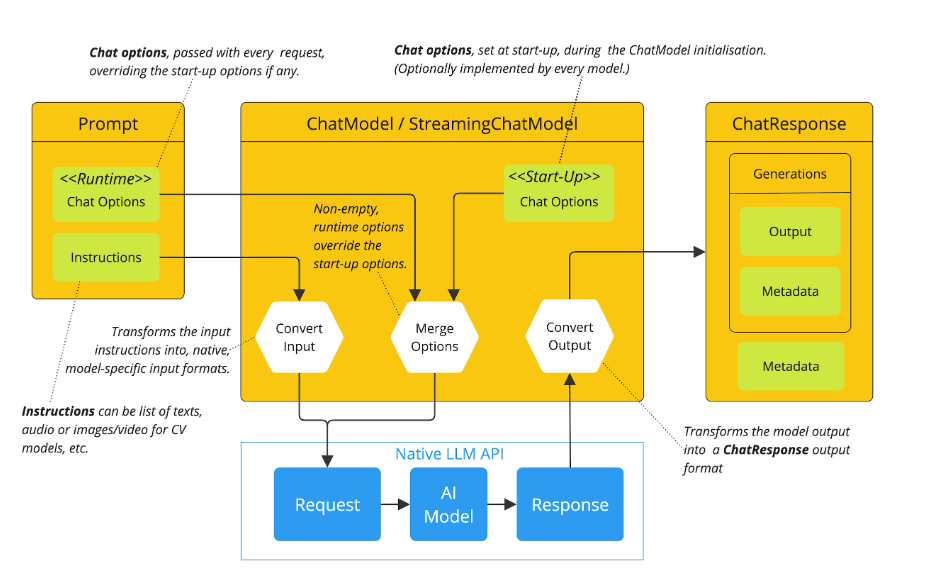

这张图展示了大语言模型(LLM)聊天交互的流程架构,可从以下模块逐一解析:

1. Prompt(输入模块)

- 包含两部分:

- Chat Options(运行时选项):标注为

<<Runtime>>,是每次请求时传递的参数,若与启动选项冲突则覆盖启动选项。 - Instructions(指令):可以是文本、音频、图像 / 视频(针对计算机视觉模型)等形式,作用是将输入转换为模型特定的原生输入格式。

- Chat Options(运行时选项):标注为

2. ChatModel / StreamingChatModel(模型核心模块)

这是聊天模型的核心层,包含两个关键部分:

- 启动时 Chat 选项:标注为

<<Start-Up>>,是模型初始化时设置的选项(不同模型可选择性实现)。 - 三个处理节点:

- Convert Input:将 Prompt 中的指令转换为模型可理解的原生输入格式。

- Merge Options:合并 “运行时 Chat 选项” 和 “启动时 Chat 选项”,遵循 “运行时选项覆盖启动选项” 的规则。

- Convert Output:将模型输出转换为统一的

ChatResponse格式。

3. Native LLM API(原生大语言模型接口)

这一层是模型的底层交互,包含:

- Request:经转换和选项合并后的请求,发送给 AI 模型。

- AI Model:实际的大语言模型,处理请求并生成响应。

- Response:模型生成的原生响应,传递给

Convert Output节点进行格式转换。

4. ChatResponse(输出模块)

是统一的输出格式,包含:

- Generations:生成结果的集合,包含:

- Output:模型生成的最终内容(如文本回答)。

- Metadata(元数据):包含模型输出的额外信息(如生成时长、tokens 统计等),此处有两个元数据模块,可能表示多维度的元信息。

整体流程总结

- 输入阶段:

Prompt提供指令和运行时选项,指令被转换为模型原生输入格式。 - 选项处理:运行时选项与启动时选项合并,运行时选项优先级更高。

- 模型交互:处理后的请求发送给

Native LLM API,模型生成原生响应。 - 输出转换:原生响应被转换为

ChatResponse格式,包含生成内容和元数据。

这张图清晰地梳理了从用户输入到模型输出的全流程,以及 “选项合并”“格式转换” 等关键环节的设计逻辑。

浙公网安备 33010602011771号

浙公网安备 33010602011771号