随笔分类 - 机器学习_基石_&_技法_林轩田

这是我2018_5跟台湾大学林轩田的机器学习基石、技法两门课程所做的课堂笔记,主要是记录自己觉得最重要也是难点的地方。主要目的是记录自己的疑惑及解惑的过程

摘要:1. 本文主题 导航页:提供本门课程的所有笔记Link 2. 关于这门课程 信息:机器学习技法,台大林轩田 3. 笔记link聚合 1. LR 2. CNN 3. AdaBoost

阅读全文

摘要:1. 本文主题 导航页:提供本门课程的所有笔记Link 2. 关于这门课程 信息:机器学习基石,台大林轩田 3. 笔记link聚合 1. ML介绍 2. ML理论 3. 一个引例——手推SLP(单层感知机)

阅读全文

摘要:本节主题:通过一个最简单的PLA算法为例,直观感受下ML。

阅读全文

摘要:1. vc dimension及vc bound 1. 定义scater:如果一个h在处理包含N个样本点的某一个数据集D时能产生 $2^N$ 个dichtopy,就说h能schater这N个样本点。【看清楚,我只说存在一个D,并没有说面对所有的N input,我的这个h都能产生 $2^N$ 个dic

阅读全文

摘要:1. ML的基本分类: 1.1 不同的$y$类型: 二元分类: 多元分类: 回归: 结构学习: 1.2 是否有$y$: 有监督(supervised): Coin Recognition:every $x_n$ comes with corresponding $y_n$ 无监督(unsupervi

阅读全文

摘要:0. 暂时就截图了,后期再花点时间用latex把公式打出来 1. 矩阵求导 参考:http://cs.nju.edu.cn/wujx/teaching/PR_02.pdf 2. 从物理意义的角度来重新审视【线性代数及其若干核心概念】: 1. http://blog.codinglabs.org/ar

阅读全文

摘要:  上】?

阅读全文

摘要:本节的主题是:Noise & Error point wise:对每一个点计算误差,并求和取均值,如图: point wise中对每个点,使用的err()分为两类:0/1 error和 squared error, 前者主要是希望【y!=y^的点越少越好,是一个离散的度量值】,这就像插值,我的预测直

阅读全文

摘要:本节主题:基于上一节的铺垫,继续深入研究当M无穷大时如何保证fesibilty of ml 1. Learnning中涉及的两个关键问题: 保证 $ E_{in} \approx E_{out} $ 保证 $ E_{in} \approx 0 $ 第二行很好理解,就是找一个合适的 ,使的$E_{in

阅读全文

摘要:本节主题: 我这个笔记是结合了Lecture4/5/6三节课的,开始讨论机器学习的可行性:Why can Learn? 主要是对三节课背后的思想的内核进行总结,并加入一点自己的思考。 1. NFL(No Free Lunch)的推论: 如果 $E_{in}$ 和 $E_{out}$ 毫无关联,那么基

阅读全文

摘要:证明的主要原则是,如果某个Ein与Eout的差别很大时,那么我们重新找一份数据集D′, 那么E′in也会有很大的几率与Ein差别很大,最后导出vc bound。待完善

阅读全文

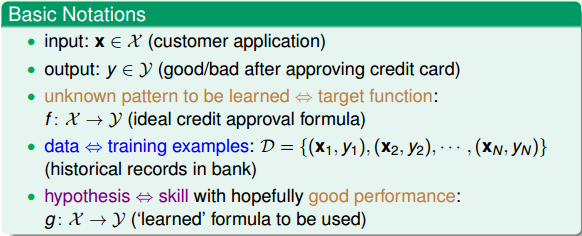

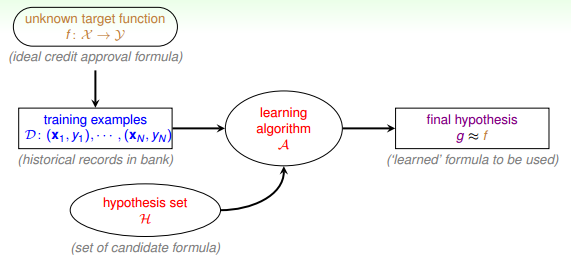

摘要:0. 本节主题是: 本节是介绍在本门课程中,涉及的机器学习的基本概念和分类。 1. 一个真实案例引入: 我们的应用场景就是:输入一个用户的申请信息,判断是否发信用卡给这个用户。 2. 对问题的形式化定义: 如下图所示: $x$:通常一个$x$是一个向量$\vec x=(x_1, x_2, ... x

阅读全文

浙公网安备 33010602011771号

浙公网安备 33010602011771号