爬取一整张页面的局部数据

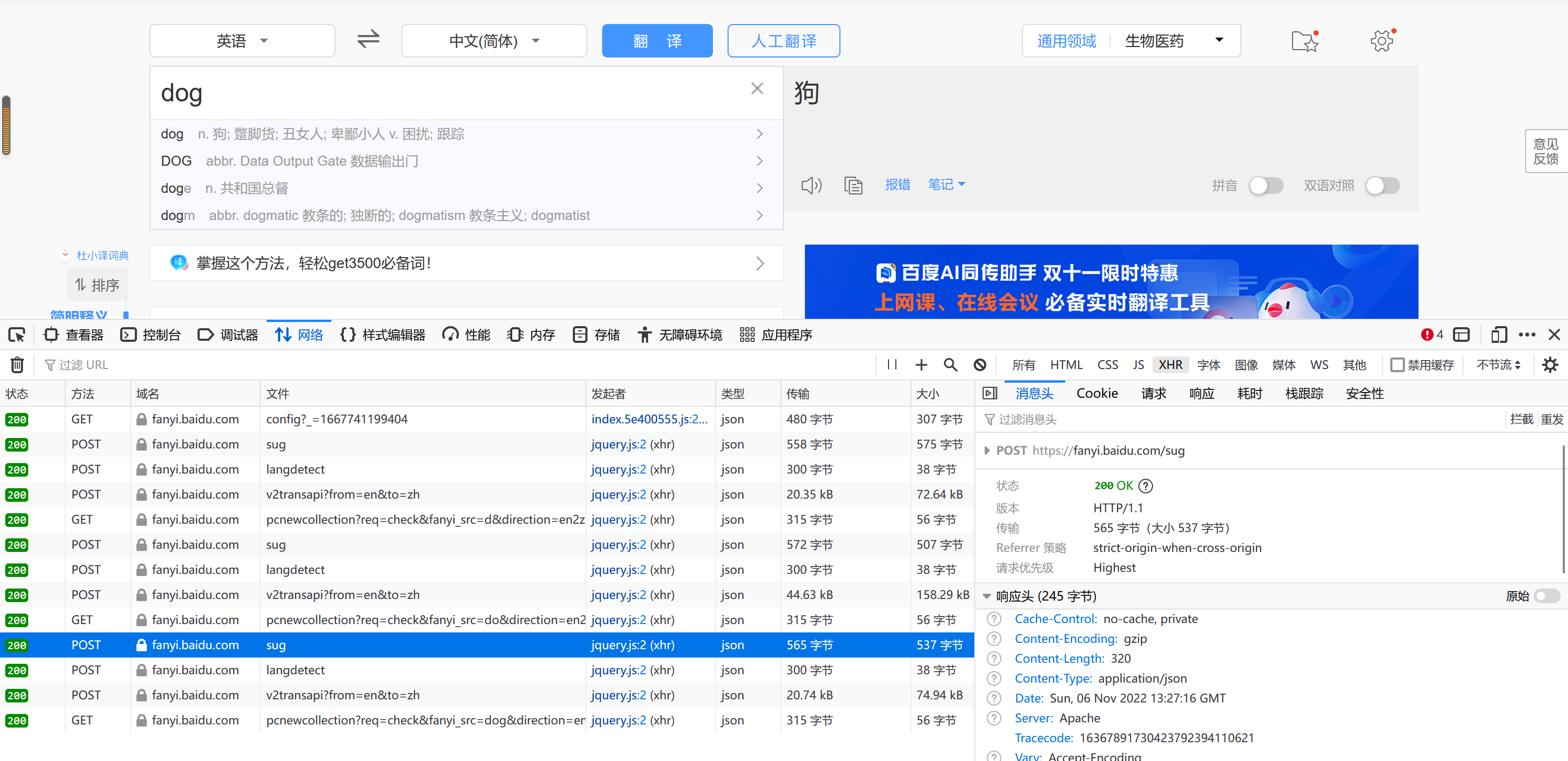

抓取ajkx包

这一步出现了一些问题,和老师的不一样,直接输入没有sug包,但是一个一个字母输入可以得到sug包

代码如下:

import requests

import json

if __name__=='__main__':

#获取url 注意此处的url为sug包里的url

url = 'https://fanyi.baidu.com/sug'

#将参数装入字典

datas = input('输入要翻译的字符:')

data = {'kw':datas}

#伪造头

headers = {

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:106.0) Gecko/20100101 Firefox/106.0'

}

#发送请求(这里使用的是post)

response = requests.post(url = url,data = data,headers = headers)

#获取数据 与之前不一样的地方

dic_obj = response.json()

#持久化存储

fp = open('./baidutrans','w',encoding='utf-8')

json.dump(dic_obj,fp=fp,ensure_ascii=False)

print('over!!!')

#fp.close()

浙公网安备 33010602011771号

浙公网安备 33010602011771号