第三次作业_软工第5组

一、观看视频后的心得

马俊腾:了解到了卷积神经网络的应用,并且在工业上的自动驾驶方面做的还好,了解到了它与传统神经网络的差异,通过参数共享等可以实现更好的模型,对卷积神经网络的基本结构有了一定的了解:卷积、池化、全连接。

蒋梦琦:线性代数,概率论,微积分是机器学习中各种模型的基础,有些模型的公式和推导过程看起来很复杂,但拆解开看会发现有随机变量,概率分布,最大似然估计,梯度下降法的公式和原理。免费午餐定理:当考虑在所有问题上的平均性能时,任意两个模型都是相同的,没有任何一个模型可以在所有的学习任务里表现最好;奥卡姆剃刀原理:“如无必要,勿增实体”。深度学习三部曲:1、搭建神经网络结构;2、找到合适的损失函数;3、找到一个合适的优化函数,更新参数;

刘瑞帅:机器学习的三要素是模型、策略、算法;进行深度学习时更像是一个数学问题,比如这次都是关于像素点展开相应的数学问题,应用到了线性代数上的矩阵等数学方法,来探讨其中的规律,进而进行相应的识别。卷积神经网络在某些问题上可以显著提升识别性能,但是对于某些特殊情况反而处于劣势,比如打乱像素顺序之后,所以CNN这个工具不能盲目的去用,关键的还是选择好正确的构建方法后再去解决相应问题,没有某个工具是所有问题的解。

任晟:pytorch的卷积神经网络:提取图片特征不需要整张图片,而是局部的区域所决定的(局部性)不同的照片可以用相同的检测模式去检测相同的特征(相同性)对于一张大图片如果我们进行下采样,那么图片的性质基本不变(不变性)输入层:一般的输入层需要能被2整出多次 卷积层:nn.Cov2d 卷积层一般得多使用比较小的滤波器,如3x3 或5x5。每次的滑动步长为1 如有需要还要进行0填充。池化层:其作用是降低数据体的空间尺寸。全连接层:将之前层的神经元全连接起来。

吴淳桐:机器学习绕不过线性代数,概率论,微积分,需要有良好的数学基础实现技术支持,机器学习三要素:模型,策略,算法,分为频率学派和贝叶斯学派,无免费午餐定理,奥卡姆剃刀原理,当考虑在所有问题上的平均性能时,任意两个模型都是相同的,没有任何一个模型可以在所有的学习任务里表现最好,卷积神经网络(CNN)由输入层、卷积层、激活函数、池化层、全连接层组成,即INPUT(输入层)-CONV(卷积层)-RELU(激活函数)-POOL(池化层)-FC(全连接层)构成

钟良胜:看完视频意识到机器学习对我们数学知识有挺高的要求,之前学习过的线性代数、概率论以及微积分都会被经常用到,然后还有没学过的信息论和最优化,了解了数据降维和低秩近似,分别可以用于压缩存储和图像去噪。第二个视频了解了卷积神经网络,它和传统神经网络的异同,通过一小块平移至整个图片来学习,同时知道了免费午餐定理和奥卡姆剃刀原理。

二、代码操作

1、MNIST数据集分类

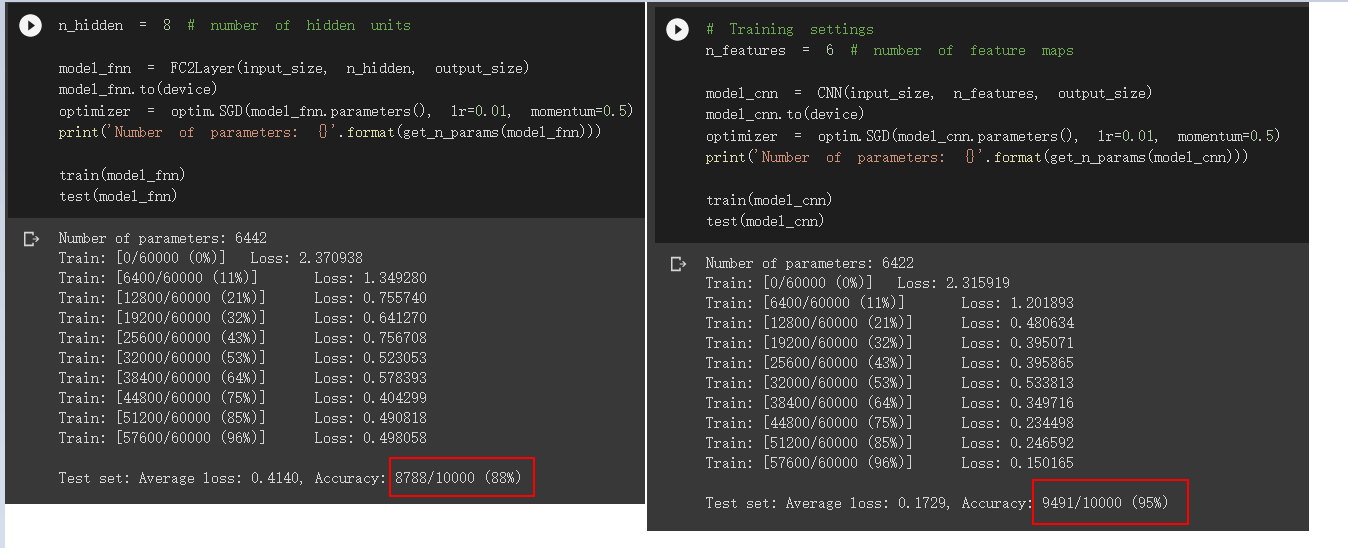

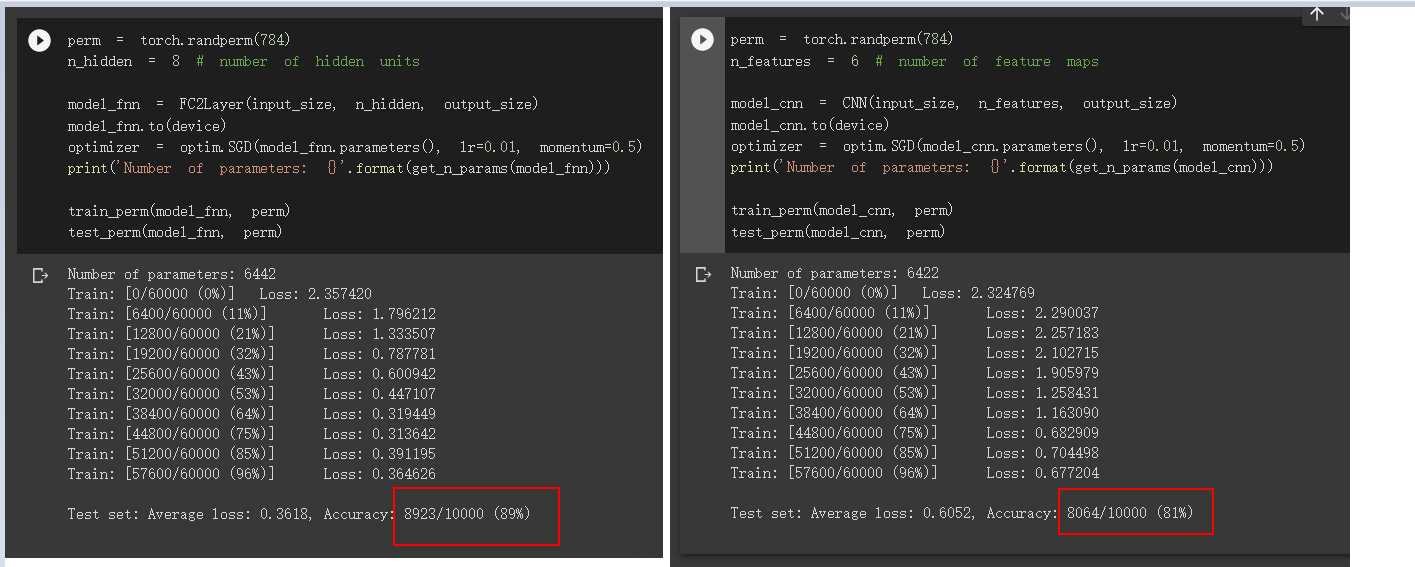

基于卷积神经网络拥有的卷积和池化手段,通过卷积神经网络进行训练,对于拥有相同数量的模型参数的情况下,效果要优于简单的全连接网络。

但是对于打乱像素顺序之后,卷积神经网络的优势荡然无存,甚至不如全连接网络的性能,这是因为卷积神经网络在训练时会利用像素的局部关系,打乱顺序后这些局部关系就变了,会极大的 影响卷积神经网络的结果。

2、使用CNN对CIFAR10数据集进行分类

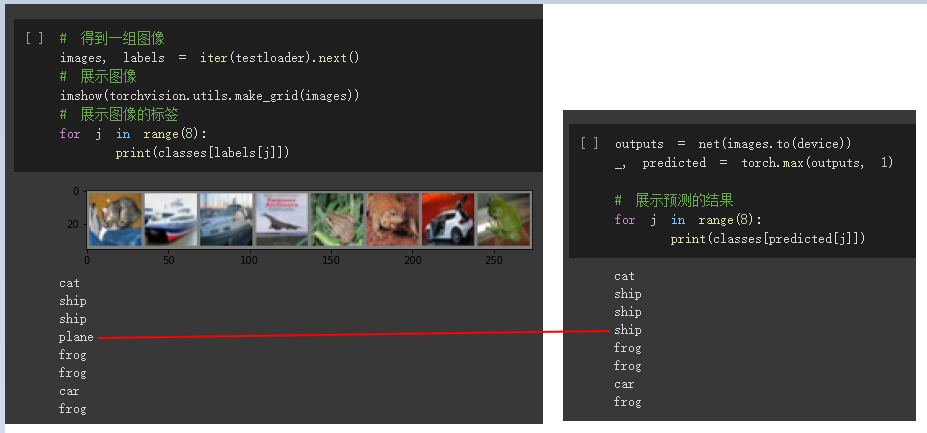

CNN识别图片并不是全对,有识别错误的情况:

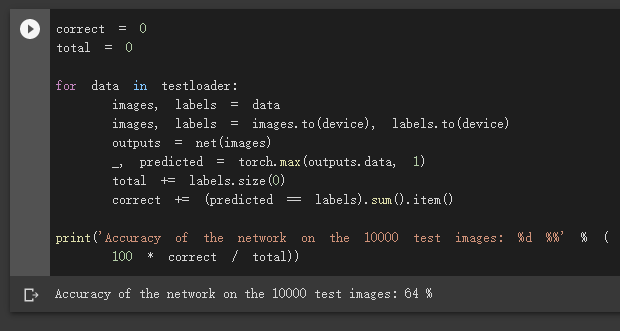

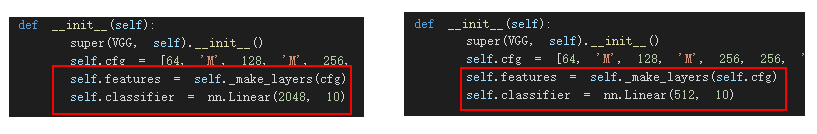

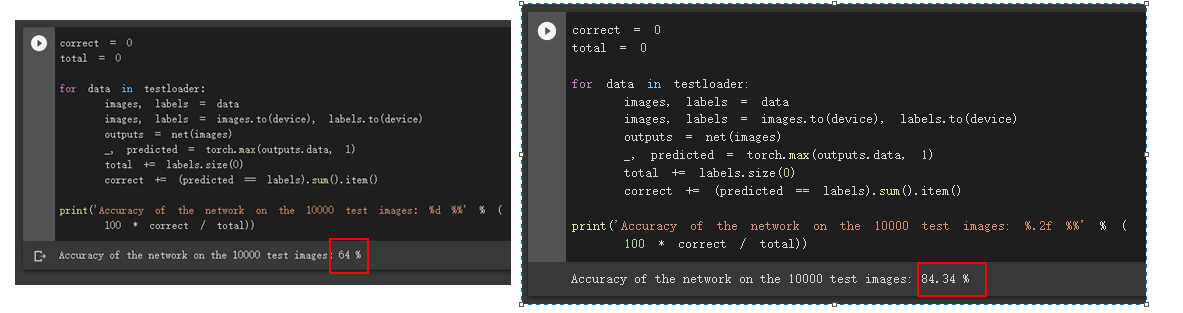

对于整个图集的识别准确率是64%

3、使用VGG16对CIFAR10分类

需要修改两处代码:

通过使用简化版的VGG16对CIFAR10分类,显著提升了识别准确率,由64%提升至了84.34%

浙公网安备 33010602011771号

浙公网安备 33010602011771号