【深度学习】|01复旦大学邱锡鹏《神经网络与深度学习》学习小笔记(二)线性模型

逻辑回归;

感知机;

损失函数;

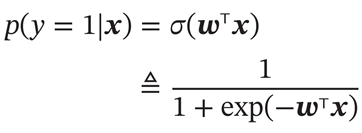

逻辑回归

1.表达式:(δ为logistic函数)

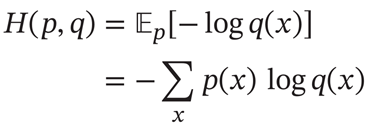

2.交叉熵:

交叉熵是按照概率分布q的最优编码对真实分布为p的信息进行编码的长度。

如果 p和 𝑞 越接近,交叉熵越小;

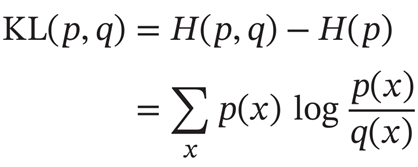

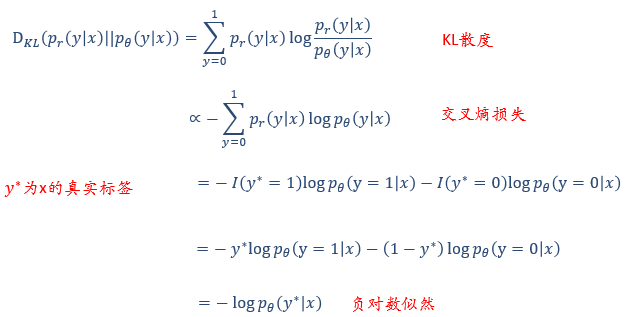

3.KL散度

KL散度是用概率分布q来近似p时所造成的信息损失量。

4.数据中(因为真实分布概率为1,所以用示性函数)

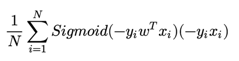

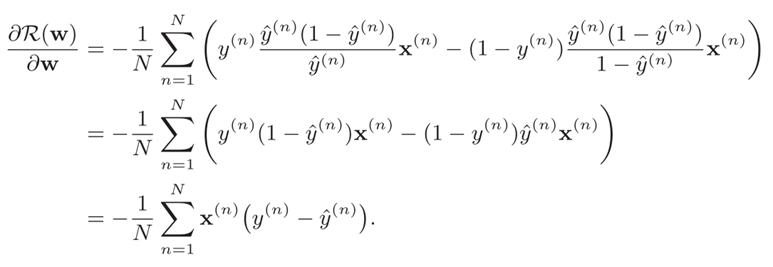

5.交叉熵的梯度表达式

【多元】

这里的交叉熵有N个类别,每个类别对应的是一个概率,因为前面有负号所以导数就省略了。

得到

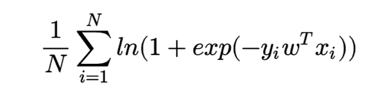

【二元】δ是logistic函数,导数为δ(1-δ)

![]()

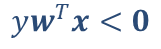

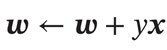

感知机

分错样本时:

这时候对w求导,梯度就是xy,所以权重更新为:

反推损失函数为:

只要线性可分,感知机就可以收敛。

总结:

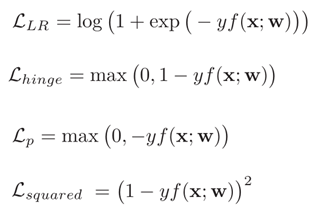

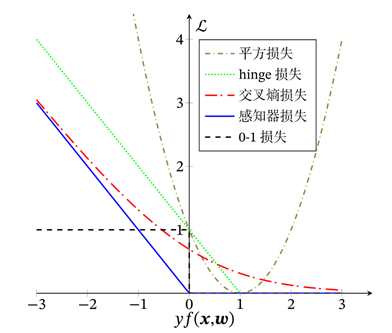

不同的损失函数:

LR损失就是交叉熵损失

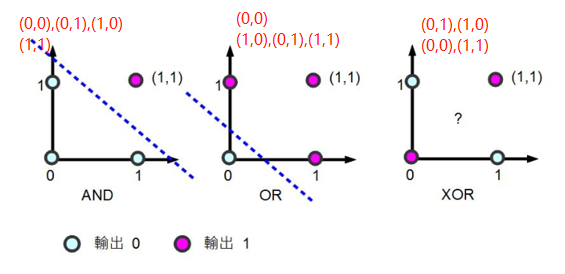

感知机的衍生问题---XOR问题【异或——非线性可分】

浙公网安备 33010602011771号

浙公网安备 33010602011771号