随笔分类 - Pytorch

摘要:

阅读全文

摘要:我们在使用pytorch的过程,经常会需要加载模型参数,不管是别人提供给我们的模型参数,还是我们自己训练的模型参数,那么加载模型参数就会碰到一些情况,即GPU模型和CPU模型,这两种模型是不能混为一谈的,下面分情况进行操作说明。 情况一:模型是GPU模型,预加载的训练参数也是GPU;模型是CPU模型

阅读全文

摘要:https://howiexue.blog.csdn.net/article/details/105412155?depth_1- tensorboardX是封装的tensorboard,因此需要安装tensorboard及tensortflow,且tensorboard版本不能太低,如1.6.0

阅读全文

摘要:import torch from torch.backends import cudnn if __name__== "__main__": print(torch.cuda.is_available()) x = torch.tensor([10.]) x = x.cuda() print(cu

阅读全文

摘要:torch.cuda.empty_cache() # 服务器的内存(主存)最大可达几十T,因此服务器上可以做到直接将所有训练数据加载到内存之后训练

阅读全文

摘要:https://www.cnblogs.com/gmpy/p/11796416.html """ python: main(argc, argv[]) argv[ ]默认的第一个参数是传进来的执行文件名,即argv[0] = xx.py ,因此argc最小是1 parser = parser 2 源

阅读全文

摘要:UniX: 用fork(分支 原生的完全并行的), 子进程从地址空间直接获得数据及python的运行配置 windows: 用spawn(产生 催生的), 另外同时并列启动多个python解释器,会分别执行被多进程策略分配的任务,同时也都会导入主进程的实现模块到自己的上下文中 所以要想兼容windo

阅读全文

摘要:conda桌面默认的装的pytorch竟然是cpu版本!!! nvidia-smi可以,但是torch.cuda.is_availabel()是False 环境依赖:python3.7+系统cuda10.1+conda环境cuda10.1+cudnn7.6.4+opencv342+pytorch1.

阅读全文

摘要:""" 两个同shape的tensor,point-wise级别元素对应比较,前者大于后者,返回位置元素为1;前者小于等于后者,返回位置元素为0 """ >>> import torch >>> a=torch.randn(2,4) >>> a tensor([[-0.5466, 0.9203, -

阅读全文

摘要:>>> import torch >>> >>> a = torch.randn(33, 55) >>> a.size() torch.Size([33, 55]) #repeat(repeat_counts_axis_0,repeat_counts_axis_1) >>> #(arg1,arg2,

阅读全文

摘要:outputs = torch.tensor([[ 0.6579, -2.1024, -0.4000], [-0.3348, -0.4195, -1.5200], [-0.3317, 0.6184, 1.7048], [-0.1368, -1.1512, -0.6306], [-0.3990, -1

阅读全文

摘要:net.eval() #评估模式,就是net.train(False)。 设置之后会对前向传播相关进行过滤,会关闭dropout BN等 #如果网络本身没有BN和dropout,那就没区别了。 net.train():默认参数是Train。model.train()会启动drop 和 BN,但是mo

阅读全文

摘要:Cuda out of memory 1.在训练循环除非必要,不要形成积累历史记录的变量 total_loss = 0 for i in range(10000): optimizer.zero_grad() output = model(input) loss = criterion(output

阅读全文

摘要:import argparse import torch #核心就是argparse类生成参数包parser实例 parser = argparse.ArgumentParser(description='PyTorch Example') #通过这个类实例的方法如add_argument添加参数属

阅读全文

摘要:https://www.cnblogs.com/biglucky/p/4305131.html 固定内存pinned memory,或者不可分页内存,它的一个重要特点是操作系统将不会对这块内存分页并交换到磁盘上,从而保证了内存始终驻留在物理内存中.也正因为如此,操作系统能够安全地使某个应用程序访问该

阅读全文

摘要:1.dataloader训练时的num_worker设置(推荐设置为1) num_workers = 0 只用主进程main process (训练程序的进程)来加载数据。主进程完成一个batch的前向后向传播,再去disk搬运下一个batch到cpu,然后再转移到GPU。 num_workers

阅读全文

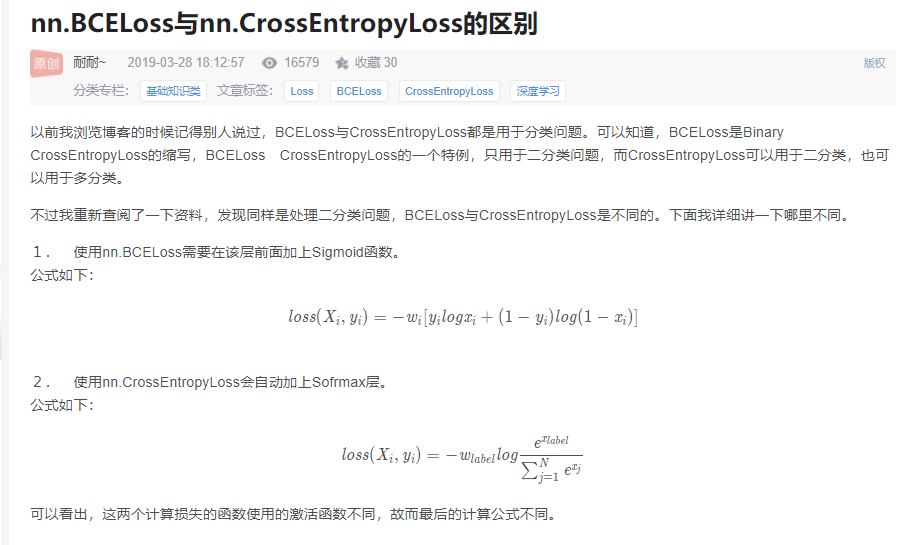

摘要:1 x = np.array([[1, 2,3,4,5],#共三3样本,有5个类别 2 [1, 2,3,4,5], 3 [1, 2,3,4,5]]).astype(np.float32) 4 y = np.array([1, 1, 0])#这3个样本的标签分别是1,1,0即两个是第2类,一个是第1类

阅读全文

摘要:30-33 ui分为四个部分: SummaryWriter.add_images 显示图片 graphs 显示网络的结构图。net——>conv1 这种 projector中可以通过add_embedding(低维嵌入)显示高维数据 scala中可以展示模型的训练的损失及预测 P_R curves可

阅读全文

摘要:前置知识:OOP-面向对象编程(核心:继承和多态) 我们知道,程序分为代码code和数据data两部分,而类完成了这两部分的封装。 面向对象的代表就是类,类的属性attribute即是封装的数据data,类的方法method即是封装的代码code. 神经网络中每一层就是面向对象编程的最好代表:层既涉

阅读全文

摘要:1.Extract: 从网络等下载图像数据集 2.Transform: 图片 >tensor 3.Loader: tensor装进数据流管道,以便获取到流出batch长度数据。() 1.torch.utils.data.datasets (Extract, Transform) 抽象类:具有必须待实

阅读全文

浙公网安备 33010602011771号

浙公网安备 33010602011771号