【论文阅读】ERNIE: Enhanced Representation through Knowledge Integration[arXiv2019]

论文地址:https://arxiv.org/pdf/1904.09223.pdf

ERNIE预训练模型代码地址:https://github.com/PaddlePaddle/ERNIE

Abstract

我们提出了一种新的由知识增强的语言表示模型,称为ERNIE(通过知识集成增强表示)。受BERT的掩蔽策略(Devlin et al.,2018)的启发,ERNIE旨在学习通过知识掩蔽策略增强的语言表达,包括实体级掩蔽和短语级掩蔽。实体级策略屏蔽通常由多个单词组成的实体。短语级策略掩盖了整个短语,而整个短语是由几个单词组成的概念单元。实验结果表明,ERNIE在自然语言推理、语义相似度、命名实体识别、情感分析和问答等五项中文自然语言处理任务中取得了新的最新成果。我们还证明了ERNIE在完形填空测试中具有更强大的知识推理能力。

1 Introduction

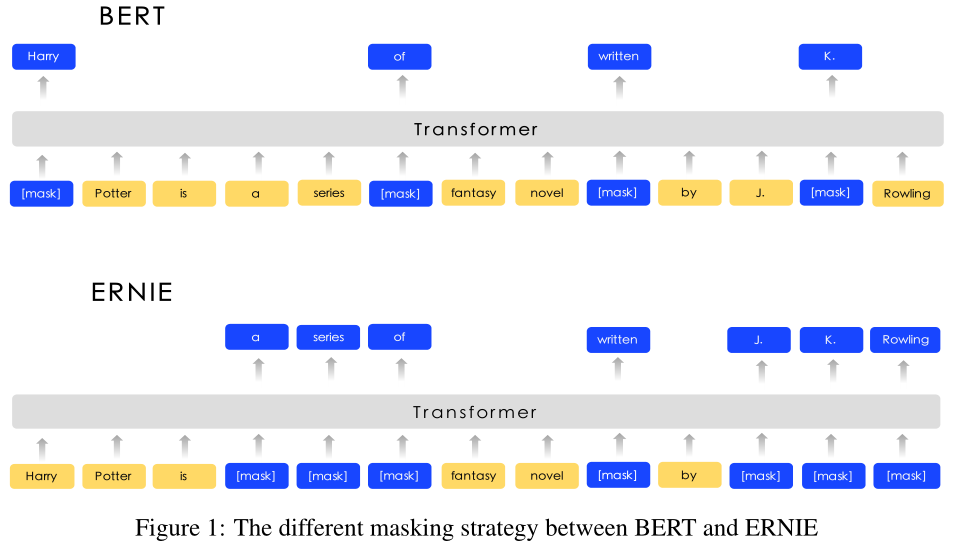

这些研究中的绝大多数只通过上下文来预测缺失词,从而建立表征模型。这些作品没有考虑句子中的先验知识。例如,在“哈利波特是J. K.罗琳写的一系列奇幻小说”这句话中。哈利·波特是一个小说名字,j·k·罗琳是作家。该模型很容易通过该实体内部的单词搭配来预测《哈利·波特》实体中缺失的单词,而无需借助长上下文的帮助。该模型不能根据《哈利·波特》和j·k·罗琳的关系来预测《哈利·波特》。可以直观地看出,如果模型学习更多的先验知识,模型就能获得更可靠的语言表示。

本文提出了一种基于知识掩蔽策略的知识集成增强表示模型(ERNIE)。除了基本的掩蔽策略外,我们还使用了两种知识策略:短语级策略和实体级策略。我们把一个短语或一个实体作为一个单位,它通常由几个词组成。在词汇表征训练中,对同一单元的所有单词进行掩码,而不是只对一个单词或字符进行掩码。通过这种方法,在训练过程中隐式学习了短语和实体的先验知识。ERNIE没有直接添加知识嵌入,而是通过隐式学习关于知识和更长的语义依赖关系的信息,如实体之间的关系、实体的属性和事件的类型,来指导词嵌入学习。使模型具有较好的泛化和适应性。

为了降低模型的训练成本,首先在异构中文数据上对ERNIE进行预训练,然后应用到5个中文自然语言处理任务中。ERNIE在所有这些任务上推进了最先进的结果。在完形填空测试上的另一个实验表明,ERNIE比其他较强的基线方法具有更好的知识推理能力。

我们的贡献如下:

(1)我们引入了一种新的语言学习模型,该模型对短语和实体等单位进行掩蔽,从这些单位隐式学习句法和语义信息。

(2)在各种中文自然语言处理任务中,ERNIE显著优于以往的先进方法。

(3)我们发布了ERNIE和预训练模型的代码

3 Methods

我们将在本节介绍ERNIE及其详细实现。我们首先描述了模型的transformer encoder,然后在3.2节介绍了知识集成方法。图1直观地显示了BERT和ERNIE之间的比较。

3.1 Transformer Encoder

ERNIE使用多层Transformer(V aswani et al., 2017)作为基本编码器,类似于以前的预训练模型,如GPT, BERT和XLM。Transformer可以通过自注意捕获句子中每个标记的上下文信息,并生成一个上下文嵌入序列。

对于中文语料库,我们在CJK Unicode范围内的每个字符周围添加空格,并使用WordPiece (Wu et al., 2016)来标记中文句子。对于给定的标记,其输入表示是通过对相应的标记、段和位置嵌入的求和来构造的summing the corresponding token, segment and position embeddings。每个序列的第一个标记是特殊分类嵌入([CLS])。

3.2 Knowledge Integration

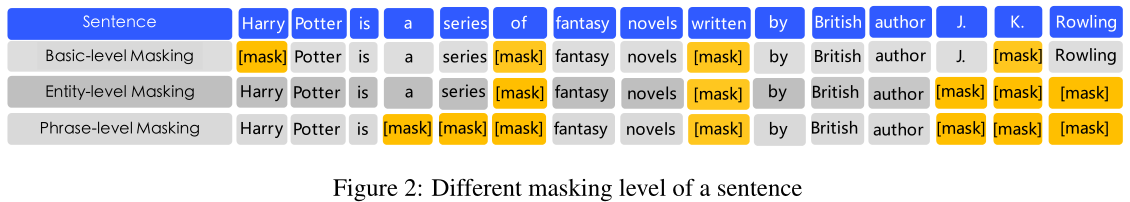

我们使用先验知识来增强预先训练的语言模型。我们没有直接添加知识嵌入,而是提出了一种多阶段知识掩蔽策略,将短语级和实体级知识集成到语言表示中。一个句子的不同掩蔽级别如图2所示。

3.2.1 Basic-Level Masking

第一个学习阶段是使用basic level masking,它将句子视为一系列基本语言单元,对于英语,基本语言单元是单词,对于汉语,基本语言单元是汉字。在训练过程中,我们随机屏蔽15%的基本语言单元,并使用句子中的其他基本单元作为输入,训练一个Transformer 来预测屏蔽单元。基于基本层掩码Based on basic level mask,我们可以得到一个基本的单词表示。因为它是在基本语义单元的随机面具上训练的,所以高层语义知识很难完全建模。

3.2.2 Phrase-Level Masking

第二阶段是使用短语级掩蔽。短语是作为一个概念单位的一小群单词或字符。对于英语,我们使用词汇分析和组块工具来获取句子中短语的边界,并使用一些与语言相关的切分工具来获取其他语言(如汉语)中的单词/短语信息。在短语级掩码阶段,我们还使用基本语言单元作为训练输入,与随机基本单元掩码不同,这次我们随机选择句子中的几个短语,掩码并预测同一短语中的所有基本单元mask and predict all the basic units in the same phrase.。在此阶段,短语信息被编码到单词嵌入中。

3.2.3 Entity-Level Masking

第三阶段是实体级掩蔽。名称实体包含人员、地点、组织、产品等,可以用适当的名称表示。它可以是抽象的,也可以是物理存在的。实体通常包含句子中的重要信息。在短语掩蔽阶段,我们首先分析句子中的命名实体,然后掩蔽和预测实体中的所有插槽then mask and predict all slots in the entitie。经过三个阶段的学习,得到了语义信息更丰富的词语表征。

4 Experiments

为了便于比较,选择ERNIE的模型尺寸与BERT base相同。ERNIE使用12个编码器层、768个隐藏单元和12个注意头

4.1 Heterogeneous各种各样的 Corpus Pre-training

ERNIE采用异构语料库进行预训练。接下来(Cer et al,2018年),我们绘制了中文维基百科、百度百科、百度新闻和百度贴吧的混合语料库。句子的数量分别是2100万、5100万、4700万、5400万。分别地百度百科包含以正式语言编写的百科全书文章,这是语言建模的有力基础。百度新闻提供关于电影名字、演员名字、足球队名字等的最新信息。百度贴吧是一个类似Reddits的开放式讨论论坛,每个帖子都可以被视为一条对话线索。Tieba语料库用于我们的DLM任务,将在下一节讨论。

我们对汉字执行传统到简化的转换traditional-to-simplified,对英文字母执行从大写到小写upper-to-lower的转换。我们在模型中使用了17964个unicode字符的共享词汇表。

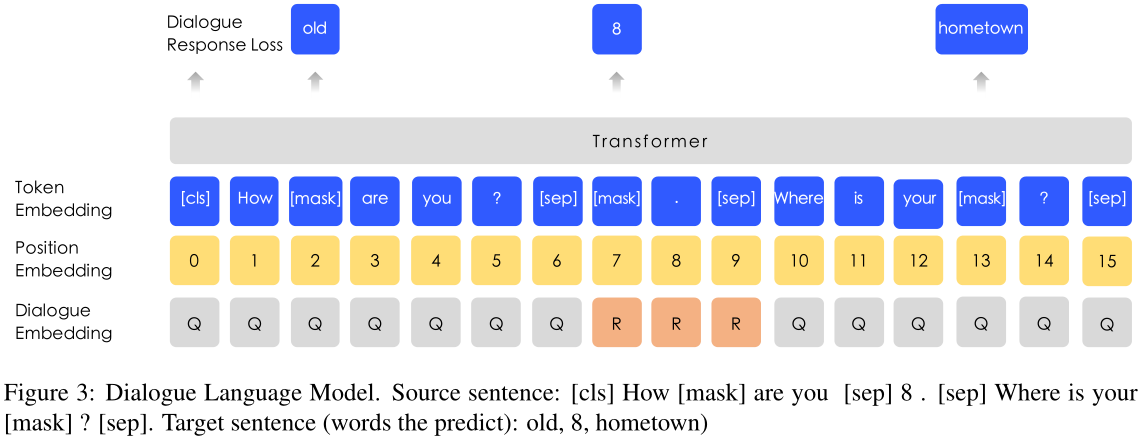

4.2 DLM

对话数据对于语义表示很重要,因为相同回复的相应查询语义通常相似。ERNIE在DLM(对话语言模型)任务上对查询-响应对话结构进行建模。如图3所示,我们的方法引入了对话嵌入来识别对话中的角色,这不同于通用句子编码器(Cer等人,2018)。ERNIE的对话嵌入与BERT中的令牌类型嵌入的作用相同,只是ERNIE也可以表示多回合对话(例如,QRQ、QRR、QQR,其中Q和R分别表示“查询”和“响应”)。与BERT中的MLM一样,掩码被应用于强制执行模型,以预测查询和响应条件下的缺失单词。此外,我们通过用随机选择的句子替换查询或响应来生成假样本。该模型用于判断多轮会话是真是假。

DLM任务帮助ERNIE学习对话中的隐含关系,这也增强了模型学习语义表示的能力。DLM任务的模型体系结构与MLM任务的模型体系结构兼容,因此与MLM任务交替进行预训练。

4.3 Experiments on Chinese NLP Tasks

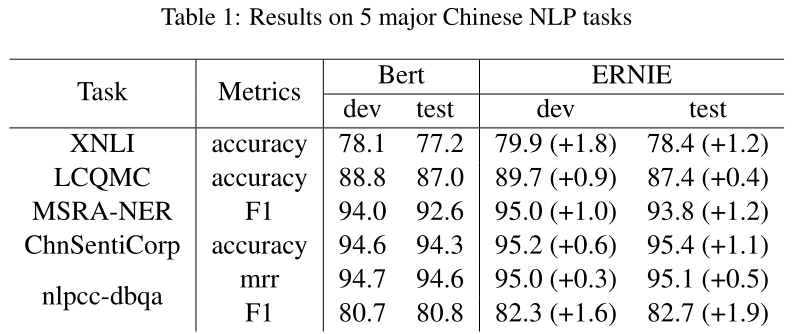

ERNIE应用于自然语言推理、语义相似度、命名实体识别、情感分析和问答等5项中文NLP任务。

4.3.1 Natural Language Inference

跨语言自然语言推理Cross-lingual Natural Language Inference(XNLI)语料库(Liu等人,2019年)是多NLI语料库的众包集合。这两对被注释为文本蕴涵,并被翻译成包括中文在内的14种语言。标签包含矛盾性、中立性和蕴涵性。我们在BERT中进行了中文实验(Devlin等人,2018年)。

4.3.2 Semantic Similarity语义相似性

大规模汉语问题匹配语料库(LCQMC)(Liu et a;,2018)旨在识别两个句子是否具有相同的意图。数据集中的每一对句子都与一个二进制标签相关联,指示这两个句子是否具有相同的意图,并且任务可以形式化为预测一个二进制标签。

4.3.3 Name Entity Recognition

MSRA-NER数据集是为命名实体识别而设计的,由微软亚洲研究院发布。实体包含多种类型,包括人名、地名、组织名称等。此任务可视为序列标记任务。

4.3.4 Sentiment Analysis

CHNSTINCorp(Song bo)是一个旨在判断句子情感的数据集。它包括酒店、书籍和电子计算机等多个领域的评论。这项任务的目标是判断句子是肯定的还是否定的。

4.3.5 Retrieval Question Answering检索问答

NLPCC-DBQA数据集(http://tcci.ccf.org.cn/conference/2016/dldoc/evagline2.pdf)的目标是选择相应问题的答案。该数据集的评估方法包括MRR(Voorhees,2001)和F1分数。

4.4 Experiment results

表1给出了5个中文NLP任务的测试结果。可以看出,ERNIE在所有任务上都优于BERT,在这些中文NLP任务上创造了最新的结果。对于XNLI、MSRA-NER、CHNSTINCORP和nlpccdbqa任务,ERNIE的绝对精度比BERT提高了1%以上。ERNIE的成功得益于其知识整合战略。

4.5 Ablation Studies

为了更好地理解ERNIE,我们在本节中对ERNIE的每种策略进行了消融实验

4.5.1 Effect of Knowledge Masking Strategies

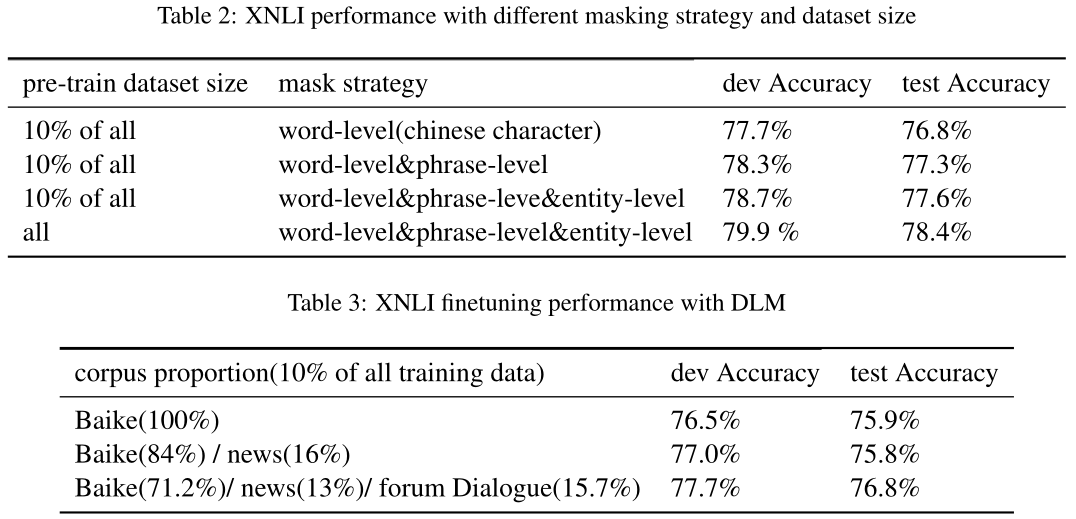

我们从整个语料库中抽取10%的训练数据来验证知识掩蔽策略的有效性。结果如表2所示。我们可以看到,将短语级掩码添加到基线单词级掩码可以提高模型的性能。在此基础上,增加了实体级掩蔽策略,进一步提高了模型的性能。此外结果还表明,当预训练数据集的大小增加10倍时,XNLI测试集的性能提高了0.8%。

4.5.2 Effect of DLM

消融研究也在DLM任务中进行。我们使用10%的不同比例的训练语料来说明DLM任务对XNLI开发集的贡献。我们在这些数据集上从头开始预先训练ERNIE,并报告从5次随机重新启动微调到XNLI任务的平均结果。详细的实验设置和开发集结果如表3所示,我们可以看到,在这个DLM任务中,开发/测试精度提高了0.7%/1.0%。

4.6 Cloze Test完形填空

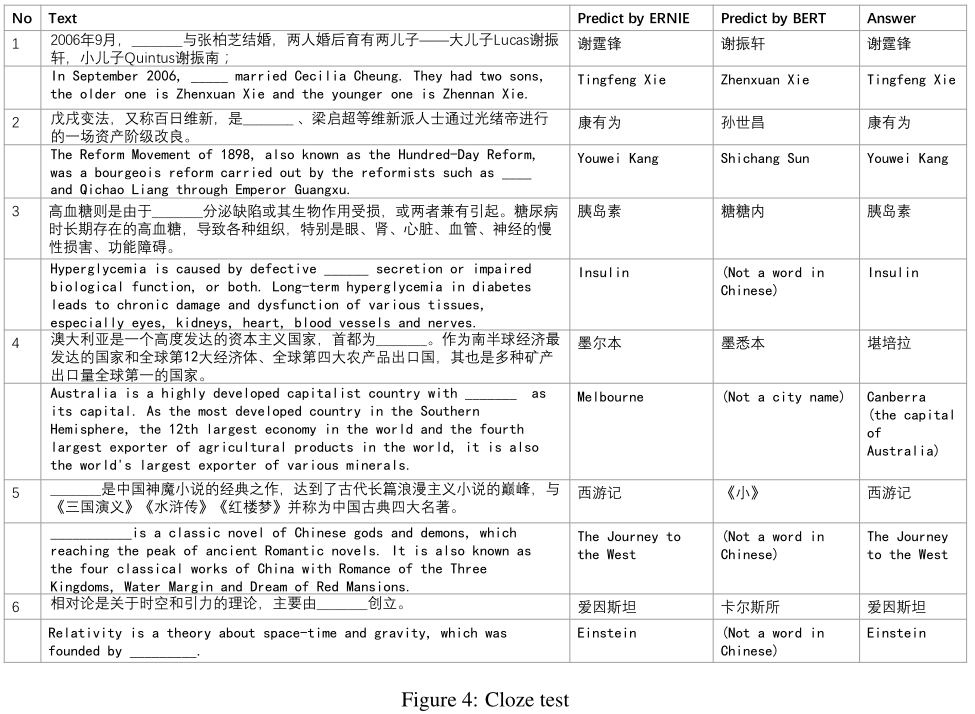

为了验证ERNIE的知识学习能力,我们使用了几个完形填空测试样本(Taylor,1953)来检验模型。在实验中,名称实体从段落中删除,模型需要推断它是什么。图4显示了一些情况。我们比较了BERT和ERNIE的预测。

在案例1中,BERT试图复制上下文中出现的名称,而ERNIE记得文章中提到的关于关系的知识。在案例2和案例5中,BERT可以根据上下文成功地学习模式,因此可以正确预测命名实体类型,但无法使用正确的实体填充插槽。相反,ERNIE可以用正确的实体填充插槽。在案例3、4、6中,BERT用几个与句子相关的字符填充空格,但很难预测语义概念。ERNIE预测了除案例4之外的正确实体。尽管ERNIE在案例4中预测了错误的实体,但它可以正确预测语义类型,并用一个澳大利亚城市的实体来填补空缺。总之,这些案例表明ERNIE在基于上下文的知识推理中表现得更好。

5 Conclusion

在本文中,我们提出了一种将知识整合到预训练语言模型中的新方法。在5个中文处理任务上的实验表明,我们的方法在所有这些任务上都优于BERT方法。我们还证实了知识集成和对异构数据的预训练都能使模型获得更好的语言表示。

在未来,我们将把其他类型的知识集成到语义表示模型中,例如使用句法分析或来自其他任务的弱监督信号。此外,我们还将在其他语言中验证此想法。

浙公网安备 33010602011771号

浙公网安备 33010602011771号