实习中遇到的问题(1)

什么是BatchNormalization?

1、先取平均值

2、计算sigama

2.1、sigama计算方式是见图中公式

3、每一项减去平均值然后除以sigama

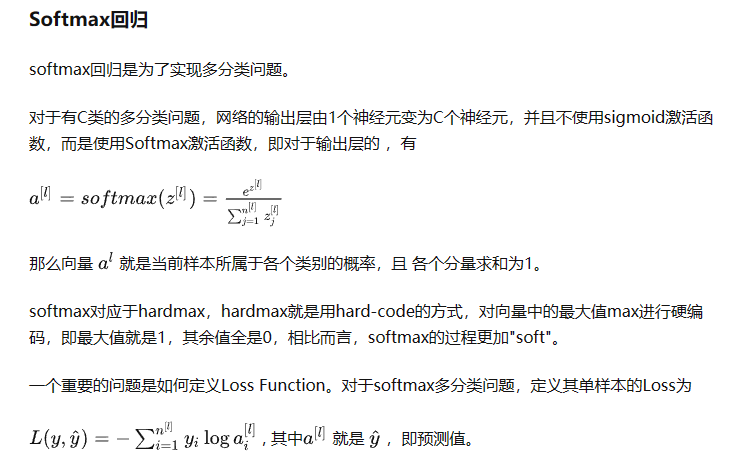

什么是Softmax?

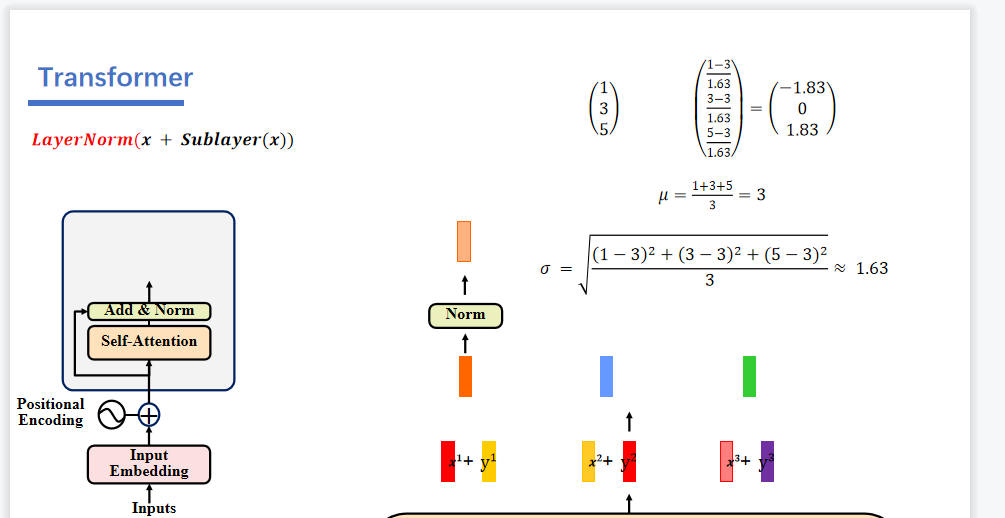

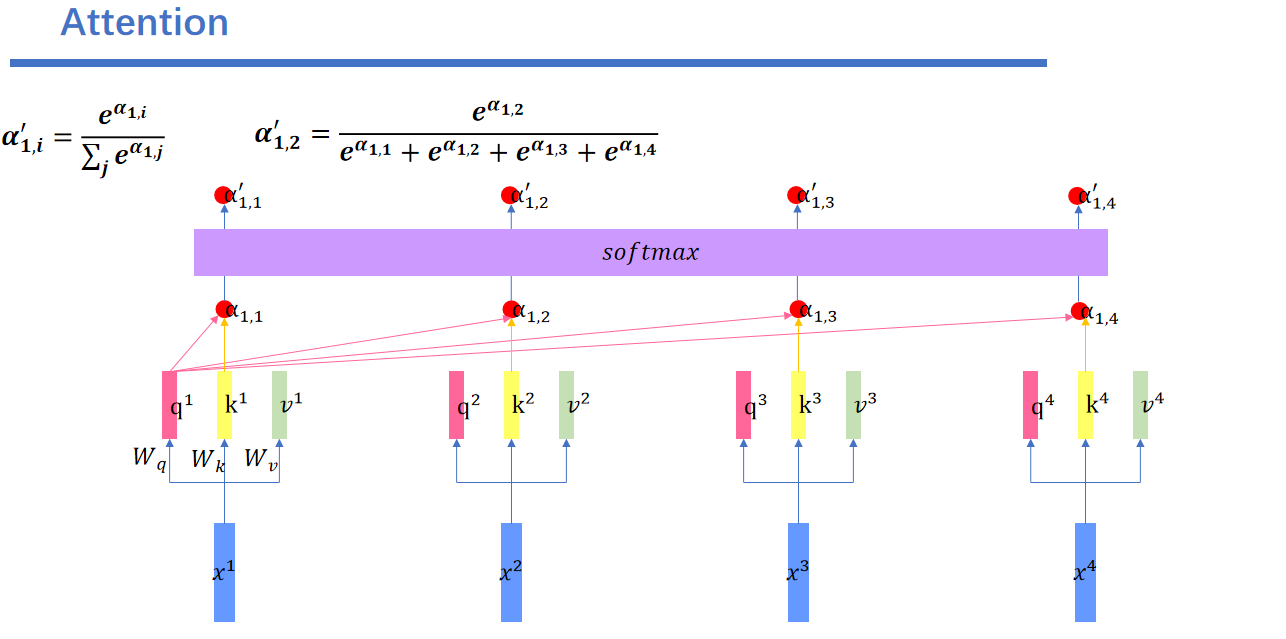

什么是Attention和Transformer?

最近在重新学习和认识Attention和Transformer,看到一个视频讲的很详细,是从矩阵计算角度讲的。

Attention、Transformer公式推导和矩阵变化_哔哩哔哩_bilibili

当然理论讲解当然是李宏毅老师讲的比较好一些

强烈推荐!台大李宏毅自注意力机制和Transformer详解!_哔哩哔哩_bilibili

还有一篇博客也不错:Transformer 模型详解及代码实现 - 知乎 (zhihu.com)

浙公网安备 33010602011771号

浙公网安备 33010602011771号