决策树系:ID3,C4.5,CART

三大评价指标

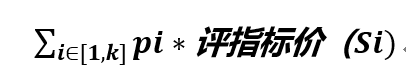

决策树系列算法都是在给定的集合S,假定按照某个特征A进行划分,选出这个特征A对应的最佳划分值进行划分,得到划分之后的一些集合S1,S2..以及数据被划分到对应各个集合的概率为P1,P2...,这样我们就可以根据评价指标如信息增益/信息增益率/GINI指数算出划分之后对应的所有累计值

这样针对每个假定的特征都有一个划分之后的累计的评价值,选出里面最优的特征作为该S集的最优特征划分。

信息增益(ID3)

选择最大信息增益对应的属性来划分(因为信息增益越大,区分样本的能力就越强,越具有代表性,很显然这是一种自顶向下的贪心策略)。

ID3的2个缺点:

(1).用信息增益选择属性时偏向于选择分枝比较多的属性值,即取值多的属性

(2).不能处理连贯属性

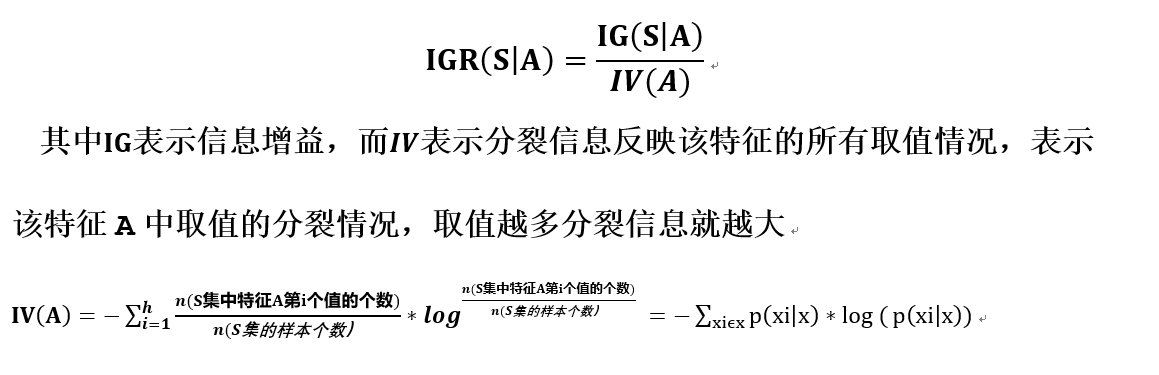

信息增益率(C4.5)

选择最大信息增益率对应的属性来划分(因为信息增益率越大,区分样本的能力就越强,越具有代表性,很显然这是一种自顶向下的贪心策略)。

C4.5克服了ID3的2个缺点:

(1).用信息增益选择属性时偏向于选择分枝比较多的属性值,即取值多的属性

(2).不能处理连贯属性

缺点是:在构造树的过程中,需要对数据集进行多次的顺序扫描和排序,因而导致算法的低效。

信息增益率通过用属性的分裂信息来惩罚取值较多的属性,解决信息增益在属性选择的时候比较偏向选择取值较多的属性问题,但是它也有可能导致过分惩罚而选择那些信息很小的属性(信息增益较小,此时有可能该属性的分裂信息也较小,使得信息增益率较大)

信息增益率的改进:

在求出各个属性的信息增益的时候,我们仅考虑那些信息增益超过平均值的属性,然后针对这些属性来比较他们的信息增益率。

GINI指数(CART回归树)

GINI指数就是用来衡量某个属性的某个取值的所包含的类别杂乱的程度即按照这个属性划分得到的子集所包含的类别杂乱的程度。GINI指数就越小,划分出来的子集对应的类别比较集中在某个类别中,GINI指数就越大类别越分散。

对应的GINI增益

我们在选择最优的属性划分就是找GINI_Gain最小的属性。

决策树主要分为两个部分,一个是建立决策树,另外一个是为防止出现过拟合的现象,需要对决策树进行剪枝过程

建树过程按照某种评价指标(GINI指数,熵等等)在数据集中选择出最优的属性进行划分,看这个属性每种取值作为一条分支,即在每个分支上该属性的值都一样,这样每个分支又形成了新的数据集,重复的递归进行最优属性划分,直到数据集满足某种限制性约束条件(或者是该数据集只含某个类别)停止,贴上对应的类别标签。

剪枝过程:分为前剪枝(在建决策树的过程中通过某种限制性约束条件来提前终止)和后剪枝(构建好了决策树,再来剪去一些相对来说无关紧要的枝),这里列出几种方法:

1)、REP (Reduced-Error Pruning,错误率降低剪枝)

2)、PEP (Pessimistic Error Pruning,悲观错误剪枝)

C4.5算法用到的剪枝,他是一种后剪枝算法。

3)、CCP (Cost-Complexity Pruning,代价复杂度)

浙公网安备 33010602011771号

浙公网安备 33010602011771号