大数据,十有八九挂在装环境上(3)

有了hive。再来一个impala

1. 准备一个源,方便后面拉取安装包

#yum⽅方式安装httpd服务器器

yum install httpd -y

#启动httpd服务器器

systemctl start httpd

#验证httpd⼯工作是否正常,默认端⼝口是80,可以省略略

http://centos7-1

显示testing123 就对了

2. 准备依赖包

把impala安装包放到指定目录下

/opt/lagou/software

解压安装包

tar -zxvf cdh5.7.6-centos7.tar.gz

创建软链接

ln -s /opt/lagou/software/cdh/5.7.6 /var/www/html/cdh57

验证一下:

http://centos7-1/cdh57/

如果403

那就是

vim /etc/selinux/config

里面的SELINUX=disabled

记得重启机器!!

修改yum源的配置文件

cd /etc/yum.repos.d #创建⼀一个新的配置⽂文件 vim local.repo #添加如下内容 [local] name=local baseurl=http://centos7-1/cdh57/ gpgcheck=0 enabled=1

修改一台,剩下机器分发

rsync-script local.repo

集群规划

| 服务器名称 | centos7-1 | centos7-2 | centos7-3 |

| impala-catalogd | × | × | ✔ |

| impala-statestored | × | × | ✔ |

| impala-server | ✔ | ✔ | ✔ |

在centos7-3安装

yum install impala -y yum install impala-server -y yum install impala-state-store -y yum install impala-catalog -y yum install impala-shell -y

在centos7-1,centos7-2安装

yum install impala-server -y yum install impala-shell -y

安装完成impala

需要配置hive

修改hive-site.xml

cd /opt/lagou/servers/hive-2.3.7/conf/

vim hive-site.xml <!--指定metastore地址,之前添加过可以不不⽤用添加 --> <property> <name>hive.metastore.uris</name> <value>thrift://centos7-1:9083,thrift://centos7-3:9083</value> </property> <property> <name>hive.metastore.client.socket.timeout</name> <value>3600</value> </property>

然后把hive安装包分发到其他节点去

cd /opt/lagou/servers

rsync -r /opt/lagou/servers/hive-2.3.7/ centos7-2:/opt/lagou/servers/ rsync -r /opt/lagou/servers/hive-2.3.7/ centos7-1:/opt/lagou/servers/

或者

rsync-script hive-2.3.7/

centos7-3启动metastore服务

nohup hive --service metastore &

启动hiveserver2服务

nohup hive --service hiveserver2 &

配置短路读取

1. 创建短路路读取本地中转站(所有节点都要)

mkdir -p /var/lib/hadoop-hdfs

2. 修改hdfs-site.xml

cd /opt/lagou/servers/hadoop-2.9.2/etc/hadoop/

vi hdfs-site.xml

<!--添加如下内容 --> <!--打开短路路读取开关 --> <!-- 打开短路路读取配置--> <property> <name>dfs.client.read.shortcircuit</name> <value>true</value> </property> <!--这是⼀一个UNIX域套接字的路路径,将⽤用于DataNode和本地HDFS客户机之间的通信 --> <property> <name>dfs.domain.socket.path</name> <value>/var/lib/hadoop-hdfs/dn_socket</value> </property> <!--block存储元数据信息开发开关 --> <property> <name>dfs.datanode.hdfs-blocks-metadata.enabled</name> <value>true</value> </property> <property> <name>dfs.client.file-block-storage-locations.timeout</name> <value>30000</value> </property>

分发到其他节点上

rsync-script hdfs-site.xml

重启hadoop集群

#停⽌止集群 stop-dfs.sh start-dfs.sh #启动集群 start-dfs.sh start-yarn.sh

起不来??一个大坑

cd /var/lib chown -R root:root ./hadoop-hdfs/

impala安装完之后如果hive用不了了就吧hive的mysql中的hive版本写成咱们的hive版本,这个是一个问题datanode,还有一个是var/lib下有个自己创建的文件的权限改成root:root用户和用户组。还有讲义上的消除影响的操作也操作一下,其他就没了,主要就这3点

lmpala具体配置

引用hdfs,hive配置

需要软连接到一个地方,所有节点都要

ln -s /opt/lagou/servers/hadoop-2.9.2/etc/hadoop/core-site.xml /etc/impala/conf/core-site.xml ln -s /opt/lagou/servers/hadoop-2.9.2/etc/hadoop/hdfs-site.xml /etc/impala/conf/hdfs-site.xml ln -s /opt/lagou/servers/hive-2.3.7/conf/hive-site.xml /etc/impala/conf/hive-site.xml

# 检查一下

cd /etc/impala/conf

impala自身配置

vi /etc/default/impala <!--更更新如下内容 --> IMPALA_CATALOG_SERVICE_HOST=centos7-3 IMPALA_STATE_STORE_HOST=centos7-3

安排上mysql的驱动包软连接

#创建节点 mkdir -p /usr/share/java ln -s /opt/lagou/servers/hive-2.3.7/lib/mysql-connector-java-5.1.46.jar /usr/share/java/mysql-connector-java.jar

修改bigtop的java_home路径

vim /etc/default/bigtop-utils export JAVA_HOME=/opt/lagou/servers/jdk1.8.0_231

启动impala

#centos7-3启动如下⻆角⾊色 service impala-state-store start service impala-catalog start service impala-server start #其余节点启动如下⻆角⾊色 service impala-server start

验证:

ps -ef|grep impala

或者访问

impala-statestored: http://centos7-3:25010/

impalad: http://centos7-1:25000/

消除impala影响

rm -rf /usr/bin/hadoop rm -rf /usr/bin/hdfs rm -rf /usr/bin/hive rm -rf /usr/bin/beeline rm -rf /usr/bin/hiveserver2 #重新⽣生效环境变量量 别忘了!!! source /etc/profile

对于jps没有显示进程名字,解决方法

rm -rf /tmp/hsperfdata_*

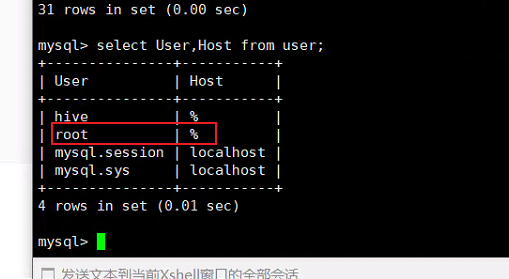

然后就是hive不能select * from xxx;了

mysql -uroot -p12345678 show databases; use mysql; show tables; select User,Host from user;

改了这个

浙公网安备 33010602011771号

浙公网安备 33010602011771号