GaussDB关键技术原理:高可用之逻辑复制深度解析

GaussDB关键技术原理:高可用之逻辑复制深度解析

引言

在分布式数据库领域,高可用性(High Availability)是衡量系统可靠性的核心指标。华为云GaussDB通过创新的逻辑复制技术,在保证数据一致性的前提下,实现了跨地域、跨AZ的实时数据同步与故障自动切换。本文将深入剖析GaussDB逻辑复制的底层原理、架构设计及实战应用,揭示其如何突破传统复制技术的瓶颈,成为金融、物联网等高要求场景的首选方案。

一、逻辑复制的核心概念

逻辑复制是一种基于数据逻辑变化的异步复制技术,其核心在于:

数据单元粒度:以事务(Transaction)或日志条目(Log Entry)为单位传输,而非物理数据块。

语义一致性:通过解析数据库日志(如PostgreSQL WAL、MySQL Binlog),捕获数据变更的语义信息。

异步解耦:主节点与备节点间通过日志队列异步同步,降低主节点性能损耗。

与传统复制的对比:

特性 逻辑复制 物理复制(如存储镜像)

数据粒度 事务/日志条目 物理数据块

跨版本兼容性 支持(如PG 12→14) 不支持

网络带宽占用 低(仅传输语义信息) 高(全量数据块传输)

故障恢复速度 依赖日志重放 秒级磁盘切换

二、GaussDB逻辑复制架构设计

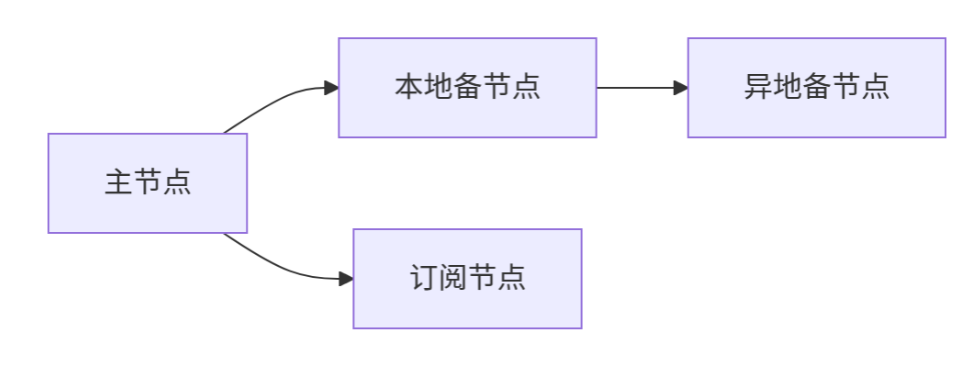

- 分层复制模型

GaussDB采用三级复制架构,实现端到端的高可用保障:

本地主备复制:

主节点(Primary)将WAL日志实时同步至本地备节点(Standby)。

通过Paxos协议确保本地两副本强一致性。

跨AZ同步复制:

本地备节点作为跨AZ同步的发起端,将日志传输至异地备节点。

采用Raft协议实现多副本全局一致性。

全局订阅复制:

支持第三方订阅者(如分析节点、备份节点)订阅增量数据流。

- 日志解析与语义还原

日志捕获:

GaussDB内置日志解析引擎,实时读取WAL日志并提取语义信息(如SQL操作类型、数据行变更)。

-- 示例:解析INSERT操作日志

{ "op": "INSERT", "table": "orders", "data": {"id": 1001, "user_id": "U001", "amount": 299.9} }

事务重组:

将离散的日志条目按事务边界重组,确保备节点执行的操作与主节点完全一致。 - 流量控制与故障恢复

并行复制:

根据事务依赖关系,将日志分片至多个复制线程,提升同步效率。

# 伪代码:事务分片策略

def split_transaction(txn):

if txn.dependencies == []:

assign_to_thread(txn, thread_0)

else:

assign_to_thread(txn, thread_depend(txn))

断点续传:

记录复制进度(LSN日志序列号),网络中断后自动从断点恢复,避免数据重传。

冲突检测:

通过全局时间戳服务解决跨地域复制的数据冲突(如最后写入获胜LWW策略)。

三、高可用场景下的技术突破

- 多级容灾能力

同城双活:

本地主备节点通过内存级同步(RDMA网络),RPO=0,RTO<30秒。

异地多活:

跨AZ节点采用异步日志复制,支持秒级故障切换,RTO<3分钟。 - 自动故障转移

心跳检测:

每5秒检测主节点健康状态(心跳包+SQL探针)。

VIP漂移:

故障时自动将虚拟IP(VIP)迁移至新主节点,客户端无感知。

# VIP漂移脚本示例

if ping -c 1 primary-node; then

return 0

else

ip addr del vip/24 dev eth0

ip addr add vip/24 dev standby-node

fi

- 数据一致性保障

全局一致性校验:

定期执行CRCC校验(循环冗余校验),比对主备节点数据哈希值。

回放补偿机制:

对因网络抖动丢失的日志,通过时间窗口回溯补全缺失数据。

四、性能优化与工程实践

- 复制延迟控制

动态批处理:

根据网络延迟动态调整日志批量发送大小(1KB~1MB)。

优先级队列:

将DDL操作(如ALTER TABLE)置于高优先级队列,避免阻塞DML复制。 - 资源隔离策略

cgroups硬隔离:

限制复制线程的CPU/内存占用,防止影响主节点事务处理。

QoS限速:

在业务高峰期间,自动降速非关键复制流量(如统计信息同步)。 - 实战案例:金融核心系统

需求:银行核心交易系统要求RPO=0,RTO<30秒。

方案:

本地双活部署,Paxos同步内存数据。

异地容灾节点通过逻辑复制同步,Raft协议保证全局一致性。

每日全量备份 + 实时日志归档。

效果:

2023年双十一期间,成功应对每秒10万+TPS交易,零数据丢失。

单次故障切换耗时28秒,业务影响<5秒。

五、逻辑复制的适用场景与局限

- 最佳实践场景

跨地域容灾:如金融行业两地三中心部署。

读写分离:将分析类查询分流至只读副本,降低主库负载。

云原生混合架构:本地IDC与公有云节点异步同步。 - 局限性

数据延迟容忍度:异步复制存在毫秒级延迟,不适用于强一致性场景。

日志解析开销:复杂SQL操作可能增加主节点CPU消耗(典型值<5%)。

结语

GaussDB的逻辑复制技术通过语义级数据同步、多级容灾架构与智能流量控制,实现了高可用性与性能的平衡。其核心价值在于:

敏捷性:分钟级跨地域部署,支撑业务全球化扩展。

经济性:相比物理复制,带宽成本降低70%。

可持续性:兼容数据库版本升级,避免技术锁仓。

在未来,随着GaussDB与AI运维的深度结合,逻辑复制将进一步向自适应调优演进——系统自动感知负载波动,动态调整复制策略,真正实现“无感容灾”。这一技术将持续赋能企业数字化转型,成为数据高可用的基石。

浙公网安备 33010602011771号

浙公网安备 33010602011771号