来源:南大wangzhi团队工作(NIPS2024)

arxiv 主要工作:

类似于Pearl,设计了任务特征提取网络\(E_{\phi}\) 作为context encoder,将提出的z作为辅助信息输入DT

建立任务的world model,在context encoder的基础上还训练了Reward Decoder和Transition Decoder

针对Prompt-DT需要高质量demonstration的缺点,从Agent的历史输出中选取K个连续元组,要求这K个元组与世界模型的预测的差异最大,以作为z的补充信息,这k个元组将作为complementary Prompt输入Meta DT

个人看法:(1)针对每个环境中每个场景训练单独的model,只不过是不同的任务,并未体现很强的泛化性和meta? (2)消融实验说明了MetaDT的主要提升源自context-encoder,与world model和complementary prompt没太大关系

Diffusion model is an effective planner and data synthesizer for multi-task reinforcement learning

Text-to-Decision Agent: Offline Meta-Reinforcement Learning from Natural Language Supervision

来源:ICLR2025 Poster

OpenReview key insight: Decision Convformer擅长处理和提取局部短期关联,但不擅长提取长期依赖,尤其是面对由非MDP产生的RL数据集,Decision Transformer擅长提取长期依赖,但对局部关联的敏感度不足。很自然,这篇文章提出LSDR,同时融合self-attention和Dynamic Convolution机制,提取长期和短期依赖。

method: 1、受NLP和CV领域双分支架构的启发,LSDT采用相似的策略。将输入从维度上分开(超参数)分别输入两个分支。2、DT中仅使用RTG表征目标对于目标变化的任务如路径规划是不足的,因此LSDT添加了Goal-State Conditioning.比如原有Goal只是1,而Goal state则表示目标state.即S’=(S,g)

来源:逛arxiv

arxiv 理论分析类文章,不太理解这里的Intrinsic motivation究竟是什么?实验设计也比较简单,与EDT相比无明显提升

来源:上一篇提到[NIPS2023]

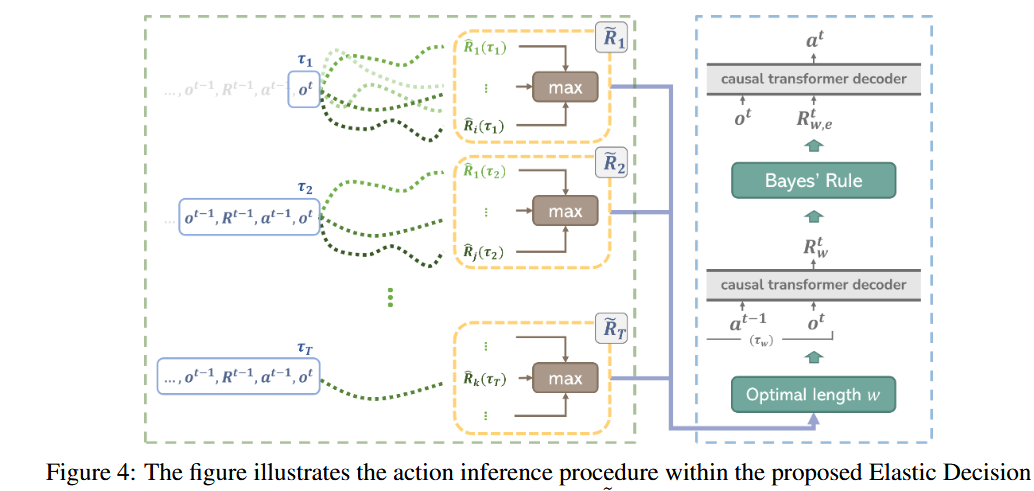

open review Motivation : DT的目标是生成数据集中最好的轨迹,但输入长度固定,混杂着次优甚至劣质的轨迹"Trajectory Stitching"。EDT目标则是增大接近最优轨迹的占比,无视负面和失败的轨迹。这样会减短输入长度,增大预测方差,提供探索机会和降低计算开销.

Method:将轨迹截断成不同长度,长度越短,后面对应的可能性越大,遍历选择最大奖励的动作(这一理念充分体现了为什么DC在MDP任务上优于DT)

在训练时可以加速,但在推理时会降低速度。

来源:浏览arxiv ICML2025

arxiv MOTIVATION:用Moe来实现泛化性。offlinr MTRL目前只能解决有限的任务类别。key insight: 对于MTRL,任务数目比较少时性能表现最佳

road map:首先探究任务种类数量对模型表现和梯度冲突的影响,将学习任务数量减小到一定程度可以显著提高性能?本文目标是在降低学习数量 的同时,仍能有效扩展模型尺寸 ,从而最大化性能表现。

gradient conflict是个挺有趣的概念,衡量主干网络梯度与每一个任务梯度的余弦相似度,在多任务场景下比较有用。

为什么选择扩展FFN而不是Attention?因为预实验证明,MLP的梯度相似度更低,比attention更专业。且attetion模块将作为保持共同知识表示的骨干。事实证明仅直接依靠MOE架构性能几乎无提升,还需要三阶段训练才能显著提升。有趣的是随机分组训练MOE相比按照梯度相似度分组的MOE,二者性能无明显差异。

Mentor: Mixture-of-experts network with task-oriented perturbation for visual reinforcement learning.

vla paper Octo: An Open-Source Generalist Robot Policy

============= World model and visual reinforcement learning ===============

Open-World Reinforcement Learning over Long Short-Term Imagination

来源:ICLR2025 Oral

Openreview 项目 key approach: LS-Imagine enbale the world model to efficiently simulate the longrange effects of specific behaviors without the need for repeatedly rolling out one-step predictions.

============= Diffusion for RL===================

Is Conditional Generative Modeling All You Need for Decision-Making

来源:突然想找下diffusion与DT这种自回归模型的结合[ICLR2023]

MADIFF: Offline Multi-agent Learning with Diffusion Models

posted @

2025-06-06 17:34

霜尘FrostDust

阅读(

102 )

评论()

收藏

举报

浙公网安备 33010602011771号

浙公网安备 33010602011771号