语音合成技术6:DuTa-VC: A Duration-aware Typical-to-atypical Voice Conversion Approach with Diffusion Probabilistic Model

DuTa-VC: 一种具有扩散概率模型的时长感知典型到非典型语音转换方法

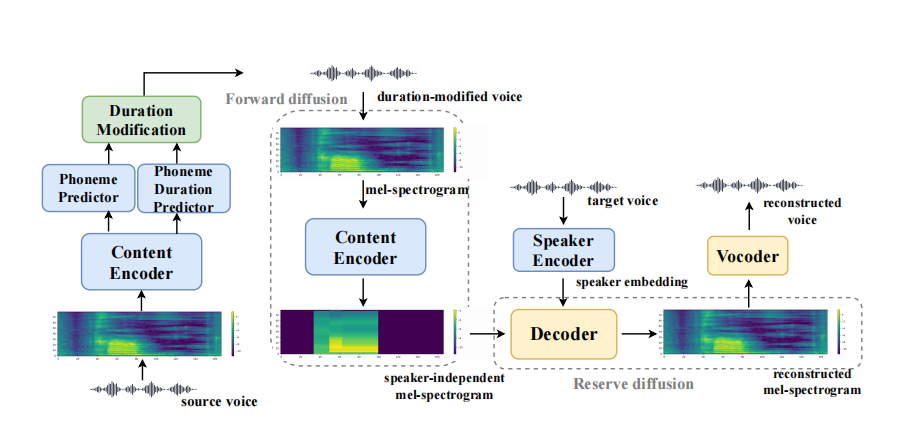

摘要 我们提出了一种新颖的典型到非典型语音转换方法(DuTa-VC),它具有以下特点:(i)可以使用非平行数据进行训练,(ii)首次引入了扩散概率模型,(iii)保留了目标说话者的身份,(iv)了解目标说话者的音素持续时间。DuTa-VC由三个部分组成:一个编码器将源梅尔频谱转换为经过持续时间修改的与说话者无关的梅尔频谱,一个解码器执行相反的扩散操作以生成目标梅尔频谱,以及一个声码器用于重构波形。在UASpeech上进行的客观评估表明,DuTa-VC能够捕捉运动障碍性言语的严重特征,保留说话者身份,并作为数据增强显着改善了运动障碍性言语识别。两位专业言语病理学家的主观评估验证了DuTa-VC可以在合成的言语中保留目标说话者的运动障碍的严重性和类型。 关键词:语音转换,非典型言语,运动障碍性言语,扩散概率模型,数据增强

1. 引言

语音转换(VC)是一种技术,其目的是在保留源说话者所发音的语言内容的同时,复制目标说话者的声音[1]。然而,典型到非典型(T2A)VC是一个很大程度上未被探索的领域,其目标是将通常说话个体的语音转换为非典型语音。运动障碍性言语或声音问题患者的非典型言语可能是由创伤性伤害或神经系统疾病引起的[2]。其他非典型言语的病因可能与听力障碍、智力障碍、唇裂或腭裂等因素有关。非典型言语通常由于语音发音、声音产生、呼吸、韵律、音质或这些因素的组合受到干扰,从而导致理解困难。T2A VC的一个重要应用是用于非典型自动语音识别(ASR)和非典型口语理解(SLU)训练的数据增强,这些应用通常受到资源有限的限制。此外,T2A VC可以为非典型言语和运动障碍患者的新照顾者提供新的增强材料,因为倾听者的培训可以提高理解非典型言语的能力[3]。

对于非典型言语识别,进行数据增强的一种简单方法是改变源说话速度,比如速度扰动[4]和动态时间规整[5]。然而,这些方法没有考虑到与失调言语相关的其他突出特征,如发音不准确、声音沙哑和气息紧促。基于T2A VC的数据增强方法已经显示出可以显著降低词错误率[6, 4]。其中,基于帧的T2A VC模型,如DCGAN [4]和CycleGAN [7],可用于转换语音音色和发音,但不改变语音速率。具有Transformer编码器的序列到序列T2A VC模型 [5, 8] 具有改变说话速率和模拟非典型特征的能力,但需要平行数据进行训练,在实际应用中很难收集到平行数据,尤其是用于非典型音频。为了实现非平行训练,通常采用基于自动编码器的方法,如HL-VQ-VAE [9]。然而,这些方法只改变时间不变的特征,如说话者身份,同时保留时间变化的特征,比如发音和说话速率。

为了解决上述问题,受到扩散概率模型(DPMs)[10, 11]强大的生成能力的启发,我们提出了一种基于条件DPM的非平行T2A VC方法,称为DuTa-VC。具体来说,正向扩散过程旨在从源梅尔频谱生成与说话者无关的语音音色,以保留语言信息并删除说话者信息。这一部分与一个音素预测器和一个音素持续时间预测器一起进行训练,后者可用于在推理阶段修改音素持续时间,以模仿目标语音。带有解码器的反向扩散过程从受说话者信息条件的与说话者无关的梅尔频谱中重建目标梅尔频谱。然后使用声码器来合成波形。我们在UASpeech数据集上进行了实验,结果表明,所提出的方法可以显著提高运动障碍性言语

2. 材料与方法

在这一部分,我们介绍了我们使用的数据集的详细信息以及提出的DuTa-VC方法。基本思想是在时频域中将源音频转换为目标非典型音频,即使用梅尔频谱而不是原始波形。对于具有数据相关先验的条件DPM[13, 14],正向扩散逐渐向数据添加高斯噪声,而反向扩散试图去除这种噪声,并且它被训练为最小化正向和反向扩散过程轨迹之间的距离。DuTa-VC的训练阶段和推理阶段分别在图1和图2中显示。需要注意的是,DuTa-VC是与说话者相关的,因为我们认为每个非典型说话者的语音可理解性、发音和声音受损特征都不同。

图1:DuTa-VC的训练阶段,旨在通过正向扩散将源梅尔频谱转换为与说话者无关的梅尔频谱,并通过反向扩散将与说话者无关的梅尔频谱转换回原始梅尔频谱。请注意,红色框表示损失函数,蓝色框表示仅使用典型语音进行训练的模块,黄色框表示使用非典型语音进行微调的模块。训练过程中不需要并行数据。

图2:DuTa-VC的推理阶段。首先,我们预测源声音的音素和音素持续时间。接下来,应用持续时间修改模块(绿色框)来改变源声音的节奏。然后,使用持续时间修改后的声音的梅尔频谱作为编码器的输入。在这里,说话者嵌入是从目标非典型语音中获取的。

2.1. 数据集

我们使用了UASpeech数据集[12],其中包括15名患有运动障碍的演讲者和13名典型的对照演讲者的单词录音。每个运动障碍演讲者被分类为不同的可理解性组别:非常低、低、中和高。可理解性是由5名非专业的美国英语本土演讲者进行评判的。每个演讲者有3个块,每个块包含255个话语。根据[6, 15, 16]的做法,我们使用块1和块3进行训练,使用块2进行测试。对于接下来的编码器和解码器的预训练,我们使用了来自大规模LibriTTS数据集[17]的典型演讲,该数据集包括约1100名演讲者(其中10名演讲者用于验证)。所有的波形都被重新采样为22.05 kHz。

2.2. 编码器

编码器的任务是生成一个代表源语音相同音素序列的与说话者无关的梅尔频谱图(SIMS)。内容编码器参数化了前向扩散的终端分布,它仅使用典型语音(LibriTTS)进行训练。根据[18],SIMS被用作数据相关的先验,它描述了独立于说话者的时间内的音素内容。

为了获取用于训练的真实SIMS,我们首先对典型训练数据应用蒙特利尔强制对齐器[19],将语音帧与从其相应的转录中提取的音素进行对齐。接下来,针对每个特定音素,通过汇总其跨典型语音数据的梅尔特征,计算其声音无关的梅尔特征。然后,将输入梅尔频谱图的每个音素梅尔特征替换为平均值以获得真实的SIMS。应用均方误差(MSE)损失来衡量内容编码器的输出与真实SIMS之间的差异。编码器还与音素预测器和音素持续时间预测器一起进行联合优化,分别使用帧级交叉熵(CE)损失和MSE损失进行训练。通过强制对齐,还可以获得音素和持续时间的真值。

引入音素预测器和音素持续时间预测器的目标是在生成合成的非典型语音时实现音素持续时间的修改。音素预测器简单地提供了包含在话语中的估计音素的信息,而音素持续时间预测器预测了话语中平均音素的持续时间。然后,对于某个目标非典型说话者,我们使用已知的音素持续时间来拉伸或缩短源音频波形,使其具有与该音素序列的非典型说话者类似的持续时间。如图2所示,对于源语音,音素预测器预测在话语中出现了Np个不同的音素,音素持续时间预测器预测平均音素持续时间为ts。对于目标非典型说话者,我们在训练集上计算每个特定音素的持续时间,并通过对应的Np个音素持续时间的平均值,我们可以得到平均音素持续时间tt。应用速度扰动[20]对源语音进行加速,速度比率为tt/ts,以获得持续时间修改后的语音。然后,将持续时间修改后的语音的梅尔频谱图馈送到内容编码器以估计SIMS。请注意,我们修改整个话语的持续时间,而不是分别更改每个音素的持续时间。在未来的工作中,我们将尝试更改每个音素的持续时间。

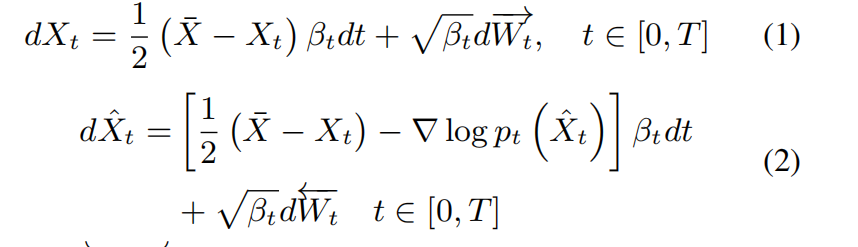

2.3. 解码器

解码器的任务是在给定SIMS和说话者嵌入的情况下生成目标的重建梅尔频谱图。逆扩散由解码器参数化,该解码器在使用典型语音进行预训练后,再经过非典型语音的微调。根据[11],我们使用了由随机微分方程(SDEs)定义的正向和逆向扩散:

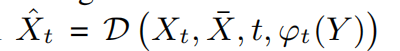

上述介绍的DPM最初是在文本转语音任务中引入的[13],我们进一步将其调整为T2A VC任务。我们使用¯X = E(X0),其中E(·)是编码器,即¯X是我们希望将其转换为目标语音的SIMS。解码器用于重构梅尔频谱。

其中,D(·)是解码器,φt(Y )提供目标说话者信息。Y代表训练时的源语音,以及推断时的目标语音。在这里,我们使用了一个预训练的说话者验证网络[21]来提取说话者嵌入φt(Y )。在使用解码器生成梅尔频谱之后,我们使用预训练的通用HiFi-GAN声码器[22]来重构音频波形。我们进一步对每个非典型说话者进行了声码器的微调。

3.1. 实验设置 对于编码器,我们使用了与Glow-TTS3 [23]相同的架构,由一个预处理网络、6个Transformer块和一个最终的线性投影层组成。音素预测器和音素持续时间预测器借用了FastSpeech [24]的结构,包括2个卷积层,后跟一个投影层,用于分别预测音素的概率和持续时间的对数。解码器采用了与[25]相同的U-Net4架构,具有4个特征图分辨率。扩散时间t通过添加Transformer正弦位置编码[26]来指定。在我们的实验中,遵循[22]的设置,我们使用80维的梅尔频谱,STFT窗口大小为46.4毫秒,跳跃大小为11.6毫秒。解码器的帧数在训练时为128,在推断时如果帧数不是4的倍数,我们会对梅尔频谱进行零填充。编码器输出¯X与Xt连接为一个额外的通道。按照[18]的做法,说话者嵌入φt(Y )通过时间位置编码进行编码,并通过多个线性模块得到128维的向量,然后被广播连接为额外的128个通道。因此,解码器的输入大小为130 × 80 × 128用于训练。我们的DuTa-VC模型的编码器有850万个参数,解码器有1.178亿个参数。

在LibriTTS上预训练编码器和解码器时,我们使用Adam优化器,初始学习率分别为5×10^(-4)和1×10^(-4)。批次大小设置为128和32,分别进行了200个时代和100个时代的训练。而在UASpeech上对解码器进行微调时,我们使用Adam优化器,初始学习率为5×10^(-5),批次大小为32,进行了30个时代的训练。声码器在UASpeech上进行微调,使用了AdamW优化器[27],初始学习率为5×10^(-5),批次大小为128,进行了30个时代的训练。用于重建和用作输入到说话者条件网络的训练段是从相同训练语句中随机抽样的不同随机段。噪声时间表参数βt设置为[0.05, 20.0]。

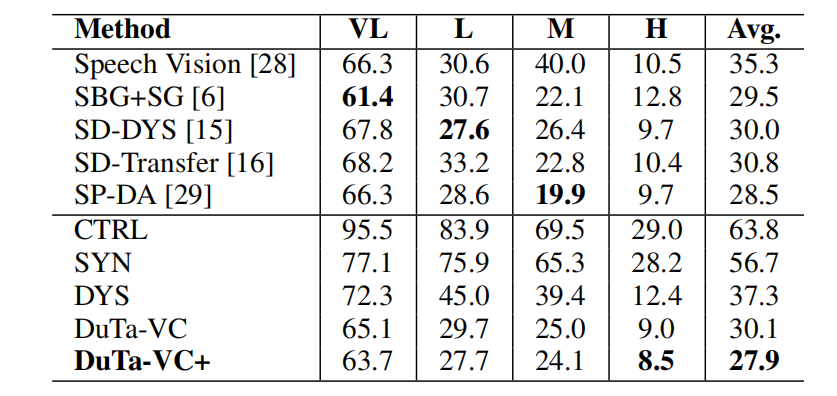

表1:不同ASR系统在UASpeech上的词错误率(%)。这里,VL,L,M和H分别表示非常低,低,中等和高的可理解度组。

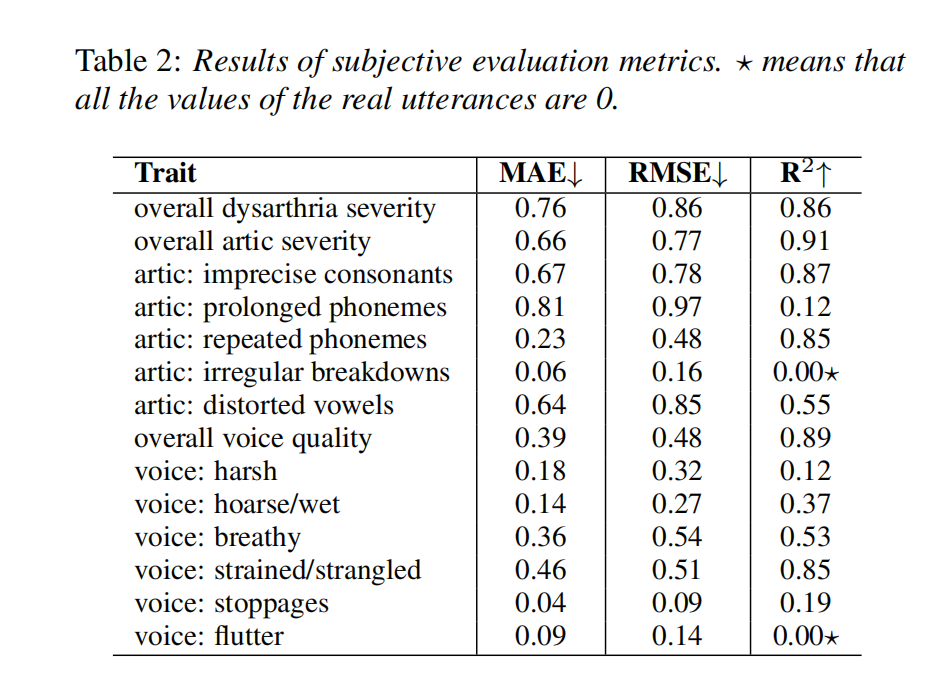

3.2. 主观评估指标 我们进行了主观评估,以衡量来自UASpeech的患有运动障碍的演讲者的非典型语音特征在DuTa-VC生成的类似演讲者(合成目标)中的转移程度。我们邀请了两名拥有10到20年提供治疗和评估运动障碍患者演讲经验的专业言语病理学家(SLP)来感知性地评价真实目标和合成目标的语音。SLP们被提供了每个真实目标的三个录音,每个录音包含来自UAspeech的20个单词。我们还提供了另外三个合成目标的录音(类似于真实目标,但使用不同的单词),每个录音包含20个单词。所有录音都被随机排列,SLP不知道提供了每个说话者多少个录音,哪个文件对应于真实或合成语音。SLP们评估了不同非典型语音特征的整体严重程度:运动障碍、总体发音、不清晰的辅音、持续的音素、重复的音素、不规则的发音故障、扭曲的元音、总体声音质量、刺耳的声音、沙哑的声音、喘息声、紧张/窒息的声音、停顿和颤音。评分范围在0到4之间,其中0表示没有严重程度,4表示严重,遵循了[2]第三章中描述的偏离性语音特征评分量表的协议,这是SLP在临床实践中常用的协议。然后,对于每个真实目标和合成类似目标,我们分别对SLP提供的他们的三个录音的评分进行了平均,然后计算了每个特征的真实录音和合成录音之间的评分的平均绝对误差(MAE)、均方根偏差(RMSE)和R平方(R2)。最后,SLP们被要求使用0到4的评分来评估所有录音的自然度,其中0表示非常合成,4表示非常自然。

3.3. 客观评估指标

词错误率(Word Error Rate,WER): 我们使用了DuTa-VC作为ASR的数据增强方法,该方法使用了espnet工具包。这个CTC-attention混合编码器-解码器模型总共有870万个参数,词汇量为500。该模型使用Adam优化器进行训练,初始学习率为1 × 10^(-3),批量大小为64,训练时长为100个epoch。

我们进行了5个ASR系统的评估:

- CTRL: ASR仅使用控制组的训练数据(6,630个utterances)进行训练,然后在真实的语音障碍测试数据(3,825个utterances)上进行测试。

- SYN: ASR仅使用控制组的训练数据进行训练,然后在合成的测试数据(3,825个utterances)上进行测试,以评估ASR在推断过程中对真实和合成的语音是否表现出类似的行为。

- DYS: ASR使用控制组的训练数据和语音障碍训练数据(7,650个utterances)进行训练,然后在真实的语音障碍测试数据上进行测试。

- DuTa-VC: ASR使用控制组的训练数据、语音障碍训练数据和合成的训练数据(99,750个utterances)进行训练。对于每个控制组的训练utterance,我们将其定向转换为15个语音障碍讲话者的结果,从而得到15个新的训练utterance。然后在真实的语音障碍测试数据上进行测试。

- DuTa-VC+: ASR使用控制组的训练数据、语音障碍训练数据和合成的训练数据进行训练。为了使系统更加健壮,在训练过程中进行了数据增强,包括添加随机高斯噪声、SpecAugment和更改速度比率为{0.9, 1.0, 1.1}。然后在真实的语音障碍测试数据上进行测试。

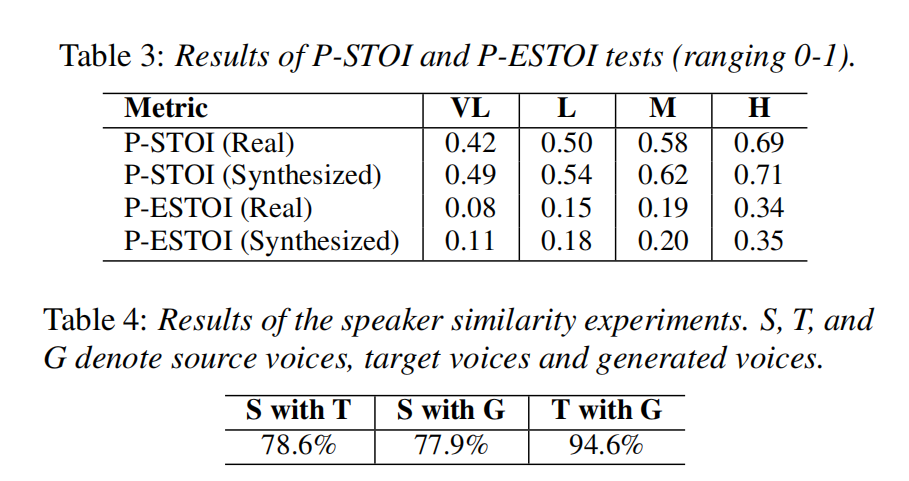

P-STOI/P-ESTOI: 这些指标用于量化控制语音和语音障碍语音之间时间频率结构的失真程度。P-STOI/P-ESTOI已成功用于评估语音障碍语音的客观质量。我们计算了两个值,一个是在真实的语音障碍语音和控制语音之间计算的,另一个是在合成的语音和控制语音之间计算的。高值表示较低的语音障碍严重程度和良好的自然度。

说话人相似度: 我们测试了源语音、目标语音和生成语音之间的说话人相似度(说话人嵌入之间的余弦相似度)。目标是评估DuTa-VC是否能够复制目标说话人的身份特征。对于每个语音障碍说话者,我们使用每个控制说话者的20个随机utterances作为源语音来生成合成语音。我们比较了所有可能的控制说话者-语音障碍说话者对,并计算了它们之间的平均余弦相似度。

3.4. 结果

不同ASR系统在UASpeech上的性能如表1所示。我们将我们的结果与五个以前使用UASpeech进行ASR的研究进行了比较,这些研究在第1节中介绍过。当没有使用非典型语音进行训练时,CTRL的平均WER为63.8%。SYN提供了平均WER为56.7%的结果,接近CTRL的结果,这表明ASR系统对真实和合成数据表现出类似的敏感性。所提出的DuTa-VC数据增强显著提高了与DYS相比的ASR性能。此外,DuTa-VC可以很好地与其他数据增强方法配合使用,DuTa-VC+提供了最佳的平均WER为27.9%。与以前的方法相比,DuTa-VC+在整体结果上表现最好,因为它在多个可理解度程度上表现出色,而以前的方法往往只在一个可理解度程度上表现出色。例如,在VL组中,[6]中提出的基于GAN的方法获得了最佳结果,但在其他组中表现不佳,并需要并行数据进行训练。[29]中使用了速度扰动和说话人自适应训练,在M组中提供了最佳结果。然而,这种方法在其他严重程度方面表现不佳。[15, 16]中使用了基于音素的语音节奏调整,但需要手动数据选择。相比之下,DuTa-VC+在所有组中表现良好,并且实现了与以前研究中每组的最佳WER相似的结果,而不需要并行数据。

表2显示了主观评估指标的结果。所有真实和合成语音之间感知评估的平均MAE都小于0.81,这表明真实和合成目标之间的发音障碍和发音配合很好。其中,DuTa-VC可以很好地模拟发音配合失调、刺耳声音、沙哑/潮湿的声音、停顿和振荡(MAE低于0.25)。关于自然度,平均而言,合成目标评分要低1.15分,这意味着这些目标被认为比真实录音更合成。由于每个文件包含20个单词,一个单词中的错误可能导致SLP评估者将整个录音评分为自然度较低。从这个意义上说,以单词或话语为单位的比较可能会导致合成语音的自然度评分更高。

表3总结了P-STOI和P-ESTOI分析的结果。随着语音可理解度的提高(从VL组到H组),P-STOI和P-ESTOI的值也会增加,这意味着严重程度减轻。总之,DuTa-VC合成的发音障碍语音显示出与真实发音障碍语音类似的发音障碍严重程度和自然度。另一方面,表4显示了DuTa-VC的身份保留能力。结果表明,合成生成的语音与真实目标语音具有相当高的相似性,而生成的语音和目标语音都与源语音(非目标)的相似性要低得多。

4. 结论和未来工作

在本文中,我们提出了一种基于扩散概率模型的新型典型至非典型语音转换方法,该方法具有时长感知性。在UASpeech上的实验结果表明,该方法可以显著改善ASR的性能,捕获非典型语音的严重特征,并很好地保留说话者身份。在未来的工作中,我们将(1)将我们的方法适应句子发音而不是单词,使用我们已经开始收集的新数据集。 (2)探索新的更精确的方法来分别修改每个音素的时长。(3) 使用增强的数据来改善对非典型语音的口头语言理解。

浙公网安备 33010602011771号

浙公网安备 33010602011771号