Pycharm+Ollama+DeepSeek+ProxyAI本地大模型辅助编程

Pycharm+Ollama+DeepSeek+ProxyAI

框架选型

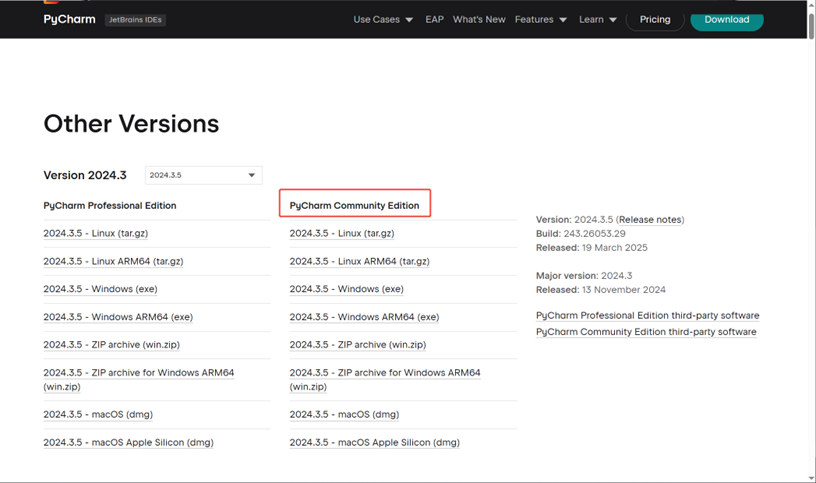

1、 解释器选择pycharm社区版(免费)

1)下载地址https://www.jetbrains.com/pycharm/download/other.html

2)根据PC配置选择合适的版本进行安装(安装无特殊配置,直接“下一步”至安装完成)

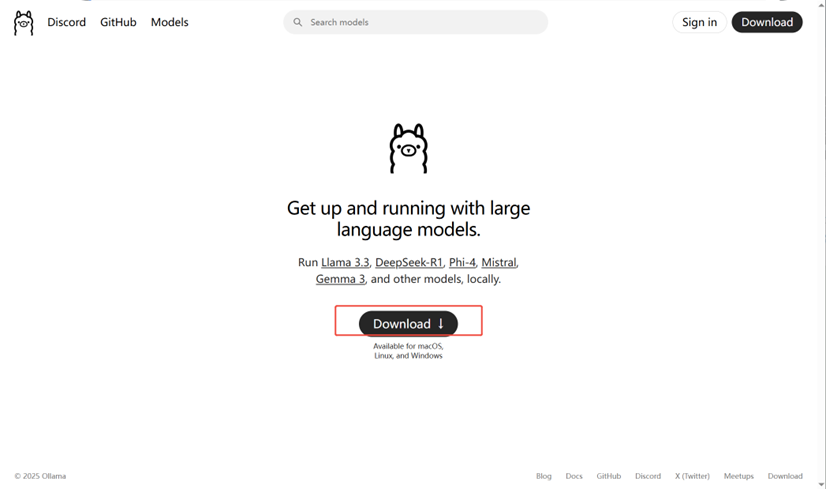

2、 ollama管理大模型

简介地址:https://www.runoob.com/ollama/ollama-intro.html

1)下载地址:https://ollama.com/

安装时无其他特殊配置,一直“下一步”直到安装完成。

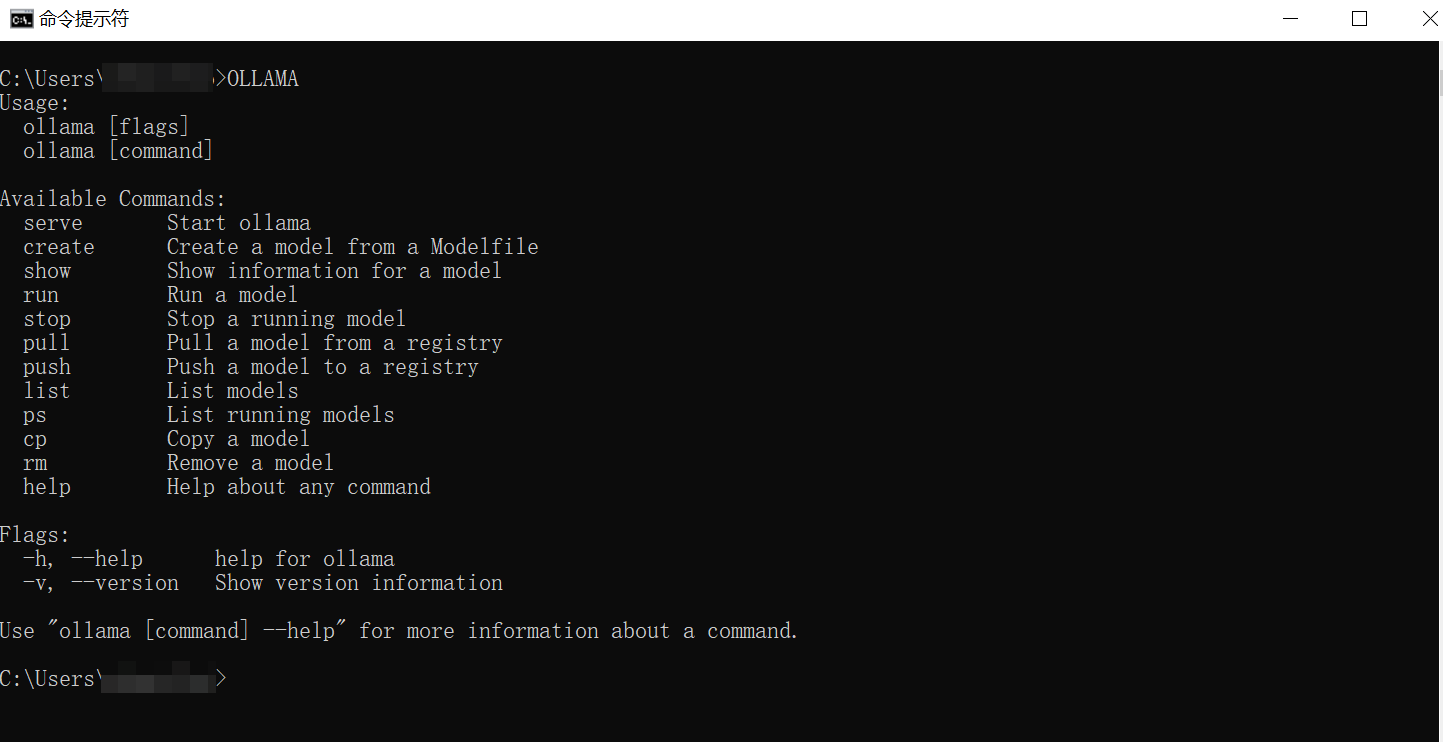

2)dos命令检查是否可用

3)常用命令

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model //调用大模型前,必须用此命令先启动服务

stop Stop a running model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

4)接口开发

默认的端口是11434,打开浏览器后,输入localhost:11434=> Ollama is running

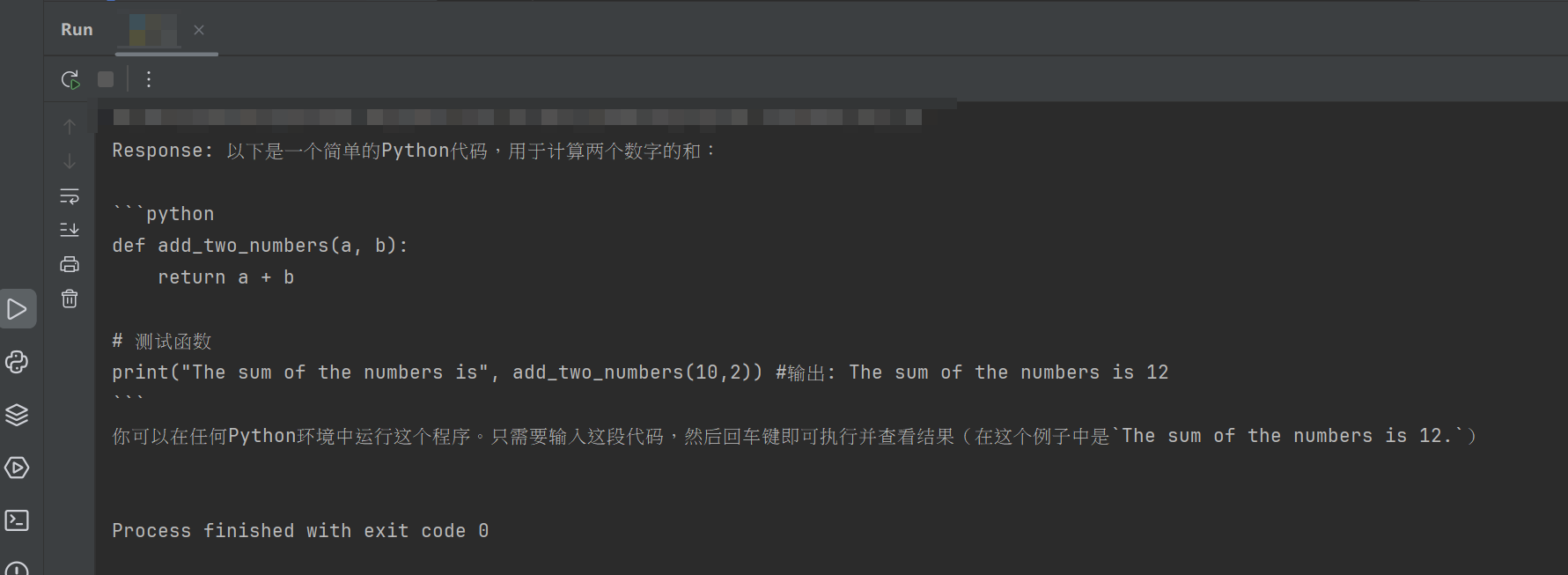

示例代码

import requests

url = "http://localhost:11434/api/generate"

body = {

"model":"deepseek-coder",

"prompt":"用python写一个加法程序?",

"stream":False

}

res = requests.post(url,json=body)

print("Response:",res.json()['response'])

返回结果

5)API参数(不同的api参数略有不同)

参考https://github.com/ollama/ollama/blob/main/docs/api.md

|

参数名 |

是否必填 |

描述 |

|

|

是 |

模型名称 |

|

|

是 |

需要生成响应的提示词 |

|

|

否 |

模型响应后追加的文本 |

|

|

否 |

Base64编码的图片列表(适用于多模态模型如llava) |

|

|

否 |

返回响应的格式(可选值: |

|

|

否 |

模型额外参数(对应 Modelfile 文档中的配置如 |

|

|

否 |

自定义系统消息(覆盖 Modelfile 中的定义) |

|

|

否 |

使用的提示词模板(覆盖 Modelfile 中的定义) |

|

|

否 |

设为 |

|

|

否 |

设为 |

|

|

否 |

控制模型在内存中的保持时长(默认:5m) |

|

|

否 |

(已弃用)来自前次 |

3、 deepseek-coder

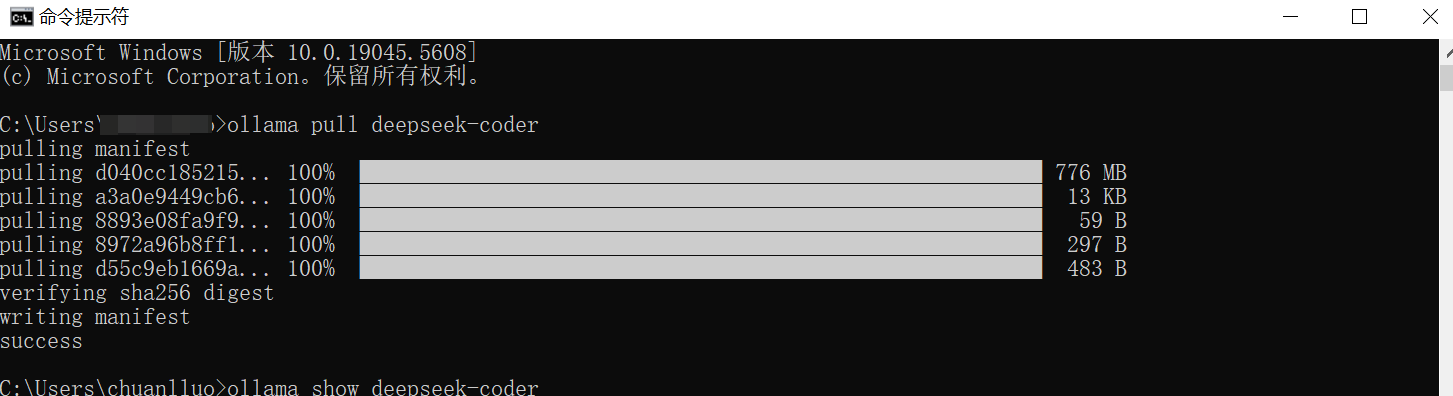

1) 使用ollama服务下载并部署模型

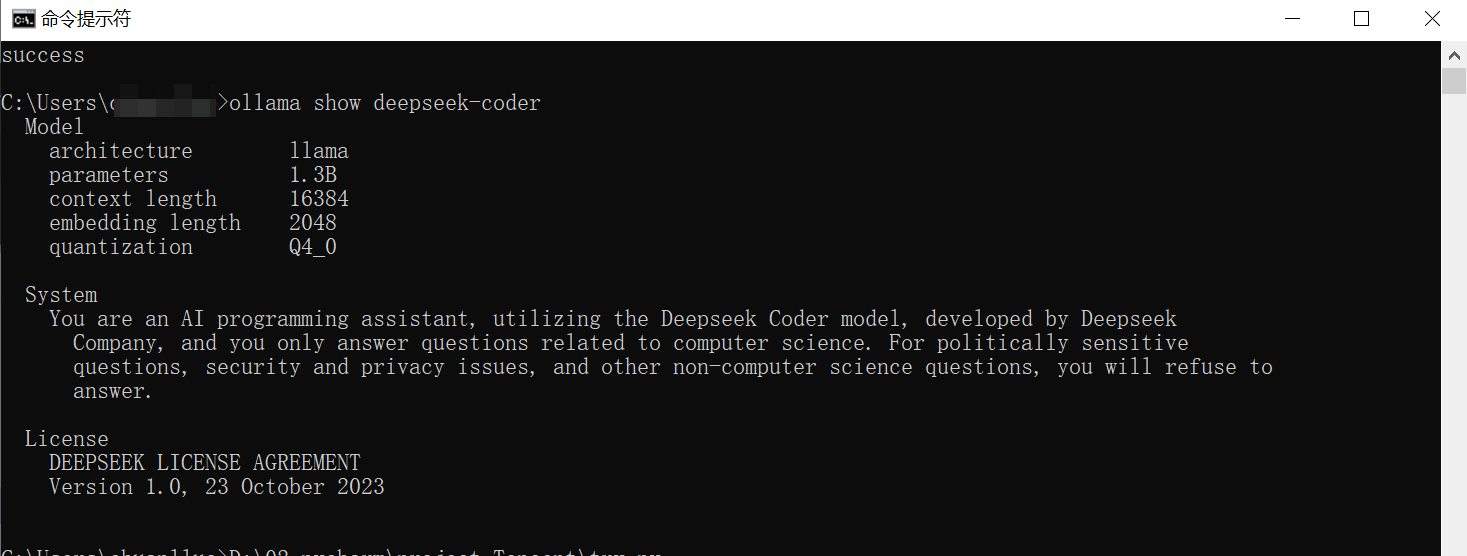

2) 查看已部署的大模型信息

3) 参数解释

架构(architecture): llama

表明该模型使用的是 llama 的架构。

参数量(parameters):1.3B

模型拥有 1.3 亿个参数,属于轻量级的大语言模型

上下文长度(context length):32768

该模型可以处理的最大上下文长度为 32768 个token,这使其非常适合处理长文本输入(例如文档摘要和代码生成)。

嵌入维度(embeddinglength):4096

该模型的词向量维度为 4096,表示其在输入文本向量化时采用高维表示,

量化方式(quantization):Q4_0

使用了四位量化(Q4_0),这是量化技术的一种形式,用于减小模型的存储需求和运行时内存占用,同时保留了较高的推理性能。

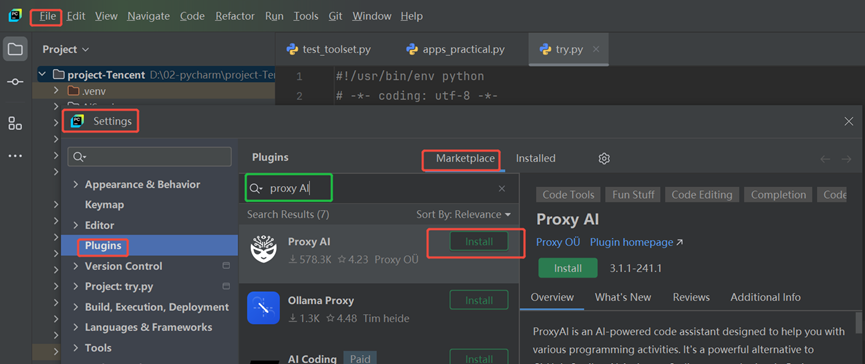

4、 proxyAI插件

在pycharm中调用大模型时需要的插件,原叫“CodeGPT”

1) 安装方式

Pycharm:file=>settings=>Plugins=>Marketplace:

搜索“proxy AI”

2) 插件配置

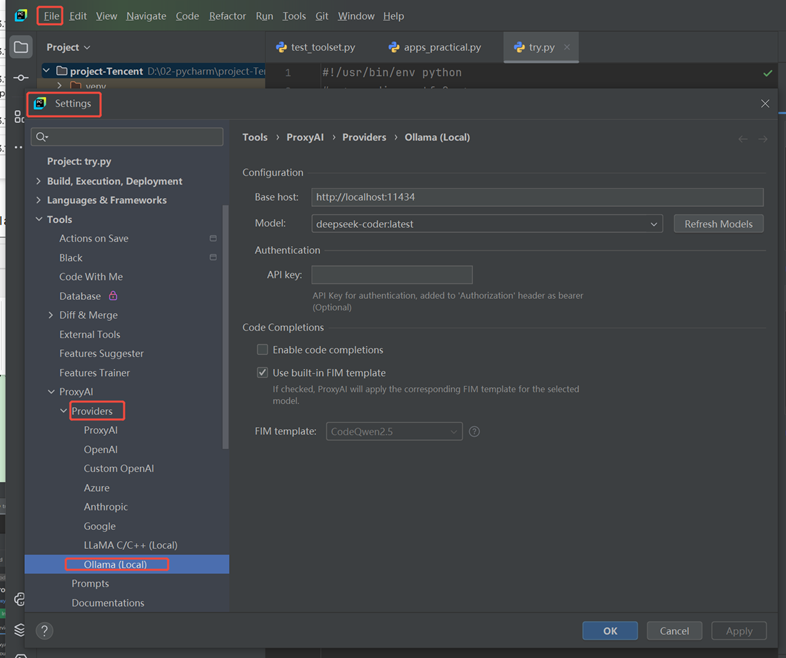

安装后在Pycharm:file=>settings=>Tools=>ProxyAI=>Providers

右侧页面中:Selected provider:Ollama(Local)

然后在路径:Pycharm:file=>settings=>Tools=>ProxyAI=>Providers=> Ollama(Local)参数默认即可

5、 大模型辅助编程的应用

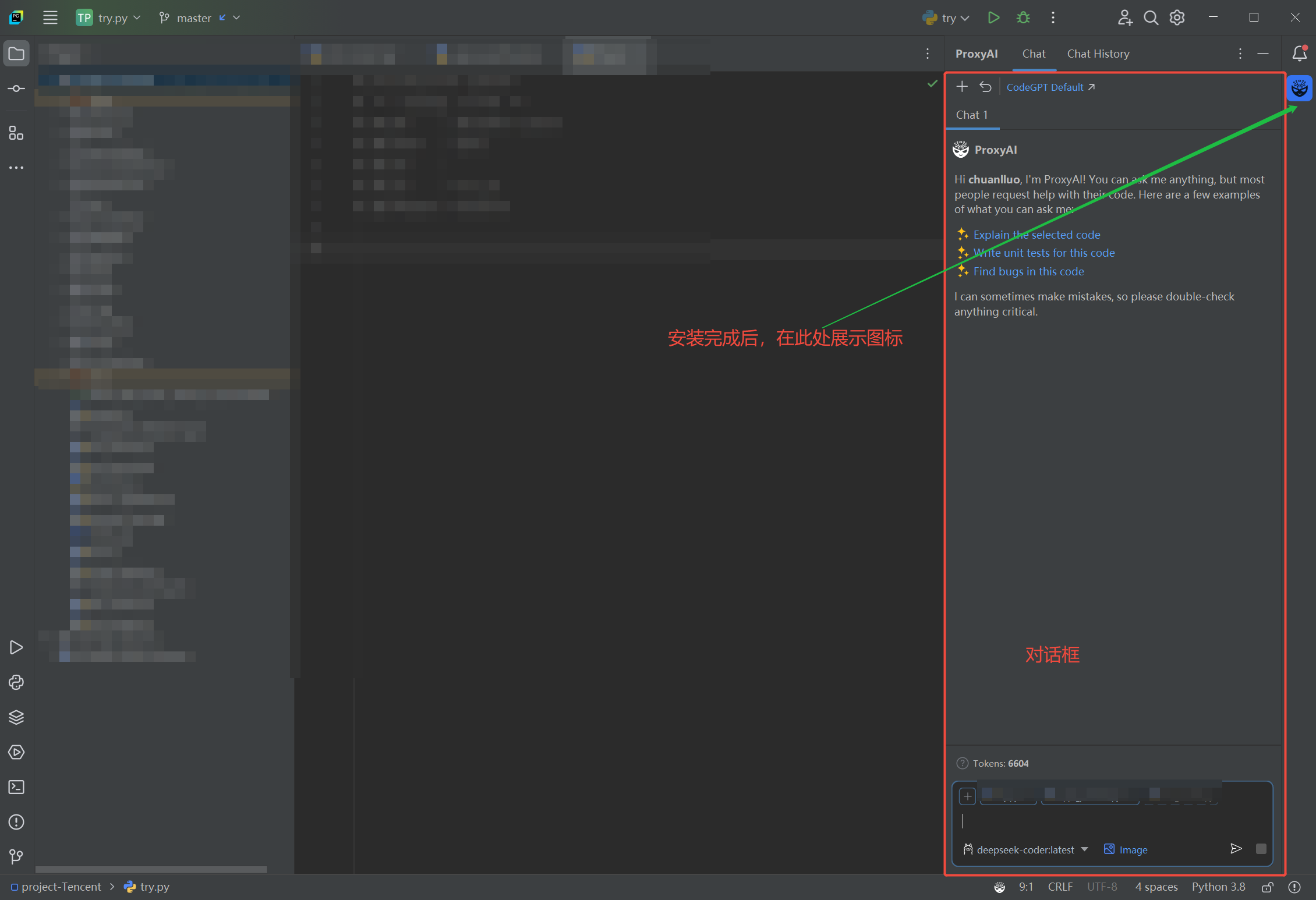

1) 大模型本地部署并启动,插件安装完成可以进入使用大模型辅助编程

2) 在pycharm右侧边栏会出现proxyAI的图标,点击后会出现proxyAI的对话框

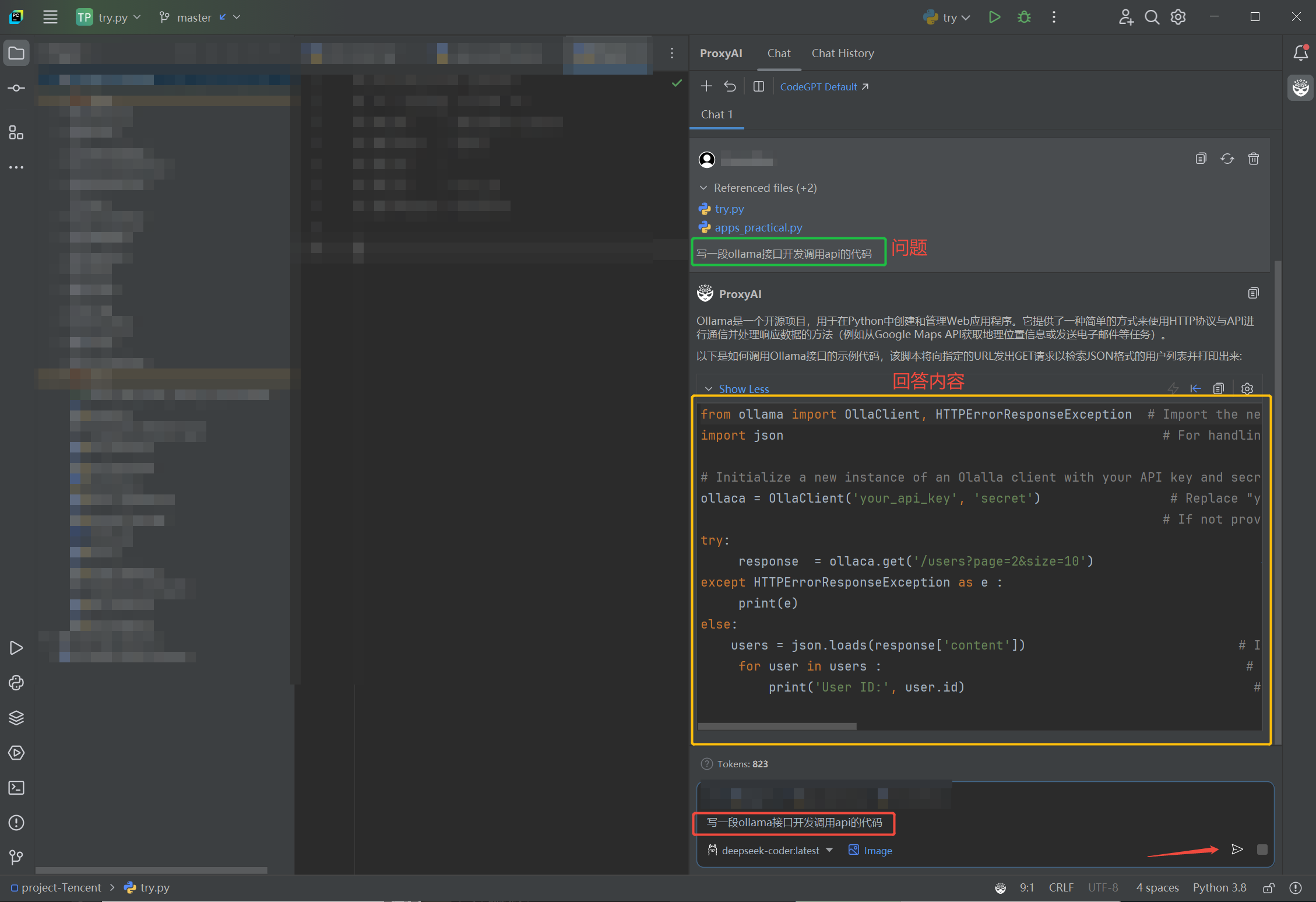

3) 在proxyAI对换框输入编程的需求,发送给大模型,即可返回相应的内容

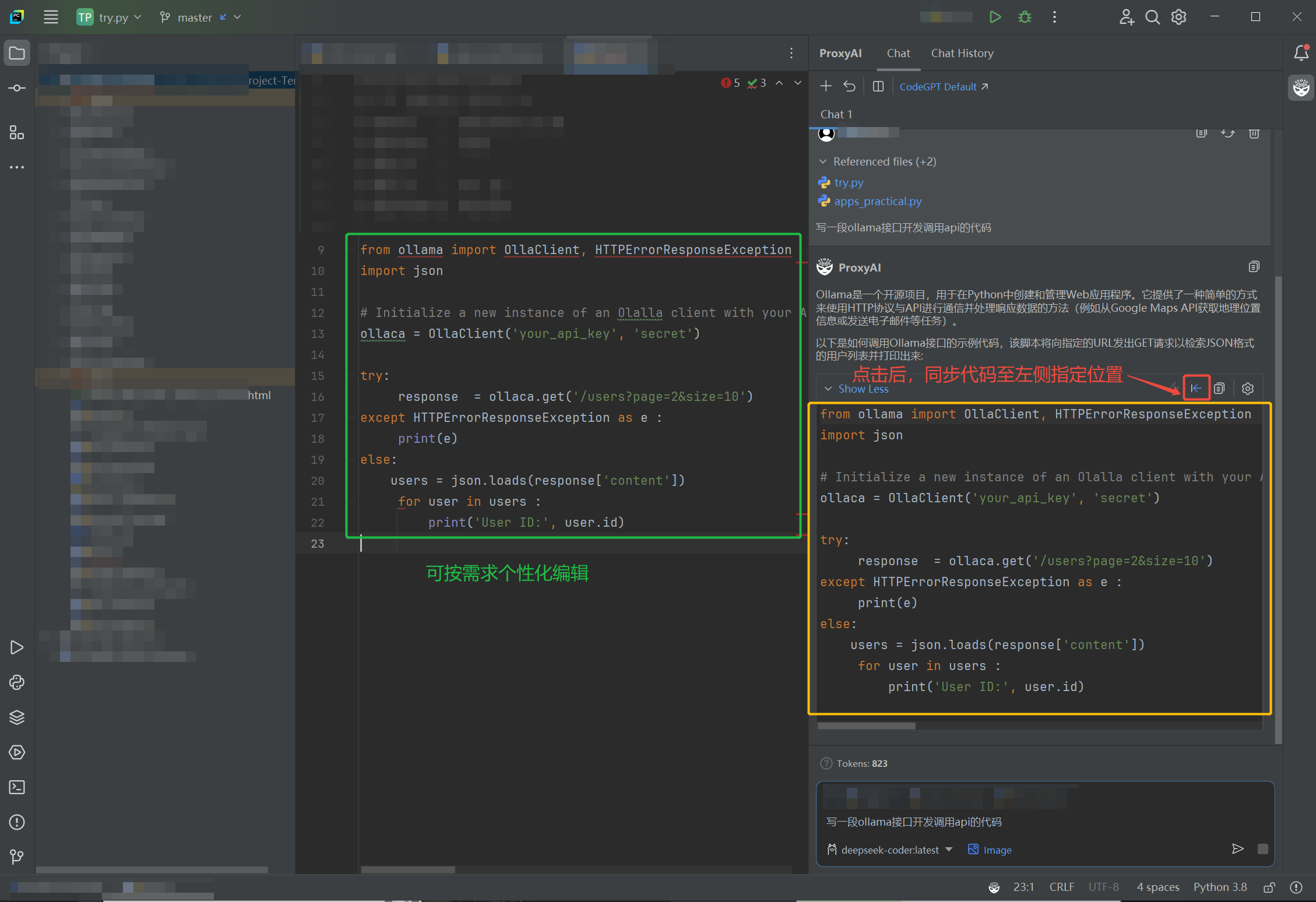

4) 生成的代码直接导入指定的py文件指定的位置,然后对代码按需进行个性化编辑

浙公网安备 33010602011771号

浙公网安备 33010602011771号