写在前面:人生就是努力、搞不懂、躺平,循环。

文章结构

- 池化层的相对位置

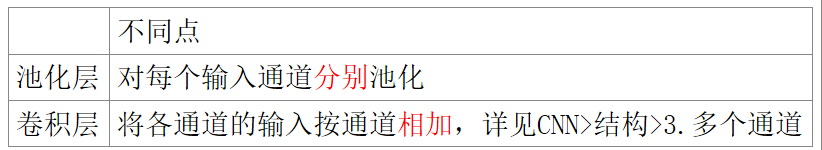

- 在多通道任务中,池化层和卷积层的不同

- 重要的参数stride 与 kernel_size 大小的相对关系决定3种池化层

- 参数

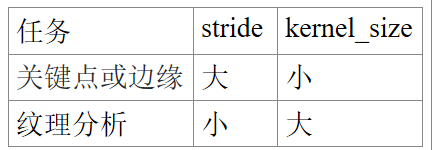

- 针对不同的任务,使用不同的 stride 和 kernel_size。

- kernel_size是否越大越好?

- 常用的池化层/结构(名称、优点、适用于、pytorch 函数)

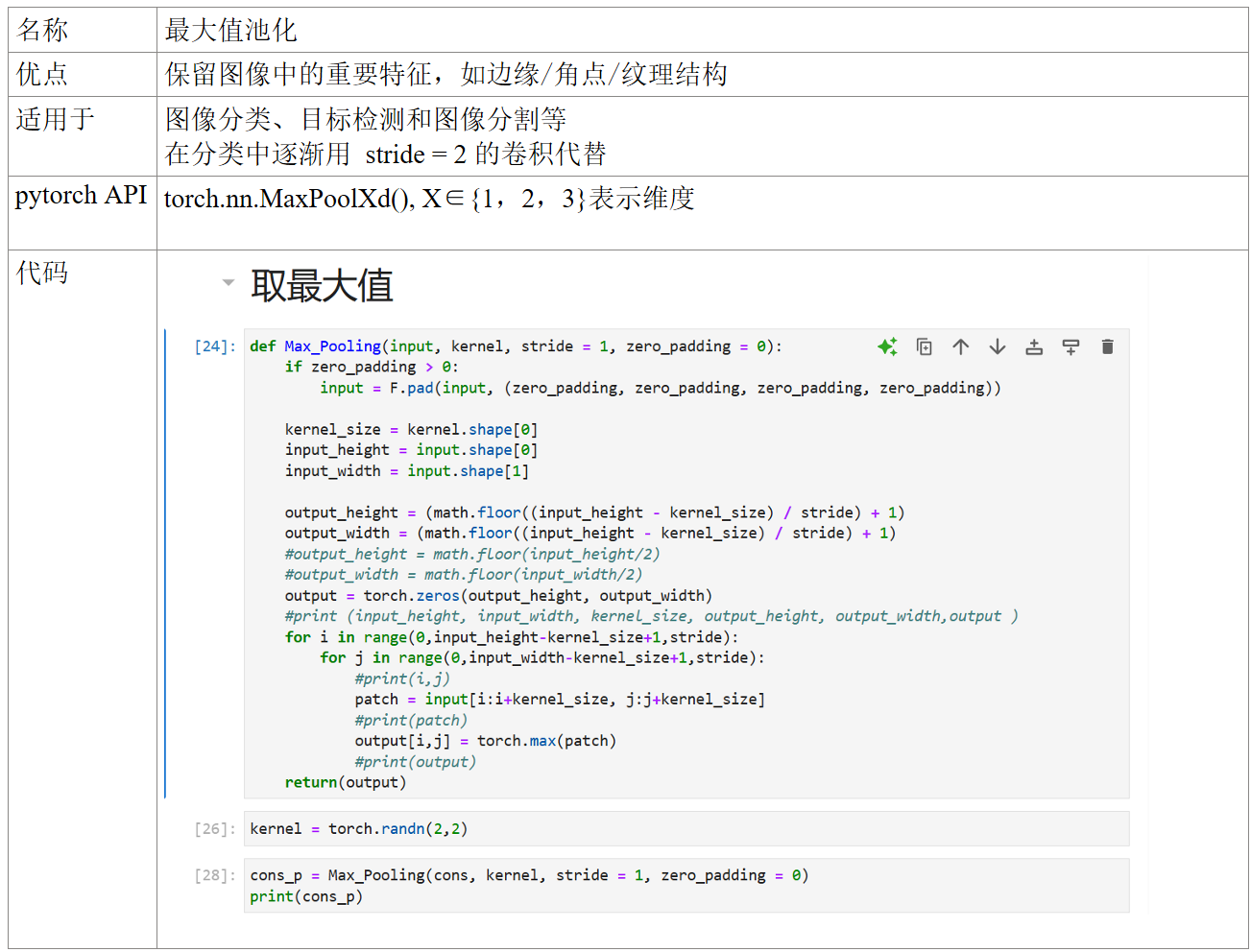

- 最大值池化

- 平均值池化

- 组合池化

- 自适应最大值/均值池化

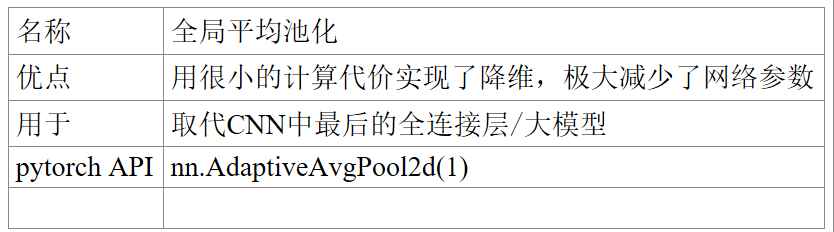

- 全局平均池化

- 随即池化

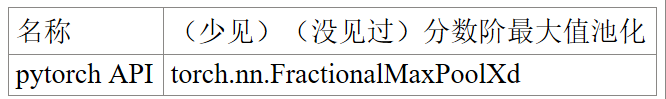

- 分数阶最大池化

- 幂均值池化/LP池化

- Detail-Preserving Pooling

- Local Importance Pooling

- 软池化

- 双线性池化

- 反池化反卷积/转置卷积

- 适用于

- pytorch函数

如果存在错误,欢迎指正,共同学习。

部分图片与公式来源网络。博客起初是我的个人学习笔记,如有侵权,请联系我添加来源或进行删除。

池化层的相对位置

Convolutional Layer → ReLU → Pooling Layer

在多通道任务中,池化层和卷积层的不同

重要参数

- 参数

- 步长 stride

- 填充值 zero_padding

- 卷积核kernel及其大小size,深度/个数depth

- 针对不同的任务,使用不同的 stride 和 kernel_size。

- kernel_size是否越大越好?

![]()

stride 与 kernel_size 大小的相对关系决定3种池化层。

常用的池化层/结构(名称、优点、适用于、pytorch 函数)

组合池化 组合最大值池化和均值池化,常见 Cat与Add 当做分类任务的一个trick,其作用就是丰富特征层,maxpool更关注重要的局部特征,而average pooling更关注全局特征。

随机池化/随机位置池化 将方格中的元素同时除以它们的和sum,得到概率矩阵

Detail-Preserving Pooling 保存网络的精度 放大空间变化并保留重要的图像结构细节,且其内部的参数可通过反向传播加以学习

Local Importance Pooling

反池化

- 适用于:扩大特征图的尺寸,它通过学习滤波器和步长来逆转池化过程中的降维过程。

- pytorch 函数: torch.nn.MaxUnpool2d

反卷积/转置卷积 计算步骤

按卷积核个数depth,写成一个depth行input_size*input_size列大小的矩阵 C,将现有的结果y,根据公式

计算得 输入 input/x

浙公网安备 33010602011771号

浙公网安备 33010602011771号