Joint Global and Local Hierarchical Priors for Learned Image Compression

abstruct

\(\quad\)现在的可学习图像远超过去的手工方法,成功的原因在于可学习熵模型能够预测量化浅表示的概率分布。由于CNN局部连接的特性,在建模远程依赖关系的方面存在局限性。而在图像压缩中,减少空间冗余是非常重要的,因此在该领域CNN出现瓶颈。

\(\quad\)为克服该问题,该文章提出Information Transformer熵模型,使用注意力机制,以上下文依赖的方式,既利用全局信息也利用了局部信息。

Introduction

\(\quad\)设计一个精确的熵模型对压缩效率是十分重要的。熵模型的目的就是估计量化潜在表示元素的联合概率分布。

\(\quad\)一个简单的方法是假设元素之间完全独立,但这种假设通常不适用,导致这种方法没有取得很好的压缩效率。因此如何对冗余的依赖关系进行建模非常重要。人们通常会提取额外的特征——超先验或分层先验(called “hyperprior”or “hierarchical prior”),使用cnn在潜在表示中捕获依赖关系。从而学习到更精确的熵模型。

但是

\(\quad\)cnn在捕捉全局依赖关系方面仍然具有局限性:

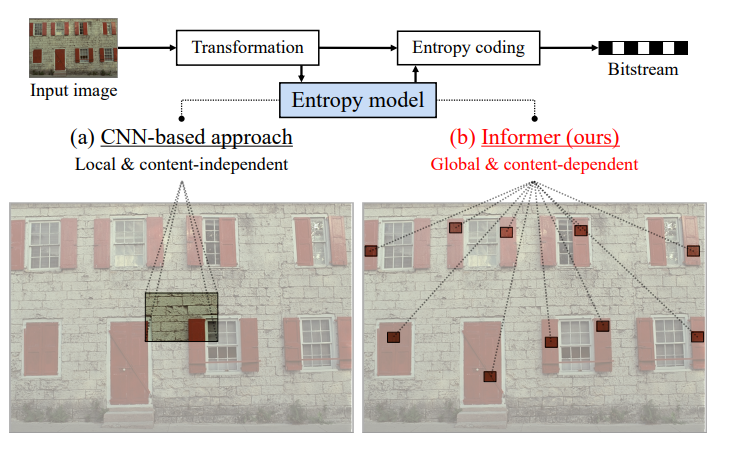

- 一方面由于cnn的局部接受域,在建立长期依赖关系时,熵模型没有充分利用全部信息。如图所示,cnn并不能捕获到由于局部感受野而多次出现的全部红色窗口的依赖关系。

![image]()

- 另一方面,由于卷积操作的内容无关性,位置相近的两个元素即使内容差异很大,也会被在同一个感受野被处理例如图一中位置相邻的红白砖块在处理依赖关系时会被同时处理。

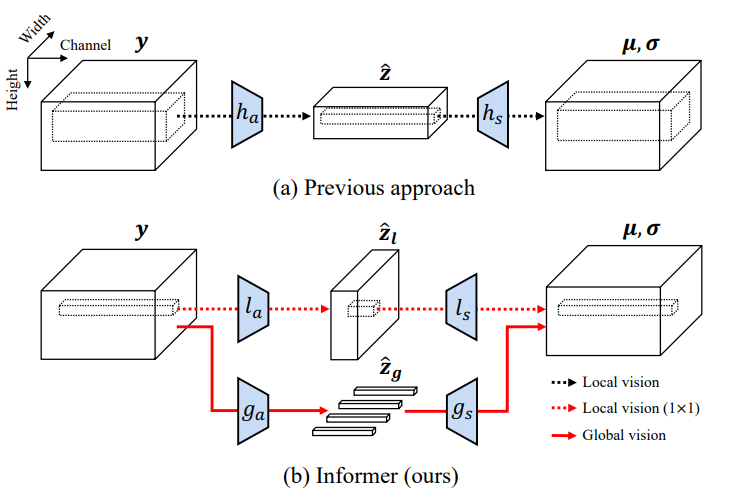

\(\quad\)因此这篇文章引入注意力机制,它擅长处理长期依赖关系。在基于联合自回归和分层先验的熵模型的基础上,引入局部超先验和全局超先验。

- 为了建模量化潜在表示的全局依赖关系,使用交叉注意力机制提取全局超先验(这种全局先验由不同的向量组成,不同的向量关注不同的图像区域)

- 此外,使用1X1卷积层,提取专用于局部特征的局部超先验。

- (不太理解的)他们的局部超先验阻止(prevent)全局超先验只使用局部信息,允许模型有效的同时使用全局和局部信息。 他还避免了全局参考的二次计算复杂度问题。

![image]()

conclusion

\(\quad\)在联合自回归和分层先验模型的基础上,加入注意力机制,使用全局超先验和局部超先验,分别表示全局和局部潜在表示的依赖关系。证明了该熵模型的计算效率高于现有模型(他和谁比呀,一个注意力机制...)。

limitation

\(\quad\)该熵模型不能并行解码,因为自回归先验本身只使用先前解码的元素,期望这个问题可以通过将该方法与通道级自回归模型或双向上下文模型相结合来解决

官方代码可以跑通

浙公网安备 33010602011771号

浙公网安备 33010602011771号