安装spark和python练习

一、安装Spark

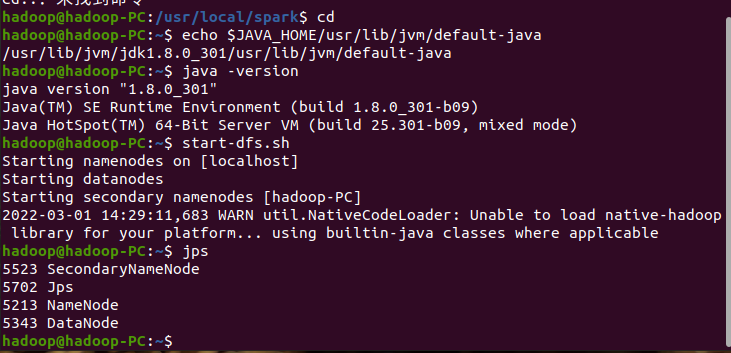

1.检查基础环境的hadoop

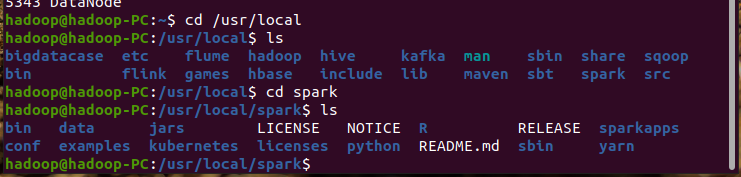

2.下载,解压文件

sudo tar -zxvf ./ 解压./后的文件

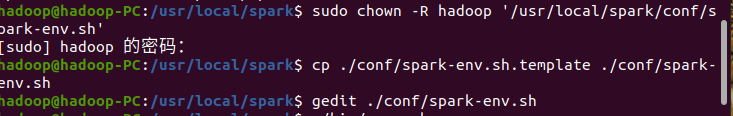

3.配置文件

编辑该配置文件,在文件最后面加上如下一行内容:

export SPARK_DIST_CLASSPATH=$(/usr/local/hadoop/bin/hadoop classpath)

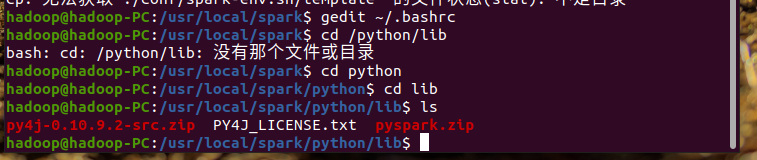

4.环境变量

在gedit ~/.bashrc加入代码

export SPARK_HOME=/usr/local/spark export PYTHONPATH=$SPARK_HOME/python:$SPARK_HOME/python/lib/py4j-0.10.9-src.zip:PYTHONPATH export PYSPARK_PYTHON=python3 export PATH=$PATH:$SPARK_HOME/bin

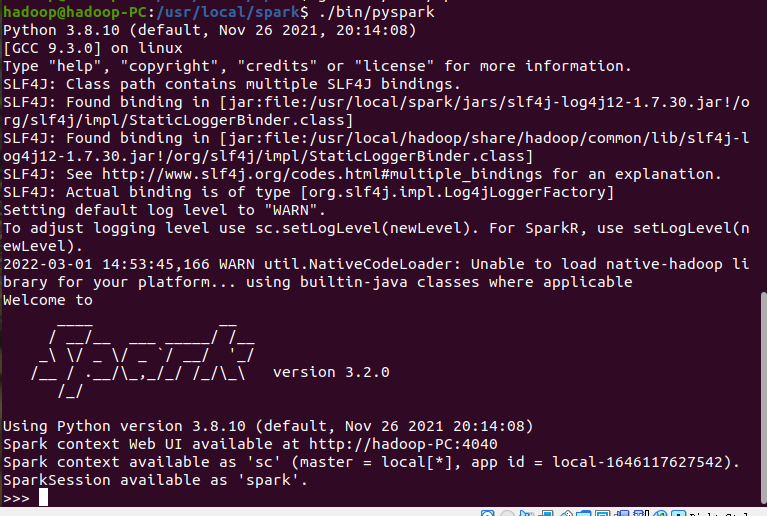

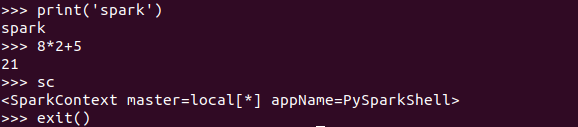

5.启动pyspark

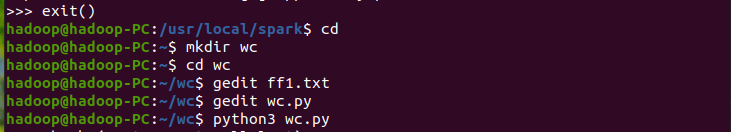

二、Python编程练习:英文文本的词频统计

1.准备文本文档

上百度复制一段英文即可

在gedit wc.py

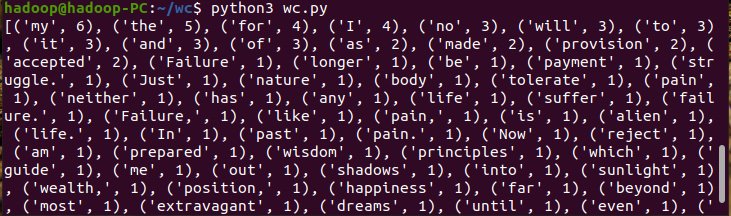

path='/home/hadoop/wc/ff1.txt'

with open(path) as f:

text=f.read()

words = text.split()

wc={}

for word in words:

wc[word]=wc.get(word,0)+1

wclist=list(wc.items())

wclist.sort(key=lambda x:x[1],reverse=True)

print(wclist)

浙公网安备 33010602011771号

浙公网安备 33010602011771号