m基于Q-Learning强化学习的迷宫路线规划策略matlab仿真

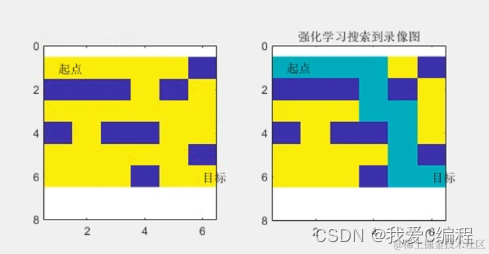

1.算法仿真效果

matlab2022a仿真结果如下:

2.算法涉及理论知识概要

Q-Learning是一种无模型的强化学习算法,它能够使代理(Agent)在与环境互动的过程中学习最优策略,无需了解环境的完整动态模型。在迷宫路线规划问题中,Q-Learning被用来指导代理找到从起点到终点的最优路径,通过不断尝试和学习来优化其行为决策。

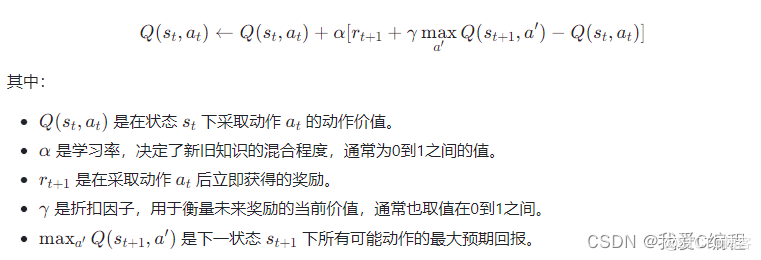

Q-Learning属于值函数方法,其核心思想是通过迭代更新一个动作价值函数Q(s,a),该函数评估在状态s采取动作a后,预期的长期奖励。更新过程遵循贝尔曼方程,同时利用了探索(Exploration)和利用(Exploitation)的概念,以平衡对未知状态的探索和已知有利路径的利用。

Q-Learning的更新公式如下:

为了平衡探索与利用,通常采用ε-greedy策略,即以概率ε随机选择一个动作,以1-ε的概率选择当前状态下Q值最大的动作。ε通常随着时间逐渐减小,鼓励代理逐渐从探索转向利用学到的知识。

在迷宫路线规划中,迷宫被建模为一个状态空间,每个格子(或状态)代表代理可以到达的位置。动作空间通常包括上下左右四个移动方向。奖励设置为:

到达终点给予大量正奖励。

遇到墙壁或非法移动给予零奖励或轻微负奖励。

在其他合法格子移动给予小的负奖励或零奖励,以鼓励尽快到达终点。

3.MATLAB核心程序

while (1)

% 查找当前状态下可执行的动作(即下一状态)

Action = find(R(State_current,:) >= 0); % 找出当前状态下可行的下一状态

% 随机选择下一个状态

State_next = Action(randi([1 length(Action)],1,1));

% 查找下一个状态下可执行的动作

Action = find(R(State_next,:) >= 0);

% 初始化最大Q值

Q_max = 0;

% 寻找当前状态下所有可能动作的最大Q值

for j = 1:length(Action)

Q_max = max(Q_max,Q(State_next,Action(j)));

end

% 更新Q值

Q(State_current,State_next) = R(State_current,State_next) + gamma * Q_max;

% 检查当前状态是否为目标状态

if (State_current == State_goal)

break; % 若找到目标状态,则跳出循环

end

% 更新当前状态

State_current = State_next;

end

浙公网安备 33010602011771号

浙公网安备 33010602011771号