Python:查看robots协议

Robots协议:

Robots Exclusion Standard(网络爬虫排除标准)

作用:

网站告知可以爬取的页面,不能爬取的页面

位置:

网站根目录下的robots.txt文件中

查看:

在地址栏中输入/robots.txt查看

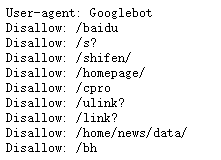

以csdn为例:

https://www.csdn.net/robots.txt

![]()

*代表所有,/代表根目录

User-agent: * 表示:无论什么爬虫,都应该遵守这个协议。

Disallow: 表示不允许。即任何爬虫都不允许爬取/scripts等一系列路径。

//Hhh 百度的robots协议不允许Googlebot访问

浙公网安备 33010602011771号

浙公网安备 33010602011771号