(补交 原因忘了交)作业6;作业7;

6.RDD综合练习:更丰富的操作

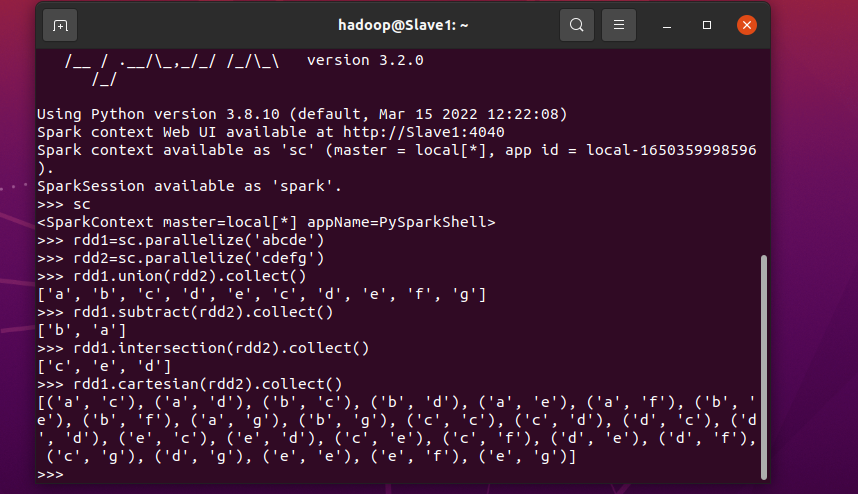

集合运算联系(union\intersection\subtract\cartesian)

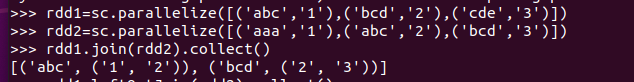

内连接与外连接(join\left\rightOuterJoin\fullOuterJoin)

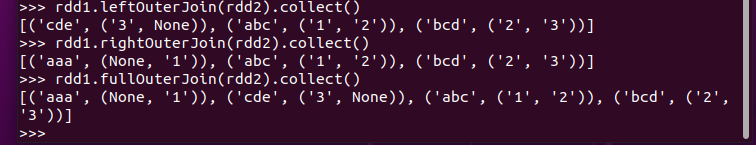

多个考勤文件,签到日期汇总,出勤次数统计

三、综合练习:学生课程分数

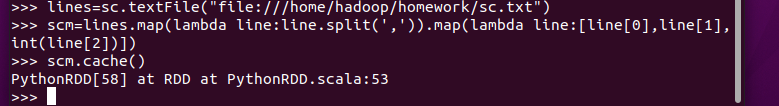

网盘下载sc.txt文件,通过RDD操作实现以下数据分析:

持久化 scm.cache()

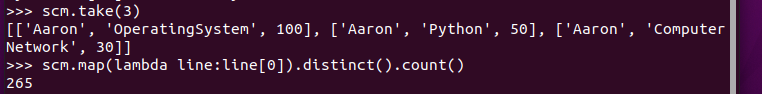

总共有多少学生?map(), distinct(), count()

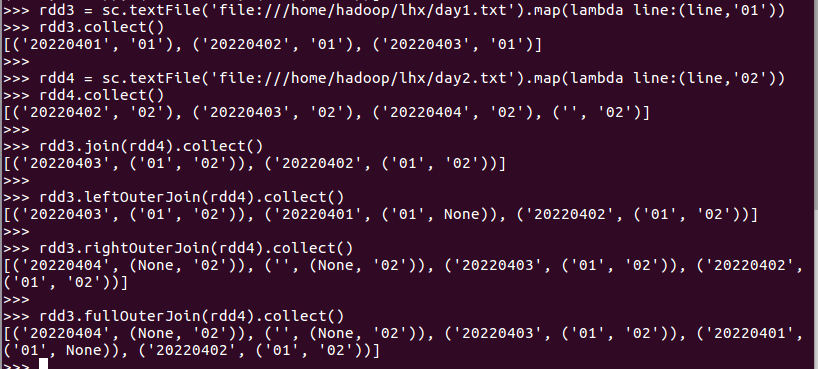

开设了多少门课程?

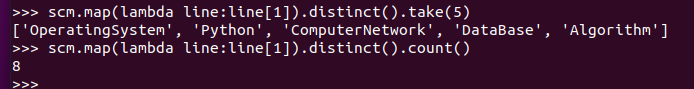

生成(姓名,课程分数)键值对RDD,观察keys(),values()

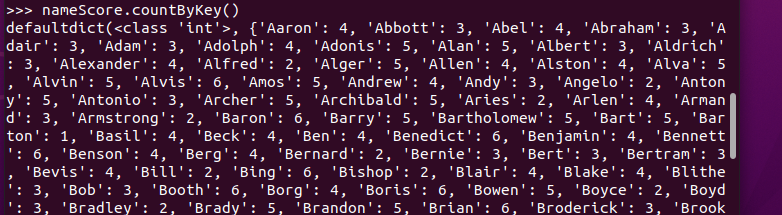

每个学生选修了多少门课?map(), countByKey()

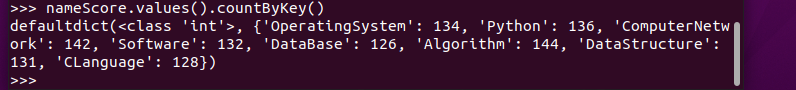

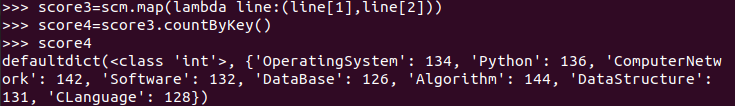

每门课程有多少个学生选?map(), countByValue()

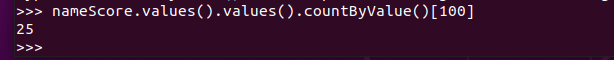

有多少个100分?

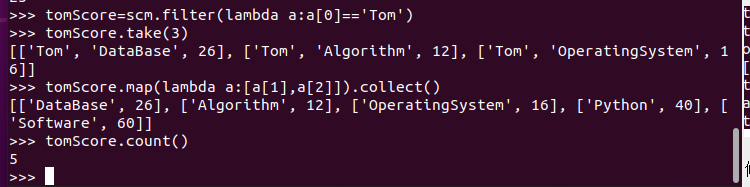

Tom选修了几门课?每门课多少分?filter(), map() RDD

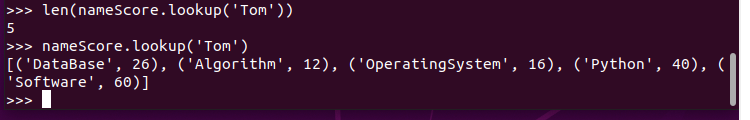

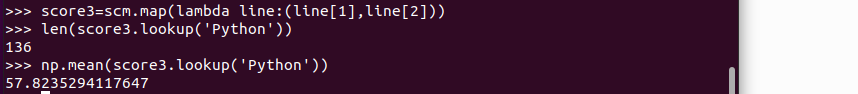

Tom选修了几门课?每门课多少分?map(),lookup() list

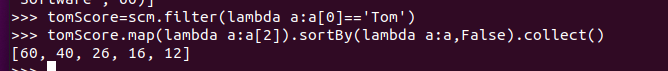

Tom的成绩按分数大小排序。filter(), map(), sortBy()

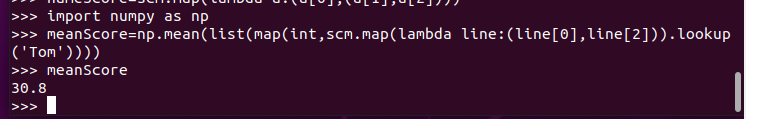

Tom的平均分。map(),lookup(),mean()

生成(姓名课程,分数)RDD,观察keys(),values()

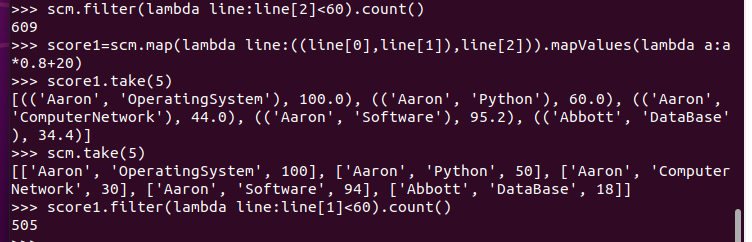

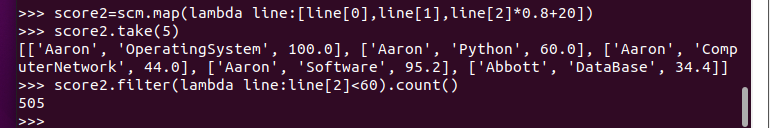

每个分数+20平时分。

分别用mapValues(func)和 map(func)实现。

并查看不及格人数的变化。

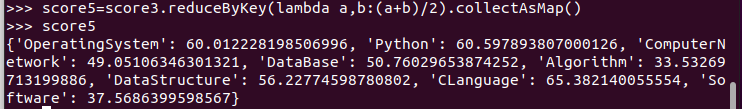

求每门课的选修人数及平均分

lookup(),np.mean()实现

reduceByKey()和collectAsMap()实现

combineByKey(),map(),round()实现,确到2位小数

比较几种方法的异同。

7.SparkSQL

1.请分析SparkSQL出现的原因,并简述SparkSQL的起源与发展

Hadoop刚开始出来的时候,使用的是hadoop自带的分布式计算系统MapReduce,但是MapReduce的使用难度较大,所以就开发了Hive,Hive编程用的是类SQL的HQL的语句,这样编程的难度就大大的降低了,Hive的运行原理就是将HQL语句经过语法解析、逻辑计划、物理计划转化成MapReduce程序执行。当Spark出来以后,Spark团队也开发了一个Shark,就是在Spark集群上安装一个Hive的集群,执行引擎是Hive转化成Mapreduce的执行引擎,这样的框架就是Hive on Spark,但是这样是有局限性的,因为Shark的版本升级是依赖Hive的版本的,所有2014年7月1日spark团队就将Shark转给Hive进行管理,Spark团队开发了一个SparkSQL,这个计算框架就是将Hive on Spark的将SQL语句转化为Spark RDD的执行引擎换成自己团队从新开发的执行引擎。Spark SQL经历了几次的更新,演变历程如下:

-1 1.0版本以前:Hive on Spark Shark

-2 1.0.x版本:Spark SQL、Alpha版本(测试版本,不建议商业项目使用)、这个版本让Spark升为了Apache的顶级项目。

-3 1.3.x版本、SparkSQL DataFrame、Release(成熟,可以使用)

-4 spark 1.5.x版本、钨丝计划(底层代码的优化)

-5 spark 1.6.x版本、DataSet(alpha版本)

-6 Spark 2.x.x版本、DataSet(正式的)、Structrued Streaming

简述RDD 和DataFrame的联系与区别?

区别:

RDD是分布式的java对象的集合,但是对象内部结构对于RDD而言却是不可知的。

DataFrame是一种以RDD为基础的分布式数据集,提供了详细的结构信息,相当于关系数据库中的一张表。

联系:

1.都是spark平台下的分布式弹性数据集,为处理超大型数据提供便利。

2、都有惰性机制,在进行创建、转换,如map方法时,不会立即执行,只有在遇到Action才会运算。

3.都会根据spark的内存情况自动缓存运算,这样即使数据量很大,也不用担心会内存溢出

4、三者都有partition的概念。

5.三者有许多共同的函数,如filter,排序等

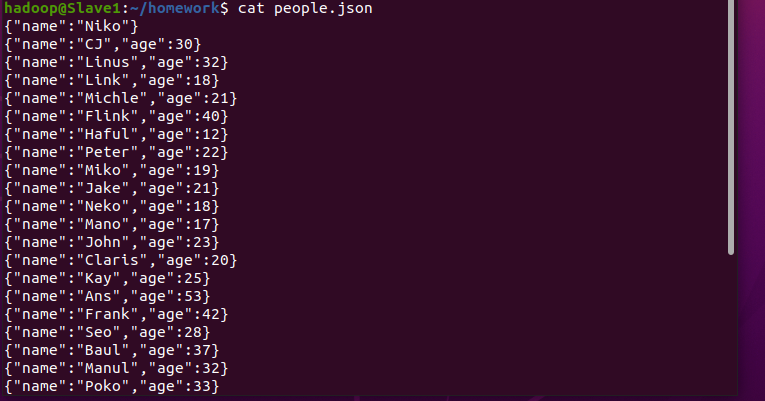

DataFrame的创建

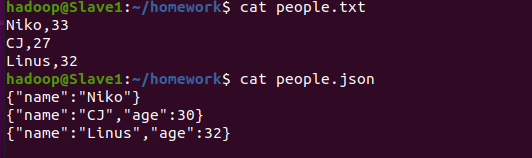

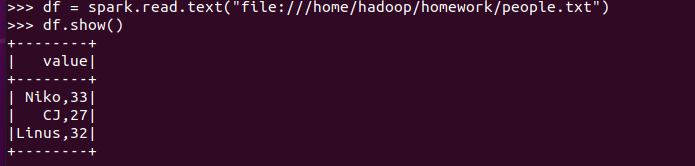

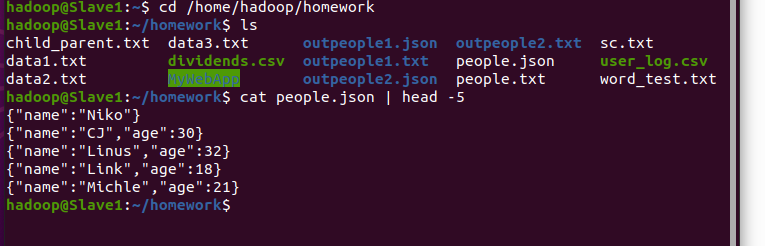

spark.read.text(url)

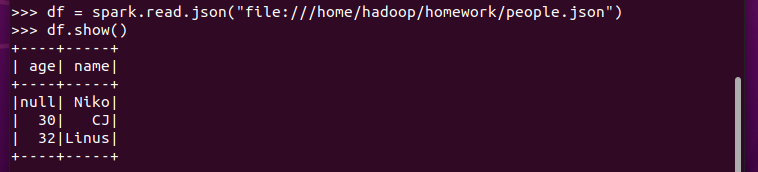

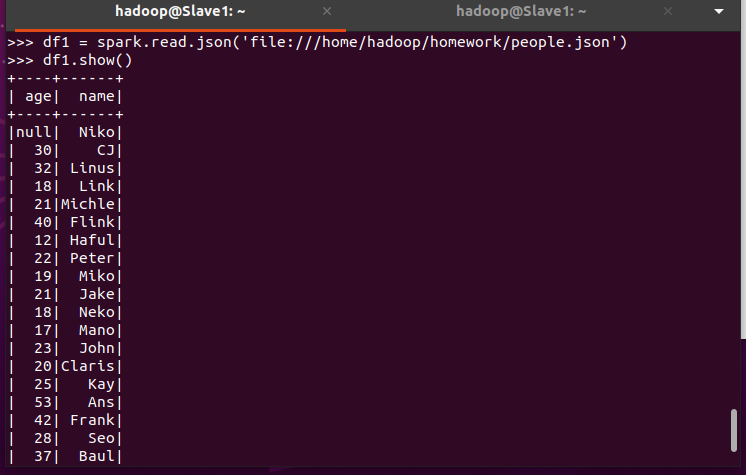

spark.read.json(url) 注意从不同文件类型生成DataFrame的区别。

spark.read.format("text").load("people.txt")

spark.read.format("json").load("people.json")

PySpark-DataFrame各种常用操作

基于df的操作:

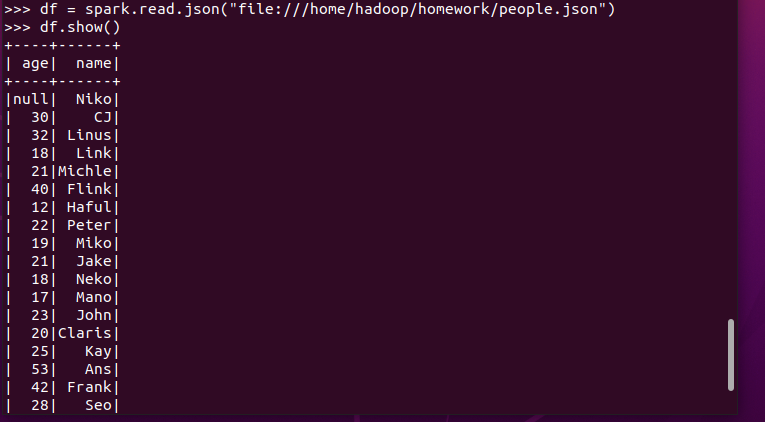

打印数据 df.show()默认打印前20条数据

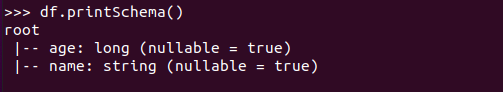

打印概要 df.printSchema()

查询总行数 df.count()

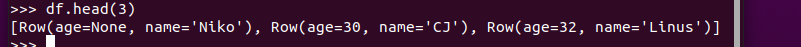

df.head(3) #list类型,list中每个元素是Row类

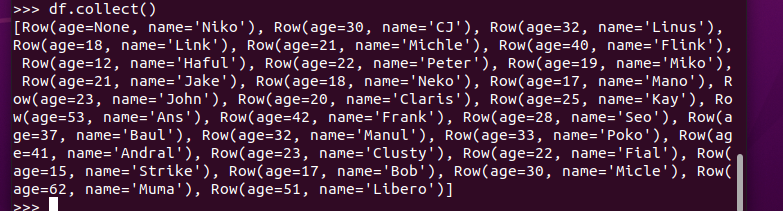

输出全部行 df.collect() #list类型,list中每个元素是Row类

查询概况 df.describe().show()

取列 df[‘name’], df.name, df[1]

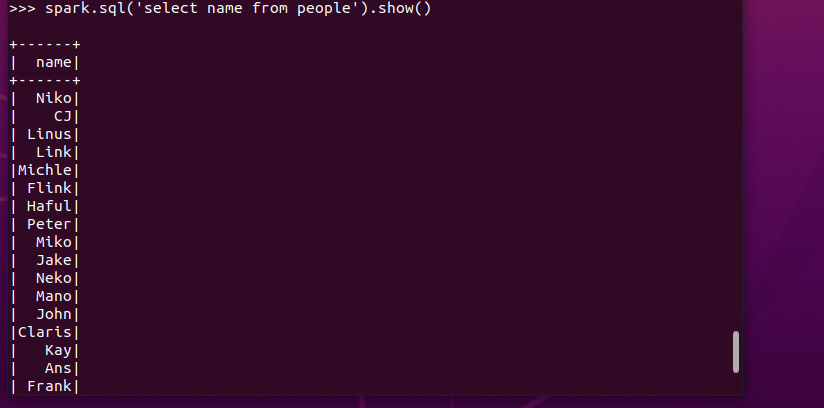

基于spark.sql的操作:

创建临时表虚拟表 df.registerTempTable('people')

spark.sql执行SQL语句 spark.sql('select name from people').show()

Pyspark中DataFrame与pandas中DataFrame

分别从文件创建DataFrame

比较两者的异同

pandas中DataFrame转换为Pyspark中DataFrame

Pyspark中DataFrame转换为pandas中DataFrame

1.地址写法不同

2.pyspark的df要通过操作查看结果

3.pandas的df自动加索引

从RDD转换得到DataFrame

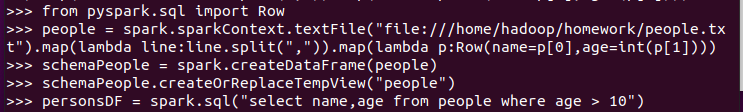

6.1 利用反射机制推断RDD模式

创建RDD sc.textFile(url).map(),读文件,分割数据项

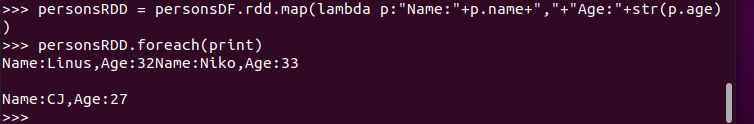

每个RDD元素转换成 Row

由Row-RDD转换到DataFrame

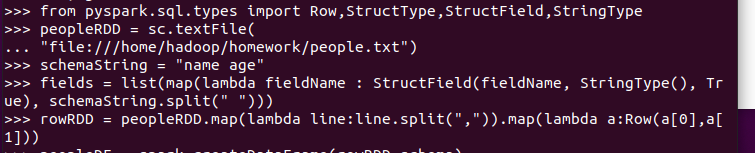

6.2 使用编程方式定义RDD模式

#下面生成“表头”

#下面生成“表中的记录”

#下面把“表头”和“表中的记录”拼装在一起

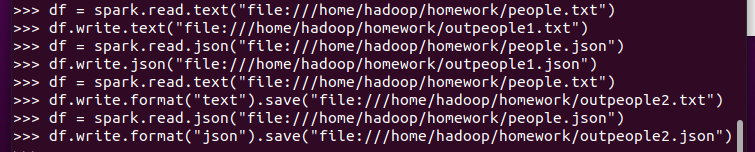

DataFrame的保存

df.write.text(dir)

df.write.json(dri)

df.write.format("text").save(dir)

df.write.format("json").save(dir)

浙公网安备 33010602011771号

浙公网安备 33010602011771号