爬虫综合大作业

作业要求来自于:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE1/homework/3159

一.把爬取的内容保存到数据库sqlite3

代码

1 import sqlite3 2 import pandas as pd 3 from pandas import DataFrame11 4 newsdf = pd.read_csv(r'C:\Users\Administrator\Desktop\newsmsg.csv', engine='python') 5 with sqlite3.connect('gzccnewsdb.sqlite') as db: 6 newsdf.to_sql('gzccnews',con = db) 7 with sqlite3.connect('gzccnewsdb.sqlite') as db: 8 df2 = pd.read_sql_query('SELECT * FROM gzccnews',con=db) 9 df2

运行效果

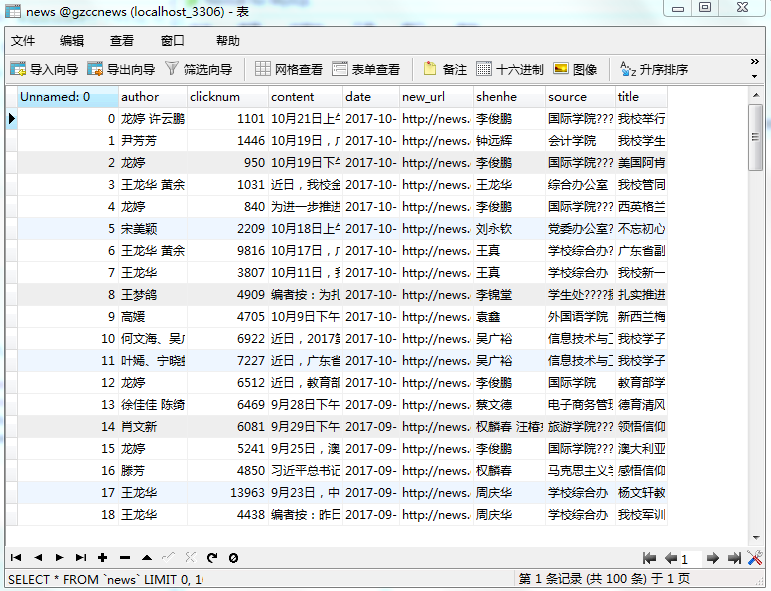

保存到MySQL数据库

代码

1 from pandas import DataFrame 2 import pandas as pd 3 import pymysql 4 from sqlalchemy import create_engine 5 6 newsdf = pd.read_csv(r'C:\Users\Administrator\Desktop\newsmsg.csv', engine='python') 7 conInfo = r"mysql+pymysql://root:@localhost:3306/gzccnews?charset=utf8" 8 engine = create_engine(conInfo,encoding='utf-8') 9 newsdf.to_sql(name='news', con=engine, if_exists='append', index=False)

运行效果

二.爬虫综合大作业

- 选择一个热点或者你感兴趣的主题。

- 选择爬取的对象与范围。

- 了解爬取对象的限制与约束。

- 爬取相应内容。

- 做数据分析与文本分析。

- 形成一篇文章,有说明、技术要点、有数据、有数据分析图形化展示与说明、文本分析图形化展示与说明。

- 文章公开发布。

爬虫综合大作业文章路径:https://www.cnblogs.com/-QAQ/p/10848890.html

浙公网安备 33010602011771号

浙公网安备 33010602011771号