12 2020 档案

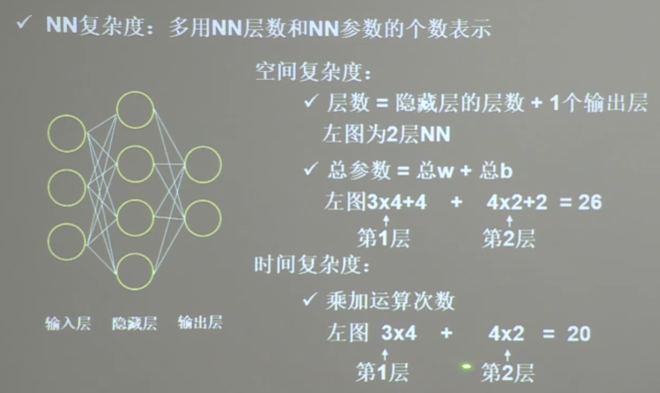

摘要:Sequential 相当于一个容器,里面封装了一个神经网络结构 model=tf.keras.model.Sequential([网络结构]) 常用网络结构 拉直层:tf.keras.layers.Flatten() 将输入变为一维数组 全连接层:tf.keras.layers.Dense(神经元

阅读全文

摘要:欠拟合解决方法:增加输入特征项,增加网络参数,减少正则化参数 过拟合解决方法:数据清洗,增大训练集,采用正则化,增大正则化参数

阅读全文

摘要:使输出不再是x的线性关系,增强神经网络的表达力。 优秀的激活函数:非线性,可微性,单调性,近似恒等性。 输出范围:有限值,基于梯度,无限值,调小学习率。 sigmoid函数:求导后为0-0.25。易造成梯度消失,输出非0均值收敛慢,幂运算复杂训练时间长。 Tanh函数:易造成梯度消失,幂运算复杂训练

阅读全文

摘要:

阅读全文

摘要:

阅读全文

摘要:import tensorflow as tf import numpy as np "tf.where(),条件语句,真返回a" a = tf.constant([1, 2, 3, 1, 1]) b = tf.constant([0, 1, 3, 4, 5]) c = tf.where(tf.gr

阅读全文

摘要:"求沿指定维度的平均值、和(axis=1沿行向量方向)" x = tf.constant([[1, 2, 3], [2, 2, 3]]) print("x:", x) print("mean of x:", tf.reduce_mean(x)) # 求x中所有数的均值 print("sum of x

阅读全文

摘要:"将Numpy数组转换为张量" a = np.arange(0,5) print("数组a:",a) b = tf.convert_to_tensor(a,dtype=tf.int64) print("张量b:",b) "创建全为0的张量" zero_Tensor = tf.zeros([2,3])

阅读全文

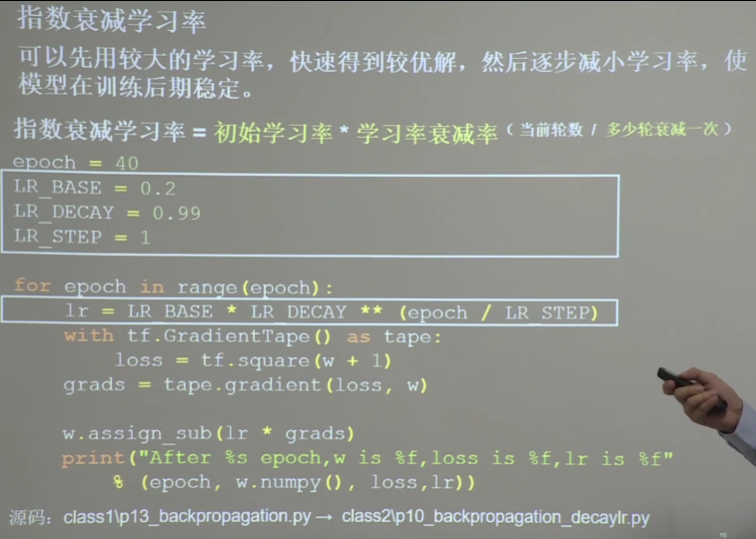

摘要:梯度带tf.GradientTape(自动求梯度) Tensorflow 会把 'tf.GradientTape' 上下文中执行的所有操作都记录在一个磁带上 ("tape")。 然后基于这个磁带和每次操作产生的导数,用反向微分法("reverse mode differentiation")来计算这

阅读全文

摘要:先推断再决策。 用推断得到的后验概率P(O|x)=P(x|O)P(O)/P(x)来求P(x'|X)

阅读全文

浙公网安备 33010602011771号

浙公网安备 33010602011771号