摘要:

我们把小说名、是否完结、男主名字、女主名字都给爬取下来 import requests import re url = "http://m.pinsuu.com/paihang/nanpindushi/" headers = { "User-Agent": "Mozilla/5.0 (Linux; 阅读全文

posted @ 2021-12-11 21:51

不是孩子了

阅读(88)

评论(0)

推荐(0)

摘要:

将提取的内容放到一个组中,通过这个组的名字获取我们想要的内容 阅读全文

posted @ 2021-12-11 20:20

不是孩子了

阅读(19)

评论(0)

推荐(0)

摘要:

import re # 前缀r表示这个是正则表达式,没有也可以,但是加上更规范,就像二进制、十六进制一样 # findAll:查找所有满足正则表达式的内容,但是用的不多,因为用的列表,列表效率并不高 list = re.findall(r"\d+", "我的手机号码是10086, 你的手机号码是10 阅读全文

posted @ 2021-12-11 19:18

不是孩子了

阅读(37)

评论(0)

推荐(0)

摘要:

每一个元字符默认只匹配一个字符,例如一个点匹配的是一个字符,两个点匹配的就是两个字符 / / / / / / / / / / (1)贪婪匹配 *先找到“玩儿”,然后通过.尽可能多的匹配,然后找到最远的那个“游戏” (2)惰性匹配 先找到“玩儿”,然后尽可能多的匹配,然后因为有?又是尽可能少的匹配,所 阅读全文

posted @ 2021-12-11 18:56

不是孩子了

阅读(36)

评论(0)

推荐(0)

摘要:

阅读全文

posted @ 2021-12-11 18:06

不是孩子了

阅读(39)

评论(0)

推荐(0)

摘要:

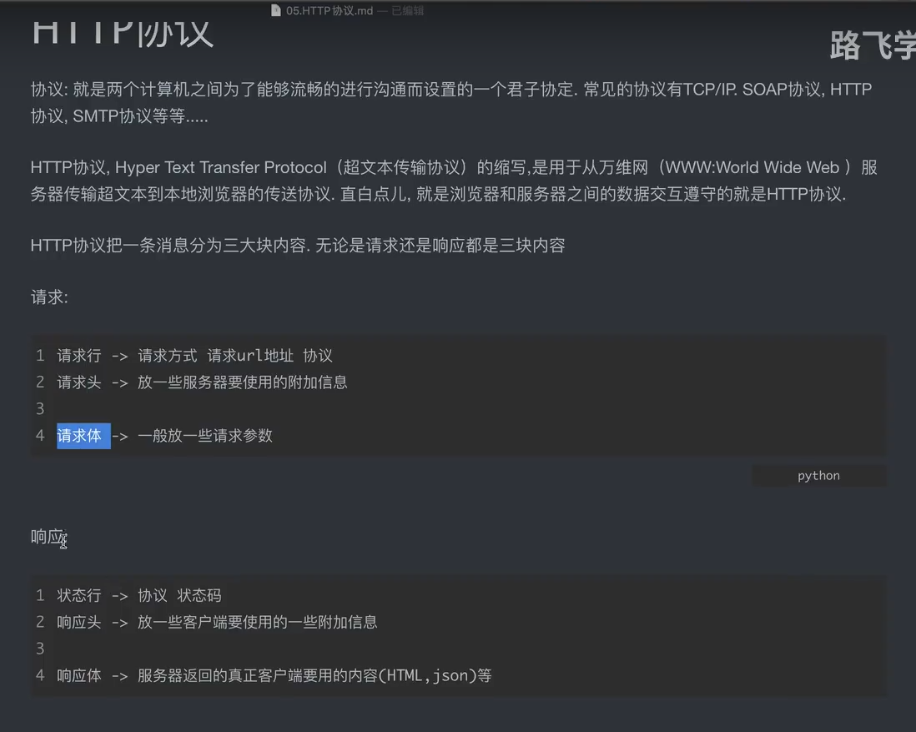

我们每次发送的相应resp都要关掉,如果我们访问类好多请求路径,每次的resp都没有关闭,可能会出现错误 resp.close() 阅读全文

posted @ 2021-12-11 18:02

不是孩子了

阅读(136)

评论(0)

推荐(0)

摘要:

请求地址是豆瓣电影排行榜的喜剧类别 / / / / / 但是输出内容为空,我们应该想到是不是有反爬机制,接下来我们去尝试解决反爬 / / / / 1、首先添加| User-Agent 成功 / / / / / / 页面展示内容有限,我们每次滑倒网页底部,又会重新发送请求,加载新的内容,通过循环查询更 阅读全文

posted @ 2021-12-11 17:50

不是孩子了

阅读(217)

评论(0)

推荐(0)

摘要:

我们爬取百度翻译的单词内容,通过抓包,sug包是我们需要的内容 并且是post请求方式,所以不可使用拼接参数的方式 通过请求参数获知提交给服务器的表单参数key是kw / / / / post方式,将数据放在字典中,通过data方式进行传递 发现出现了中文乱码,是因为服务器返回给我们的是json格式 阅读全文

posted @ 2021-12-11 16:55

不是孩子了

阅读(116)

评论(0)

推荐(1)

摘要:

首先安装第三方库:pip install requests 但是,搜狗的服务器校验我们是不是爬虫程序发出的请求,并没有返回给我们有用的信息 / / / / 我们可以给我们的程序添加请求头headers,查看浏览器的User-Agent,添加到我们的程序中,模拟是浏览器发出的请求即可。 处理反爬: / 阅读全文

posted @ 2021-12-11 16:43

不是孩子了

阅读(59)

评论(0)

推荐(0)

摘要:

阅读全文

posted @ 2021-12-11 16:03

不是孩子了

阅读(30)

评论(0)

推荐(0)

浙公网安备 33010602011771号

浙公网安备 33010602011771号