《机器学习》第一次作业——第一至三章学习记录和心得

模式识别基本概念

特征向量相关性

点积

投影

投影向量

残差向量:投影向量和原向量x的误差

欧氏距离

区别:是在计算向量差异性的时候,衡量的方式不同

机器学习基本概念

训练样本:应覆盖模型所有的分布空间

模型:结构和参数

线性模型:$$

非线性模型:模型结构是非线性的(曲线、曲面、超曲面)

训练样本量对比模型参数量

- N=M:参数有唯一解

- N>>M,Over-determined:没有准确解

- 目标函数(代价函数/损失函数):额外添加一个标准,通过优化该标准确定一个近似解

- 优化算法:最小(大)化目标函数,最终得到模型参数最优解

- N<<M,Under-determined:无数个解/无解

- 添加对参数额外的约束

机器学习的方式

监督式学习:给定训练样本和真值;回归、分类

无监督式学习:没有给定真值;聚类、图像分割、降维问题

半监督式学习:既有标注的训练样本,也有未标注的样本

强化学习:机器自行探索决策,真值滞后反馈的过程

策略->奖励-累积->回报值-期望值->价值函数-最大化->策略的参数

模型的泛化能力

泛化能力:学习算法对新出现模式的决策能力

误差:训练误差、测试误差

过拟合:模型过于拟合训练数据

提高泛化能力:

选择模型

正则化

超参数

验证集:从训练集划分出验证集,调整选择超参数

评估模型性能

- 留出法:随机划分,取统计值

- K折交叉验证

- 留一验证:计算开销大

性能指标度量

准确度

精度Precision:真正例/(真正例+假正例)

召回率Recall:真正例 /(真正例+假反例)

F-Score:加权平均综合精度Precision和Recall

混淆矩阵:actual-Predict,对角线数值越大越准确

曲线度量

- PR曲线

- ROC曲线:FPR-recall

AUC

基于距离的分类器

类的原型

代表类的模式或一组量

均值

最近邻

距离度量

欧氏距离

曼哈顿距离

加权欧式距离

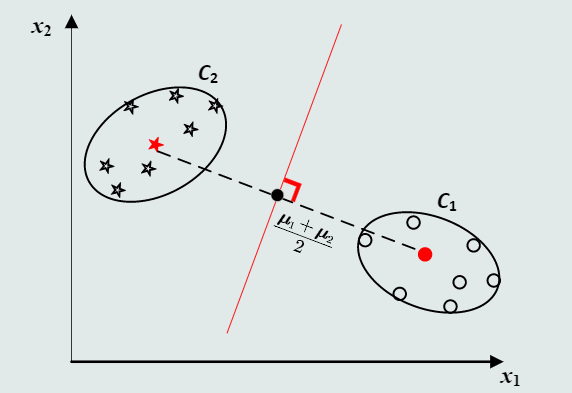

MED分类器

最小欧式距离分类器

欧式距离+均值

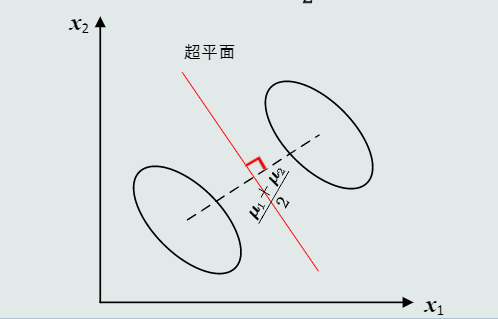

决策边界:直线(二分类)超平面(高维)

缺陷:每维特征的变化不同(对角)特征之间存在相关性(非对角)

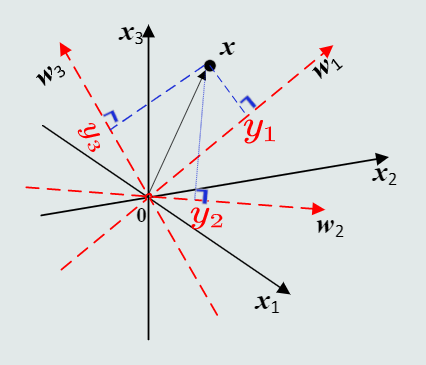

MICD分类器

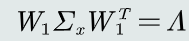

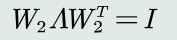

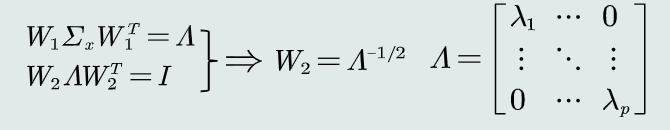

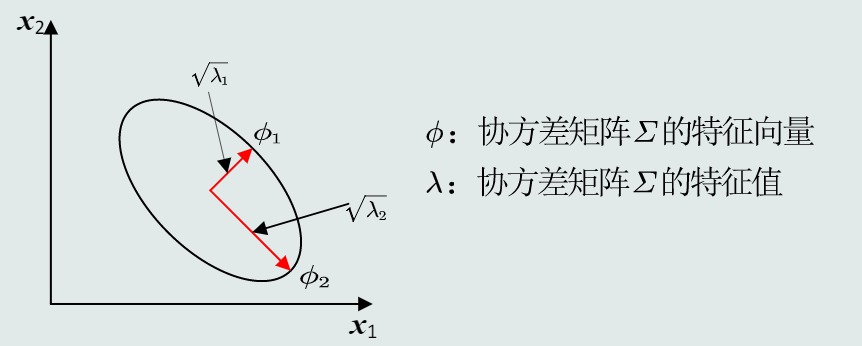

特征白化

通过映射使特征的协方差矩阵为单位矩阵,从而去除特征之间的相关性

-

解耦:去除特征之间的相关性

-

白化:对特征进行尺度变化

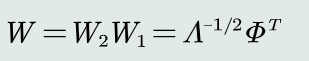

结合以上两步后,求解转换矩阵W

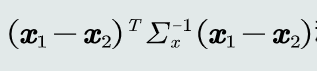

马氏距离:经过W转换后的欧式距离

MICD

最小类内距离分类器

马氏距离+均值

等距图:有向超椭圆面

决策边界:超抛物/双曲面

缺陷:会选择方差较大的类

贝叶斯决策

引入概率:通过采样,找出数据中蕴含的概率分布规律

推理决策:找到某模式后验概率最大的那个类

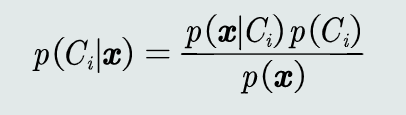

贝叶斯公式:

MAP分类器

将测试样本决策分类给后验概率最大的类

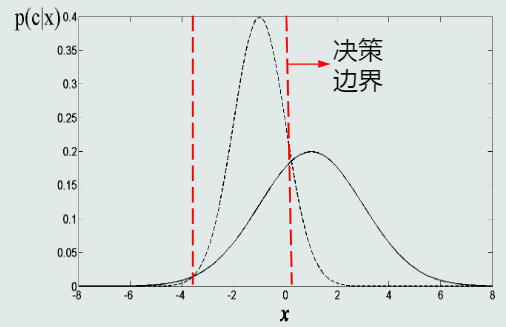

决策边界:两条直线(单维)复杂非线性平面(高维)

误差分析(平均概率误差):

贝叶斯分类器

决策风险

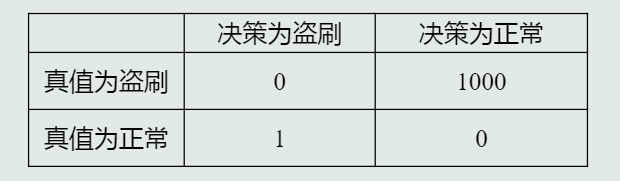

预测在作出错误判断时会带来的风险:定义一个惩罚量损失,表征当前决策的相对其他候选类别的风险

可用一个矩阵表示动作-类别的损失值(损失值可手动设计或通过机器学习训练获得)

例:信用卡盗刷的损失矩阵

贝叶斯分类器

在MAP分类器的基础上加入决策风险因素,选择决策风险最小的类

朴素贝叶斯分类器

便于学习多维特征之间的相关性

拒绝选项

在决策的类别后验概率小于设定的阈值时,进行拒绝以避免错误。

监督式学习

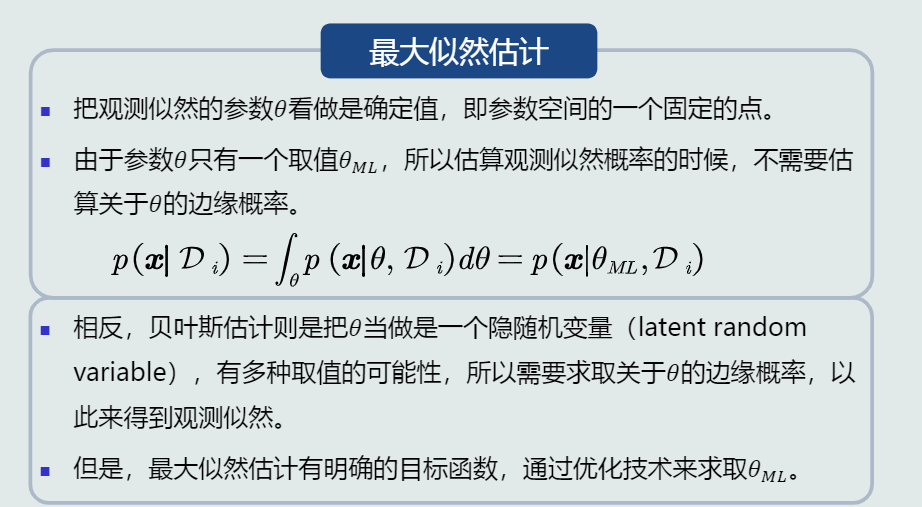

参数化方法:给定概率分布解析式,对解析式中的参数进行学习(最大似然估计、贝叶斯估计)

非参数化方法:基于概率密度估计技术,估计非参数化的概率密度表达(KNN估计)

参数化方法

最大似然估计

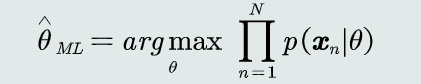

最大似然估计:学习目标使如下似然函数最大

估计偏差(以正态分布为例)

- 均值:无偏估计

- 协方差:有偏估计,(乘以N/(N-1)修正)

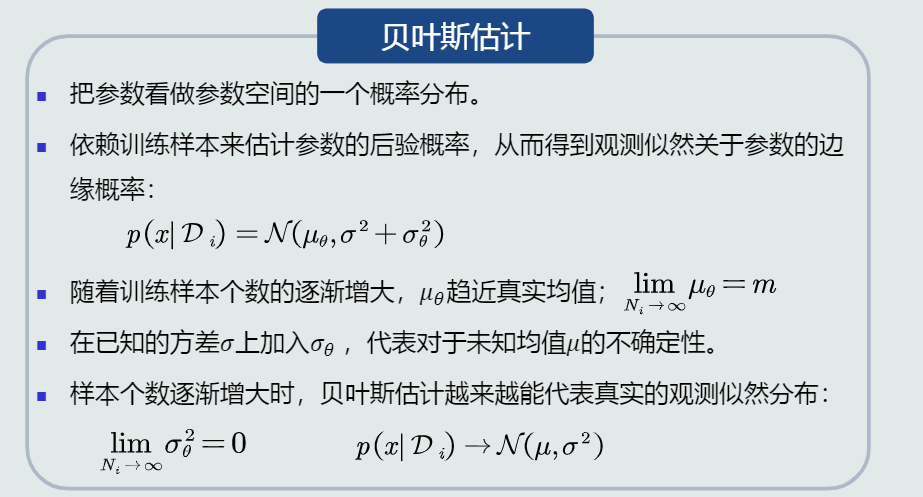

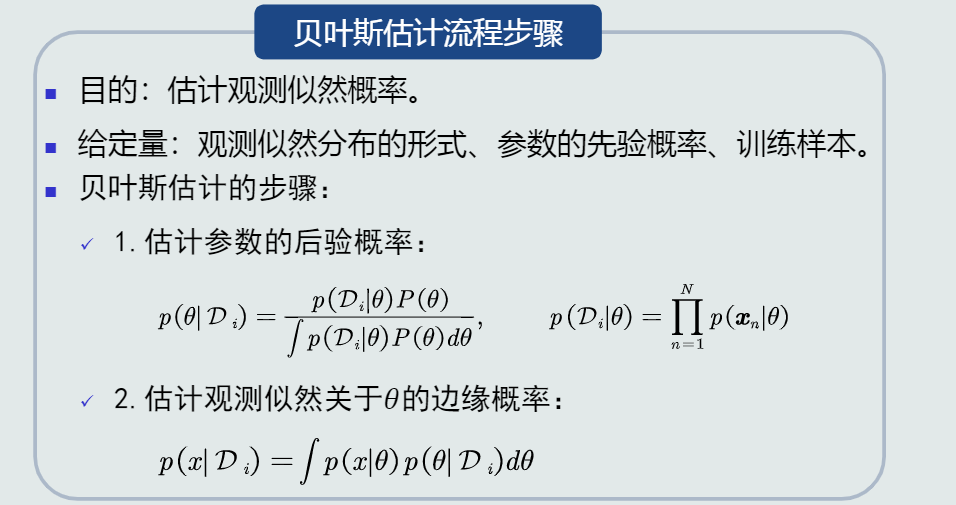

贝叶斯估计

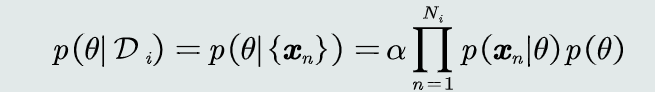

将待学习的的参数也作为一个随机变量,通过给定该参数的先验概率和训练样本,估计该参数后验概率

利用贝叶斯公式得到参数后验概率:

具有不断学习的能力:

- 在最初能基于少量样本给出不太准确的估计

- 随着训练样本增加,串行的不断修正参数估计值,从而趋近其期望真值

无参数化方法

概率分布形式未知,常用K邻近法(KNN)、直方图估计、核密度估计等无参数方法

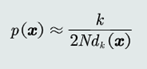

KNN估计

KNN估计:给定x,找到其对应的区域R使其包含k个训练样本,以此计算p(x)、

概率密度的表达式

KNN估计的优缺点:

- 优点:可以自适应的确定x相关的区域R的范围。

- 缺点:KNN概率密度估计不是连续函数。

不是真正的概率密度表达,概率密度函数积分是∞而不是1。

直方图估计

原理:基于无参数概率密度估计的基本原理:

区域R的确定:

直接将特征空间分为m个格子(bins),每个格子即为一个区域R,即区域的位置固定。

平均分格子大小,所以每个格子的体积(带宽)设为V= h,即区域的大小固定。

相邻格子不重叠。

落到每个格子里的训练样本个数不固定,即k值不需要给定。

直方图估计的优缺点:

- 优点:

固定区域R:减少由于噪声污染造成的估计误差。

不需要存储训练样本。 - 缺点:

固定区域R的位置:如果模式x落在相邻格子的交界区域,意味着当前格子不是以模式x为中心,导致统计和概率估计不准确。

固定区域R的大小:缺乏概率估计的自适应能力,导致过于尖锐或平滑。

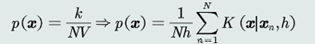

核密度估计

估计也是基于无参数概率密度估计的基本原理

区域R的确定:以任意待估计模式x为中心、固定带宽h,以此确定一个区域R。

概率密度估计

核函数可以是高斯分布、均匀分布、三角分布等。

核密度估计的优缺点:

- 优点:

以待估计模式x为中心、自适应确定区域R的位置(类似KNN)。

使用所有训练样本,而不是基于第k 个近邻点来估计概率密度,从而克服KNN估计存在的噪声影响。

如果核函数是连续,则估计的概率密度函数也是连续的。 - 缺点:

与直方图估计相比,核密度估计不提前根据训练样本估计每个格子的统计值,所以它必须要存储所有训练样本。