Spark 开发环境搭建

原文见 http://xiguada.org/spark-develop/

本文基于Spark 0.9.0,由于它基于Scala 2.10,因此必须安装Scala 2.10,否则将无法运行Spark作业。由于在windows环境下不方便执行命令行操作,因此建议在Linux环境下搭建Spark开发环境。

-

下载Spark 0.9.0(http://d3kbcqa49mib13.cloudfront.net/spark-0.9.0-incubating.tgz),并解压。

-

安装Scala2.10.X版本(http://www.scala-lang.org/download/)。

-

编译Spark 0.9.0,可以使用mvn –DskipTests install或 ./sbt/sbt assembly 编译。如果期间出现OOM异常,则需要加大MAVEN_OPTS的内存设置,如(export MAVEN_OPTS="-Xmx1024m")。

-

安装Eclipse(https://www.eclipse.org/downloads/),下载解压后运行eclipse。

-

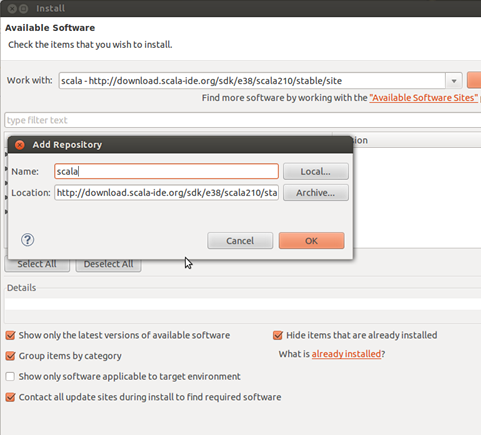

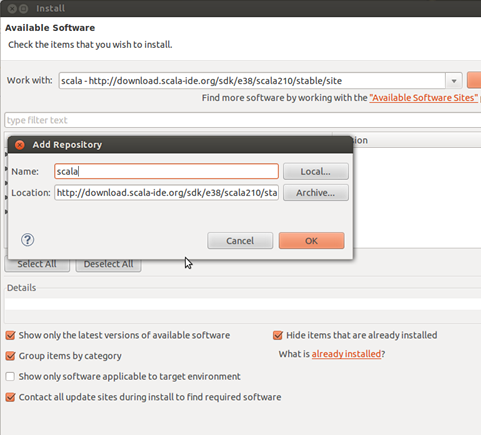

在eclipse中安装Scala-ide plugin,在"Help" -> "Install New Software" -> "add" 中输入http://download.scala-ide.org/sdk/e38/scala210/stable/site/。

-

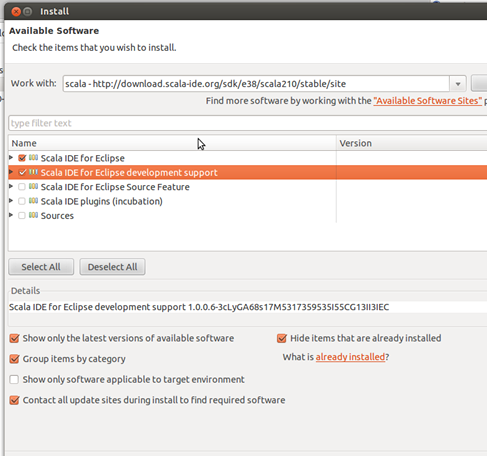

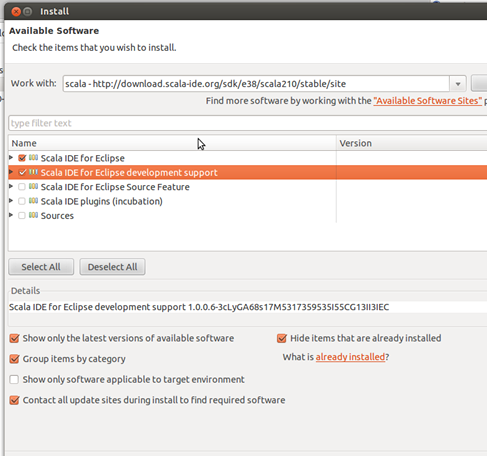

点击ok后,选择前两项,点击next后确认安装。

-

安装成功后,就可以加载spark工程。通过"New"->"Scala Project" ->"Use default location",选择已经编译后的Spark工程,确认后即可加载。加载后的Spark工程如下图所示。

-