Learning Scrapy笔记(五)- Scrapy登录网站

摘要:介绍了使用Scrapy登录简单网站的流程,不涉及验证码破解

简单登录

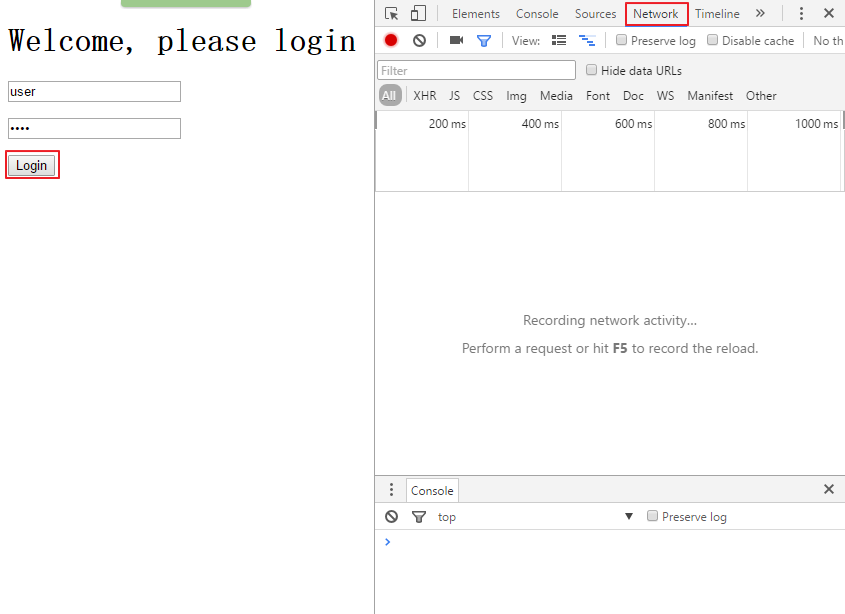

很多时候,你都会发现你需要爬取数据的网站都有一个登录机制,大多数情况下,都要求你输入正确的用户名和密码。现在就模拟这种情况,在浏览器打开网页:http://127.0.0.1:9312/dynamic,首先打开调试器,然后点击Elements标签,查看登录表单的源代码

再点击Network标签,然后在用户名框里输入user,在密码框里输入pass,再点击login按钮

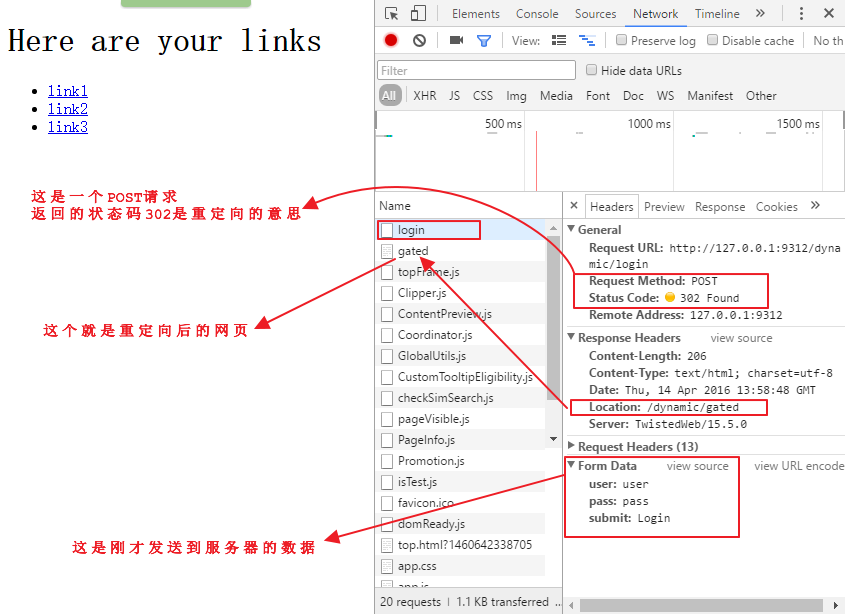

点击调试器里的login页面,观察下面的情况

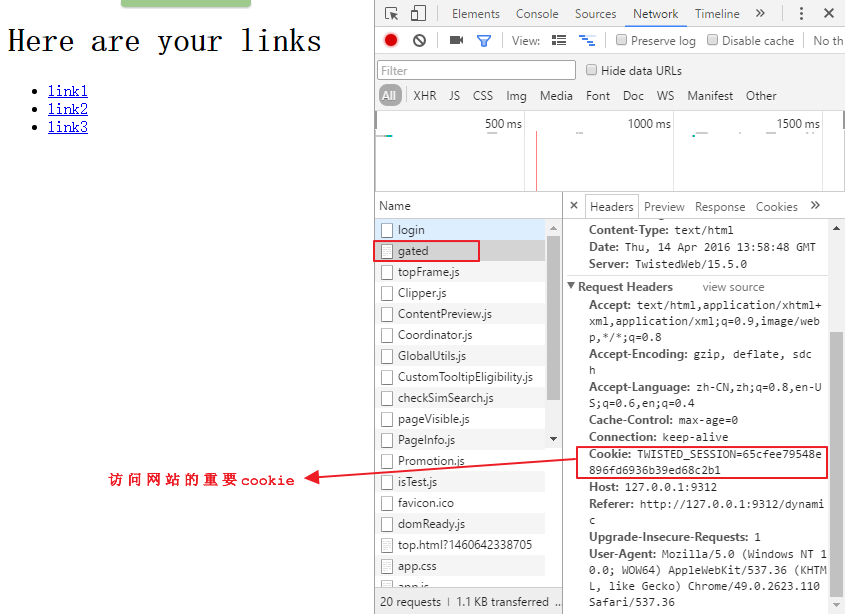

点击调试器里的gated页面,观察下面的情况

HTTP的cookie是由服务器发送给浏览器,由一些文本和数字组成的字符串,之后浏览器访问服务器的任何请求里都会带着这个cookie来标识你的身份和session,从而能够让你修改在这个网站上的个人信息。

总的来说,一个登录操作会包含几个从浏览器到服务器的往返操作,而Scrapy会自动处理这些操作。

login.py的源代码地址:

继续在上面的名为easy的spider上扩展代码,首先将easy.py复制为login.py,然后做以下修改:

-

将spider的名称修改为login

-

这里会使用FormRequest类来登录,这个类与之前的Request类很相似,只是带有额外的formdata参数用来传送登录的表单信息(用户名和密码),为了使用这个类,需要使用以下语句导入:from scrapy.http import FormRequest

-

然后用startrequests()函数来代替starturls语句,这样做的原因是我们需要定制更多的参数,最后的函数是这样的

# Start with a login request def start_requests(self): return [ FormRequest( "http://web:9312/dynamic/login", formdata={"user": "user", "pass": "pass"} #formdata字典里的key名就是第一张图中用红线标注的input标签中的name值 )]

就这么简单,Scrapy会自动为我们处理cookie,只要我们登录成功了,它就会像一个浏览器一样自动传送cookie.

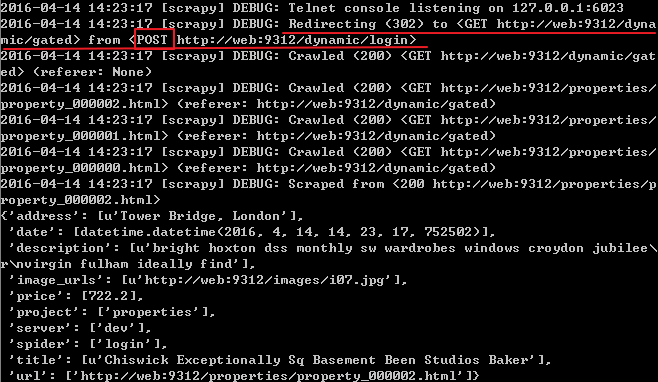

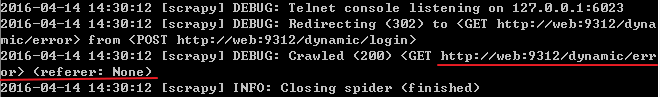

现在运行这个spider:scrapy crawl login

可以看到上面红线处首先向login页面提交了一个POST请求,然后重定向到了gated页面,再用一个GET请求得到了该页面,如果用错了用户名和密码,就会得到错误的结果

上面是一个极其简单的登录机制,大多数网站其实会使用更加复杂的登录机制,下面的这个例子就使用了隐藏数据

带有隐藏数据的登录

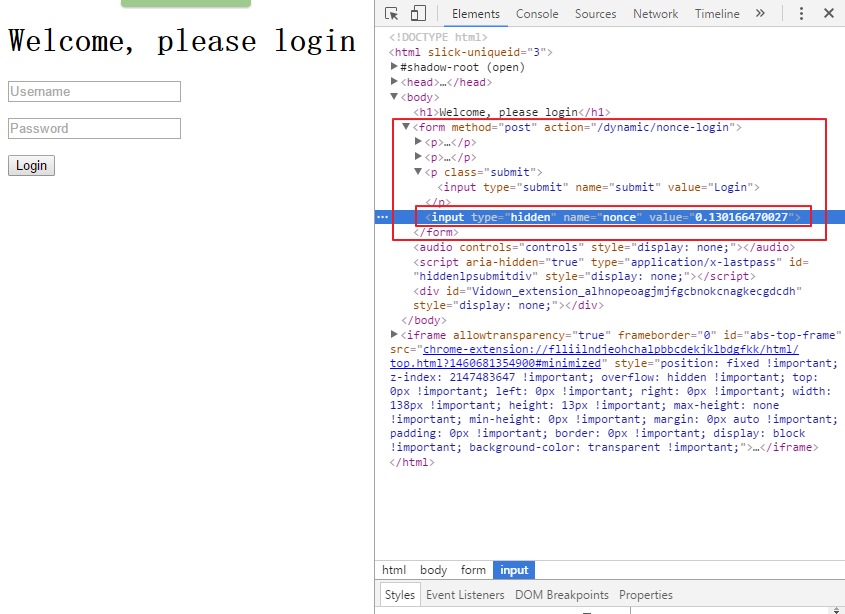

在浏览器打开页面:http://127.0.0.1:9312/dynamic/nonce,然后用调试器定位到登录按钮,可以看到如下界面

与第一个登录情况不同的是可以看到这个表单有一个叫做nonce的隐藏字段,当你按下Login按钮时,向服务器发送的数据包括用户名和密码,还有这个属性的值。你不可能猜到这个属性的值,因为这是一个一次性的随机数,这意味着你在Scrapy登录时需要两个发送两个请求,首先得到表单里的数据,然后再填充登录数据,Scrapy已经集成了这些功能。

noncelogin.py文件的源代码地址:

将之前的login.py文件复制为noncelogin.py文件,做如下改变:

-

导入Request:from scrapy.http import Request

-

将spider的名称修改为noncelogin

-

将start_request函数修改如下

#这个函数返回了一个Request,在这个Request中已经指定了回调函数为parse_welcome,所以会把response传送到parse_welcome函数上 def start_requests(self): return [ Request("http://web:9312/dynamic/nonce", callback=self.parse_welcome) ]

- 增加一个parse_welcome函数如下

#接收到了包含表单全部数据的response(此时用户名和密码都是空,但是已经获取到了隐藏字段nonce的值),然后填充用户名和密码再登录 def parse_welcome(self, response): return FormRequest.from_response( response, formdata={"user": "user", "pass": "pass"} )

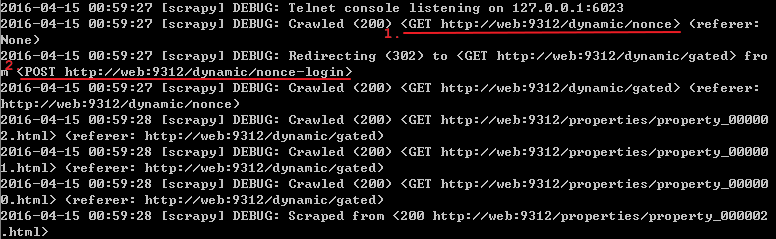

运行该spider:scrapy crawl noncelogin

之前所说的登录过程发送了两个请求指的就是上面标记了顺序1和2的两个请求(一个GET,一个POST)

值得注意的是form_response函数

(http://doc.scrapy.org/en/1.0/topics/request-response.html#topics-request-response-ref-request-userlogin),这个函数值得仔细研究,如果在登录页面有多个表单,此时就要用参数来指定究竟把用户名和密码填充到哪个表单上,同时,函数也默认模拟了对登录按钮的点击行为,要是网站使用了javascript来控制登录,此时函数的默认点击行为就可能出错,通过设置dont_click为True来禁止模拟点击.

上面只是使用了两个步骤来登录,但在面对更加复杂的登录方式时就需要组织更多的步骤.