nginx 实现Web应用程序的负载均衡

看到园子中的大牛代震军写的一篇玩玩负载均衡---在window与linux下配置nginx,一时兴起,自己动手配置了一翻,因此有了下面的记录。

不过是都是在一台机器上 :) 没环境。。。

介绍

Nginx(发音同 engine x)是一款轻量级的Web 服务器/反向代理服务器及电子邮件(IMAP/POP3)代理服务器,并在一个BSD-like 协议下发行。由俄罗斯的程序设计师Igor Sysoev所开发,最初供俄国大型的入口网站及搜寻引擎Rambler(俄文:Рамблер)使用。 其特点是占有内存少,并发能力强,事实上nginx的并发能力确实在同类型的网页伺服器中表现较好.目前中国大陆使用nginx网站用户有:新浪、网易、 腾讯,另外知名的微网志Plurk也使用nginx。

下载 nginx开发版 http://sysoev.ru/nginx/nginx-0.8.21.zip

不能用于实际的生产环境,因为限制了windows文件句柄数为1024,大于1024就会报maximum number of descriptors supported by select() is 1024 while connecting to upstream错误

在IIS新建两个网站指向同一个文件目录

端口分别为:7788 和 8384 至于端口的意义你懂的 哈~

9988端口保留给nginx使用

新建好了以后我们打开C:\nginx\conf\nginx.conf 文件将对应的 网址添加到“server {”的上方

upstream 每个设备的状态:

down 表示单前的server暂时不参与负载

weight 默认为1.weight越大,负载的权重就越大。

max_fails :允许请求失败的次数默认为1.当超过最大次数时,返回proxy_next_upstream 模块定义的错误

fail_timeout:max_fails 次失败后,暂停的时间。

backup: 其它所有的非backup机器down或者忙的时候,请求backup机器。所以这台机器压力会最轻。

upstream testsite{

server 127.0.0.1:7788;

server 127.0.0.1:8384;

}

或者

upstream testsite{

server 127.0.0.1:9090 down;

server 127.0.0.1:8080 weight=2;

server 127.0.0.1:6060;

server 127.0.0.1:7070 backup;}

因为nginx无法运行动态脚本,所以这里要使用proxy_pass属性进行代理,所以找到该配置文件的如下内容:

location / {

root html;

index index.html index.htm;

}

修改其内容如下:

location / {

proxy_pass http://testsite;

#proxy_set_header Host $host;

#proxy_set_header X-Real-IP $remote_addr; ;#防止ajax安全请求问题

#proxy_set_header REMOTE-HOST $remote_addr; ;#防止ajax安全请求问题

}

修改完之后,还要修改一下server的侦听端口,原内容如下:

server {

listen 80;

server_name localhost;

……修改完后的内容如下:

server {

listen 9988;

server_name 127.0.0.1;

location ~ ^/NginxStatus/ { stub_status on; #Nginx 状态监控配置 access_log off; }location ~ \.(htm|html|gif|jpg|jpeg|png|bmp|ico|css|js|txt)$ { root /opt/webapp; expires 24h; }

……

这样,nginx就会在启动之后开始侦听本地IP(127.0.0.1)的9988端口请求,当用户访问http://127.0.0.1:9988时nginx会将其请求转向到testsite中所指定的两个iis站点,并将执行的结果转发给客户端。如果一切配置正确,这时可以运行 nginx/nginx.exe (或在cmd下运行“start nginx”),就可以在任务管理器中看到一个nginx进程启动了。(注:如果配置文件有错误,可以到\nginx\logs\error.log查看错误日志,进一步排错)。

其中“location ~ ^/NginxStatus/ { ”内容是为了监控Nginx的运行状态而设置的

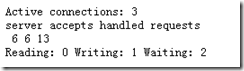

可以通过http://localhost/NginxStatus/ 访问得到

NginxStatus 显示的内容意思如下:

- active connections – 当前 Nginx 正处理的活动连接数。

- server accepts handled requests -- 总共处理了 6个连接 , 成功创建 6次握手 ( 证明中间没有失败的 ), 总共处理了 13个请求 ( 平均每次握手处理了 2.1 个数据请求 )。

- reading -- nginx 读取到客户端的 Header 信息数。

- writing -- nginx 返回给客户端的 Header 信息数。

- waiting -- 开启 keep-alive 的情况下,这个值等于 active - (reading + writing),意思就是 Nginx 已经处理完正在等候下一次请求指令的驻留连接。

“location ~ \.(htm|html|gif|jpg|jpeg|png|bmp|ico|css|js|txt)$ {”里面的内容为静态文件处理

通过正则表达式,我们可让 Nginx 识别出各种静态文件,例如 images 路径下的所有请求可以写为:

location ~ ^/images/ {

root /opt/webapp/images;

}

而下面的配置则定义了几种文件类型的请求处理方式。

location ~ \.(htm|html|gif|jpg|jpeg|png|bmp|ico|css|js|txt)$ {

root /opt/webapp;

expires 24h;

}

对于例如图片、静态 HTML 文件、js 脚本文件和 css 样式文件等,我们希望 Nginx 直接处理并返回给浏览器,这样可以大大的加快网页浏览时的速度。因此对于这类文件我们需要通过 root 指令来指定文件的存放路径,同时因为这类文件并不常修改,通过 expires指令来控制其在浏览器的缓存,以减少不必要的请求。 expires 指令可以控制 HTTP 应答中的“ Expires ”和“ Cache-Control ”的头标(起到控制页面缓存的作用)。您可以使用例如以下的格式来书写 Expires:

expires 1 January, 1970, 00:00:01 GMT; expires 60s; expires 30m; expires 24h; expires 1d; expires max; expires off;

配置负载均衡比较简单,但是最关键的一个问题是怎么实现多台服务器之间session的共享

下面有几种方法(以下内容来源于网络,第四种方法没有实践.)

1) 不使用session,换作cookie

能把session改成cookie,就能避开session的一些弊端,在从前看的一本J2EE的书上,也指明在集群系统中不能用session,否则惹出祸端来就不好办。如果系统不复杂,就优先考虑能否将session去掉,改动起来非常麻烦的话,再用下面的办法。

2) 应用服务器自行实现共享

asp.net可以用数据库或memcached来保存session,从而在asp.net本身建立了一个session集群,用这样的方式可以令 session保证稳定,即使某个节点有故障,session也不会丢失,适用于较为严格但请求量不高的场合。但是它的效率是不会很高的,不适用于对效率 要求高的场合。

以上两个办法都跟nginx没什么关系,下面来说说用nginx该如何处理:

3) ip_hash

nginx中的ip_hash技术能够将某个ip的请求定向到同一台后端,这样一来这个ip下的某个客户端和某个后端就能建立起稳固的session,ip_hash是在upstream配置中定义的:

upstream backend {

server 127.0.0.1:8080 ;

server 127.0.0.1:9090 ;

ip_hash;

}ip_hash是容易理解的,但是因为仅仅能用ip这个因子来分配后端,因此ip_hash是有缺陷的,不能在一些情况下使用:

1/ nginx不是最前端的服务器。ip_hash要求nginx一定是最前端的服务器,否则nginx得不到正确ip,就不能根据ip作hash。譬如使用的是squid为最前端,那么nginx取ip时只能得到squid的服务器ip地址,用这个地址来作分流是肯定错乱的。

2/ nginx的后端还有其它方式的负载均衡。假如nginx后端又有其它负载均衡,将请求又通过另外的方式分流了,那么某个客户端的请求肯定不能定位到同一台session应用服务器上。这么算起来,nginx后端只能直接指向应用服务器,或者再搭一个squid,然后指向应用服务器。最好的办法是用location作一次分流,将需要session的部分请求通过ip_hash分流,剩下的走其它后端去。

4) upstream_hash

为了解决ip_hash的一些问题,可以使用upstream_hash这个第三方模块,这个模块多数情况下是用作url_hash的,但是并不妨碍将它用来做session共享:

假如前端是squid,他会将ip加入x_forwarded_for这个http_header里,用upstream_hash可以用这个头做因子,将请求定向到指定的后端:

可见这篇文档:http://www.sudone.com/nginx/nginx_url_hash.html

在文档中是使用$request_uri做因子,稍微改一下:

hash $http_x_forwarded_for;

这样就改成了利用x_forwarded_for这个头作因子,在nginx新版本中可支持读取cookie值,所以也可以改成:

hash $cookie_jsessionid;

假如在php中配置的session为无cookie方式,配合nginx自己的一个userid_module模块就可以用nginx自发一个cookie,可参见userid模块的英文文档:

http://wiki.nginx.org/NginxHttpUserIdModule

另可用姚伟斌编写的模块upstream_jvm_route:http://code.google.com/p/nginx-upstream-jvm-route/

由于无linux环境所以此部分,借用代震军的文字备忘一下

注: 关闭ngnix的命令: nginx -s stop

配置文件ngnix.conf正确性判断的命令: nginx -t

当然Nginx 负载均衡的功能也是很强的,并且其一般作为七层负载均衡(应用协议层)。下面就其upstream所支持的四个常用设置进行说明:

1)、轮询(默认):每个请求按时间顺序逐一分配到不同的后端服务器,如果后端服务器down掉,能自动剔除。

2)、weight :指定轮询几率,weight和访问比率成正比,用于后端服务器性能不均的情况。

2)、ip_hash :每个请求按访问ip的hash结果分配,这样每个访客固定访问一个后端服务器,可以解决session的问题。

3)、fair(第三方):按后端服务器的响应时间来分配请求,响应时间短的优先分配。

4)、url_hash(第三方)

按上面的说明,可以将之前我们的upstream做如下修改:

upstream mylocalsite {

#ip_hash;

server 10.0.2.137:8088 weight=2;

server 10.0.2.137:8089 weight=1;

}

这个当来了三个http请求时,其中的两个会被分配到10.0.2.137:8088 上,一个分配到10.0.2.137:8089 。当然一开始可以其分摊的请求可以不是太严格按其设置,但当请求数多了之后,基本上就接近于我们分指派的权值了。当然就负载均衡的算法而言,使用weight只是其中的一种,而经常使用的还有许多,比如lvs就在其内部实现了多种的负载均衡算法,可以根据用户的实际环境进行设置布署。。当然就目前而言,nginx的算法相比较还是少了许多,呵呵。

可以说在windows下安装配置还是很方便的,但如果使用loadrunner做并发测试时,就会发现其logs/error.log就会报如下错误:

maximum number of descriptors supported by select() is 1024 while connecting to upstream

我曾经在网上查过解决方案,包括修改配置文件的worker_connections ,如下:

worker_rlimit_nofile 20240;

events {

#use epoll;//linux下使用

worker_connections 20240;

}

但依旧不能将文件句柄数扩充到20240,还是报1024最大句柄数错误。最后实在没办法了,只得开始尝试在linux下安装配置nginx。也就引发了下面的内容。

其实在网上有关介绍如何在linux下安装nginx的要比windows下的要多得多,必定这是‘本家’吧。

因为之前网管只在虚拟机上安装了CentOS5,所以只能就尝试在该linux分支版本下安装了。好在虚拟机已安装完了,剩下的工作并不太多。

首先需要以root身份登陆系统,然后切换身份为超级管理员:

sudo -s # 先成为超级管理员

然后进入到src目前下,并在当前目录下download nginx.tar.gz包

cd /usr/src # 将文件下载到这个目录

wget http://sysoev.ru/nginx/nginx-0.7.62.tar.gz# 下载安装包

tar xzvf nginx-0.7.62.tar.gz #解压

如果下载的nginx 中默认可能没有 rewirte规则,因此需要下载pcre包的扩展来实现这个功能:

wget http://blog.s135.com/soft/linux/nginx_php/pcre/pcre-7.8.tar.gz # 下载pcre

tar xzvf pcre-7.8.tar.gz # 解压pcre

下面编译安装pcre

cd /usr/src/pcre-7.8;

./configure --prefix=/usr/local/pcre --enable-utf8 --enable-unicode-properties

下面编译安装nginx

cd /usr/src/nginx-0.7.62

开始配置要编译的参数(注:内容较长,容易输错。具体参数设置参见http://wiki.codemongers.com/NginxChsInstall)

./configure --prefix=/usr/local/nginx --sbin-path=/usr/local/nginx/sbin/nginx --conf-path=/usr/local/nginx/conf/nginx.conf --error-log-path=/usr/local/nginx/logs/error.log --http-log-path=/usr/local/nginx/logs/access.log --pid-path=/usr/local/nginx/var/nginx.pid --lock-path=/usr/local/nginx/var/nginx.lock --http-client-body-temp-path=/dev/shm/nginx_temp/client_body --http-proxy-temp-path=/dev/shm/nginx_temp/proxy --without-http_rewrite_module --without-http-cache --without-http_map_module --without-http_gzip_module

接下来就开始编译生成相应的文件了:

make

make install

然后/dev/shm 也就是内存中,建立一个nginx_temp文件夹

mkdir /dev/shm/nginx_temp

接着创建www用户和组,以及其使用的目录:

/usr/sbin/groupadd www -g 48

/usr/sbin/useradd -u 48 -g www www

mkdir -p /data0/vshare/htdocs

chmod +w /data0/vshare/htdocs

chown -R www:www /data0/vshare/htdocs

这时可以扩充一下文件句柄数(windows下就没这么容易扩展了,哎)

ulimit -SHn 51200 #设置打开文件句柄

到这里,我们就可以使用linux下的vi编辑器编辑一下:

cd /usr/src/nginx-0.7.62/conf/

vi nginx.conf

将之前在window下的修改内容替换(按下insert键进入到编辑模式)到当前的文件中,当修改完成了,按冒号(":")切换到命令模式下,然后敲入“wq”,保存并退出。(强制退出(不保存)的话,输入q!,然后回车)

注:

events {

use epoll;

worker_connections 20240;

}

注:use epoll; //linux下使用,更多内容参见NginxChsOptimizations

这样就可以运行nginx了:

/usr/local/nginx/sbin/nginx -t –c

启动完成后,可以通过如下指令查看其在内存中的运行信息:

# ps aux | egrep '(PID|nginx)'

这样当我们再使用loadrunner运行时,就可以看到error.log中就不再报那个恼人的“1024错误了”。

当然在nginx中,还支持文件缓存,以便于将那些静态文件缓存到本地的nginx服务器上,只不过要修改一下其config文件配置,如下:

vi nginx.conf

在文件中的相应节点处输入如下内容:

location ~ .*\.(gif|jpg|jpeg|png|bmp|swf|js|html|htm|css)$ { #指定缓存文件类型

expires 7d; #设置浏览器过期时间7天

root data/nginx_cache/iis; #静态文件根目录目录(必须对应proxy_temp_path)

proxy_store on; #开启缓存机制

proxy_store_access user:rw group:rw all:rw; #缓存读写规则

proxy_temp_path data/nginx_cache/iis; #存放静态文件的缓存目录

# include proxy.conf; # 外联proxy理的详细配置如proxy_set_header, client_max_body_size  .

.

if (!-e $request_filename) {

proxy_pass http://10.0.2.136;/

}

}