使用IDEA开发SPARK提交remote cluster执行

开发环境

操作系统:windows

开发工具:IntelliJ IDEA 14.1.1 需要安装scala插件

编译环境:jdk 1.7 scala 2.10.4

使用IDEA开发spark应用

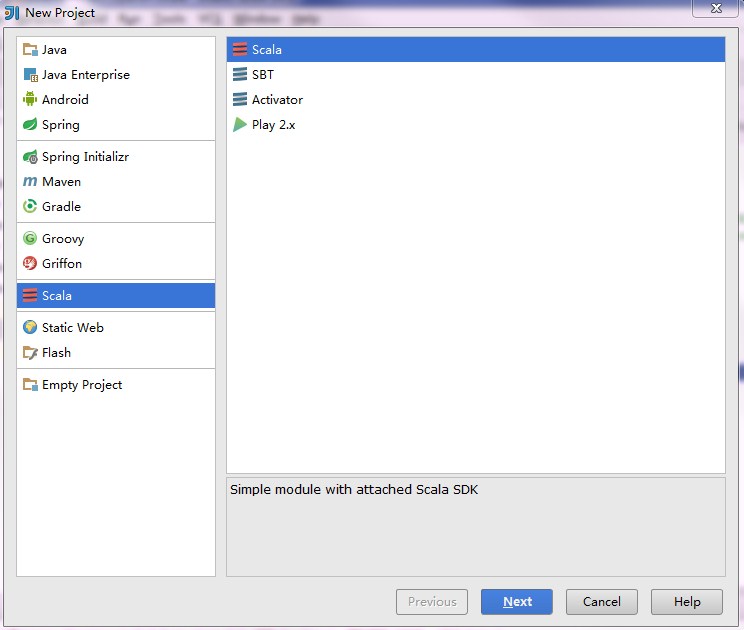

1:新建scala项目:

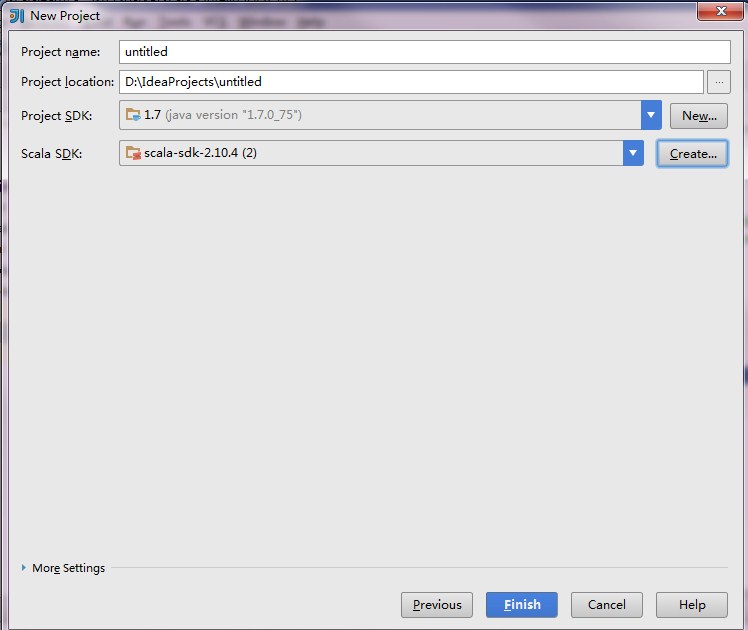

2:选择scala版本,需要spark的scala版本对应

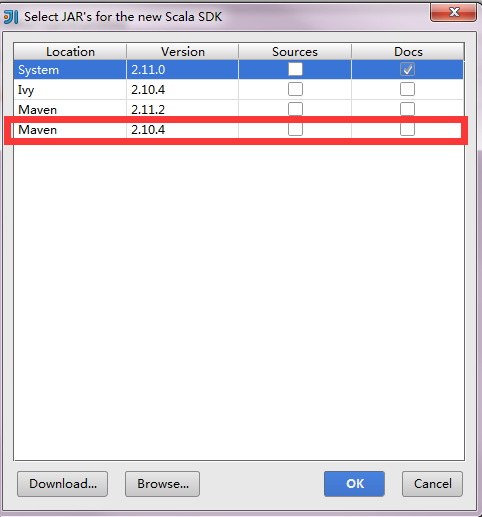

点击上图Scala SDK的create按钮,弹出如下对话框,选择红框

3:添加spark的jar作为library

我直接复制spark安装目录下面的lib里面所有的jar作为library.

4:编写spark应用

import scala.math.randomimport org.apache.spark._/** Computes an approximation to pi */object SparkPi{def main(args:Array[String]){val conf =newSparkConf().setAppName("Spark Pi").setMaster("spark://192.168.1.88:7077").set("spark.driver.host","192.168.1.129").setJars(List("D:\\IdeaProjects\\scalalearn\\out\\artifacts\\scalalearn\\scalalearn.jar"))val spark =newSparkContext(conf)val slices =if(args.length >0) args(0).toInt else2val n =100000* slicesval count = spark.parallelize(1 to n, slices).map { i =>val x = random *2-1val y = random *2-1if(x*x + y*y <1)1else0}.reduce(_ + _)println("Pi is roughly "+4.0* count / n)spark.stop()}}

向远程spark集群提交应用

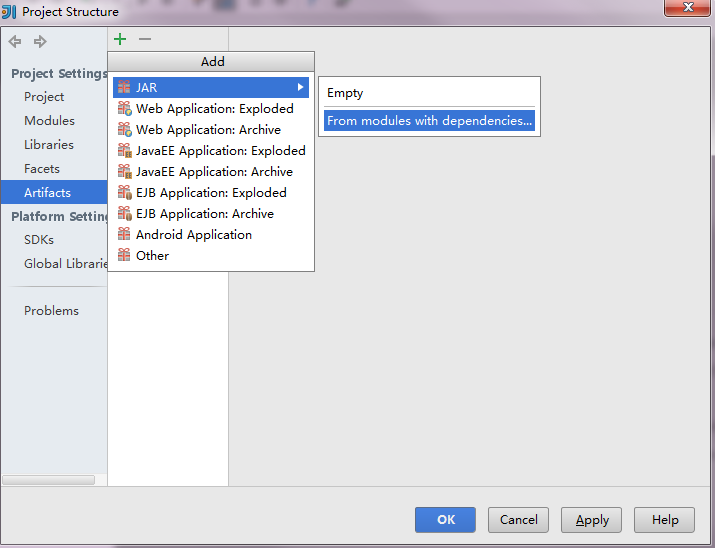

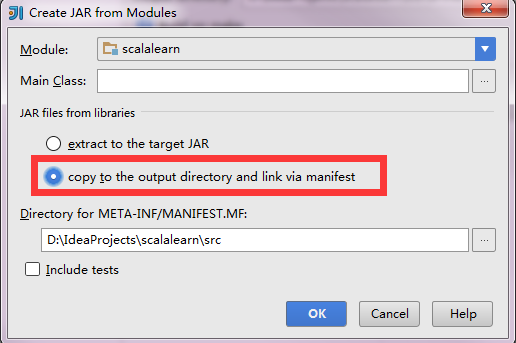

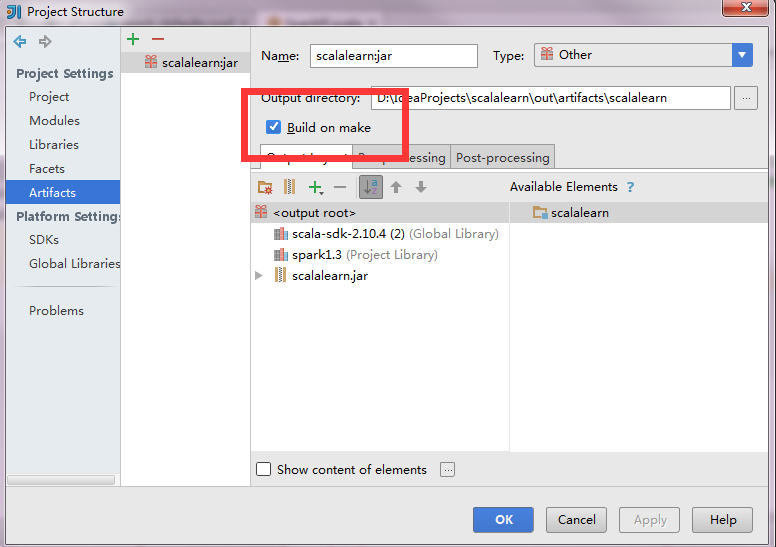

上面的代码中有段setJars(List("D:\\IdeaProjects\\scalalearn\\out\\artifacts\\scalalearn\\scalalearn.jar"))这里要说明下,就是当前工程编译的jar包的绝对路径。 点击File->Project Structure,弹出下面的对话框进行操作

好了现在就OK了