熵

对应的英文单词是Entropy, 是事物混乱程序一种度量方式.

对一个分布来说, 熵:

- 是一个非负值

- 描述从中随机取出一个样本的值的不确定性.

常见的一种计算方式为:

\[H = - \int p(x) ln p(x)dx

\]

\(p(x)\) 是样本 \(x\)出现的概率. 从公式中可以看出, \(p(x)\)越小, \(-ln p(x)\) 越大, 但\(p(x)\)相当于给\(-ln p(x)\)加一个权重, 让小概率事件对整体熵的影响不那么大.

若整个分布只有一个值, 那么它的混乱程序,即它的熵为0.

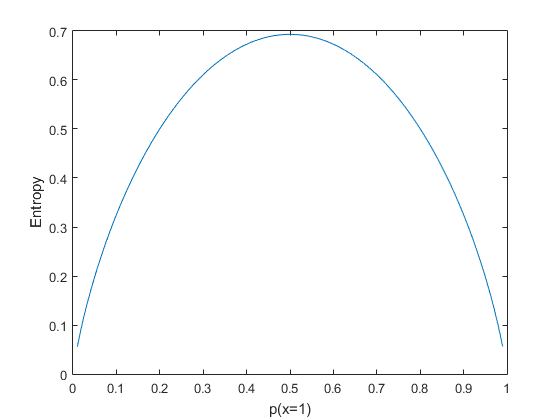

若一个分布只有两种可能的取值,即非0即1,那么它的熵为:

\[H = - p(x=1) ln(p(x=1)) - (1-p(x=1))ln(1-p(x=1))

\]

可以看出:

- 当\(p(x = 1) = 1或0\)时, 熵最小, 因为此时可以完全确定取出的样本是0还是1

- 当\(p(x = 1) = 0.5\)时,熵最大, 因为此时你取一个样本出来,只能瞎猜了。

(END)

Daniel的学习笔记

浙江大学计算机专业15级硕士在读, 方向: Machine Learning, Deep Learning, Computer Vision.

blog内容是我个人的学习笔记, 由于个人水平限制, 肯定有不少错误或遗漏. 若发现, 欢迎留言告知, Thanks!

Daniel的学习笔记

浙江大学计算机专业15级硕士在读, 方向: Machine Learning, Deep Learning, Computer Vision.

blog内容是我个人的学习笔记, 由于个人水平限制, 肯定有不少错误或遗漏. 若发现, 欢迎留言告知, Thanks!

浙公网安备 33010602011771号

浙公网安备 33010602011771号