【论文阅读】HydraPlus-Net: Attentive Deep Features for Pedestrian Analysis

转载请注明出处:https://www.cnblogs.com/White-xzx/

原文地址:https://arxiv.org/abs/1709.09930

Github: https://github.com/xh-liu/HydraPlus-Net

如有不准确或错误的地方,欢迎交流~

HP-Net是一个基于注意力机制(attention-based)的深度神经网络,将多层注意力机制图多向映射到不同的特征层。

【HP-Net Adavantage】

(1)模型能够从浅层到语义层捕获注意力;

(2)挖掘多尺度的可选注意力特征,充实最终的行人特征表示;

(3)提取出细节和局部特征来充实高层全局特征,这些特征在细粒度的行人分析任务中是非常重要的;

(4)提出多方向注意机制模块(multi-directional attention,MDA),提取多层(multiple level)特征,包含局部和全局特征,进行多层特征融合,进行细粒度的行人分析;

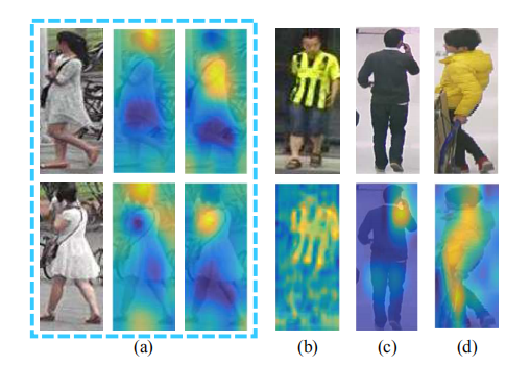

multi-level: (a)语义层:分辨相似外观行人的局部区域特征,如长短发、长短袖; (b)浅层:捕捉行人的衣服的条纹;

multi-scale: (c)(d)多尺度特征,描述行人特点 (c)小尺度特征对应‘打电话’; (d)大尺度全局理解描述‘性别’

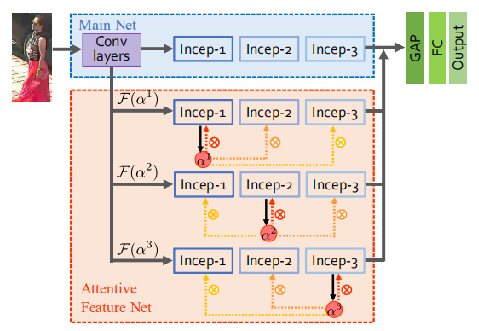

【HydraPlus-Net网络结构】

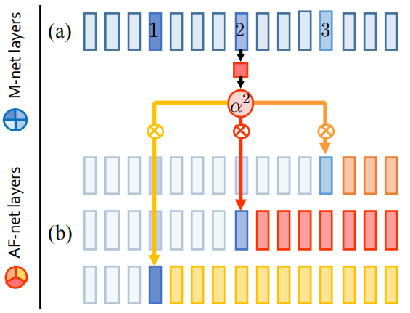

(1)Main Net(M-Net):单纯的CNN结构,论文的实现是基于inception_v2,包含三个inception block,还包含几个低层卷积层

(2)Attentive Feature Net(AF-Net):三个分支,每个分支有三个inception_v2 block和一个MDA

【Attentive Feature Network】

AF-Net包含3个MDA增强的网络分支,![]()

AF-Net和M-Net共享卷积框架,他们的输出级联后经过全局平均池化和全连接层融合,最终的输出映射到属性logits用于属性识别,或特征向量用于再认证。

![]()

![]()

![]() 为inception i模块的输出经过1 1conv、BN、ReLU产生的注意力图,并被相乘到inception k的输出特征图,产生多层多尺度注意力特征,传送到后续的层,MDA模块的最后L个注意力特征级联作为最终特征表示,k∈{1,2,3}

为inception i模块的输出经过1 1conv、BN、ReLU产生的注意力图,并被相乘到inception k的输出特征图,产生多层多尺度注意力特征,传送到后续的层,MDA模块的最后L个注意力特征级联作为最终特征表示,k∈{1,2,3}

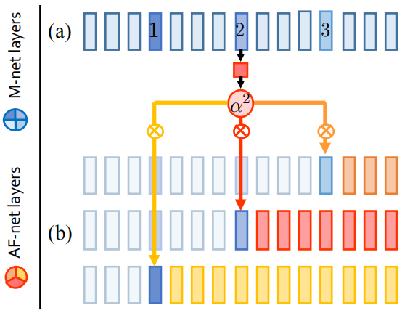

【Attention Mechanism 注意力机制】

传统基于注意力的模型,将注意力图返回输入到原相同的模块(右图红线),通过应用注意力图到相邻的模块来扩展此机制;HP-Net应用不同的注意力图到多个模块(下图b),在相同的空间分布下融合多层特征。

【Multi-level Attention Map 多层注意力图】

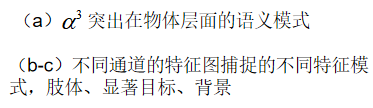

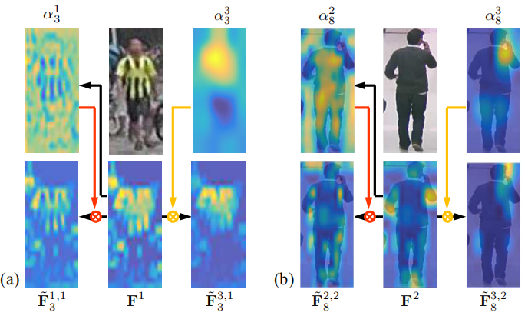

不同模块学习得到注意力图在尺度和细节上差异非常大,如下图(a),高层通常更粗糙、更聚焦语义区域(特定物体),如![]() ,低层捕获局部特征和细节(边缘和纹理),如

,低层捕获局部特征和细节(边缘和纹理),如 ![]() 。因此,使用MDA模块融合不同层注意力特征,可以收集不同层的语义信息,提供更多可选特征表达。

。因此,使用MDA模块融合不同层注意力特征,可以收集不同层的语义信息,提供更多可选特征表达。

上图为每个输入图像提取某level的L = 8 attention channels 的特征图,不同MDA作用下,多级注意力特征的定性演示

(a)浅层属性,如上衣类型,需要低层注意力连接,纹理 -> T-Shirt (b)语义或目标级别的属性,如手机,需要高层注意力连接

【Stage-wise Training 分阶段训练】

①训练M-Net,提取基本特征;

②将M-Net复制三次,得到AF-Net的三个分支,每个MDA模块有三个子分支组成,即临近的三个不同的inception blocks,依次微调每个blocks,即共有9个blocks需要微调;

③微调完成后,固定AF-Net和M-Net,训练全局平均池化层(GAP)和全连接层(FC);

④输出层:属性识别使用交叉熵损失函数,行人ReID使用softmax函数。

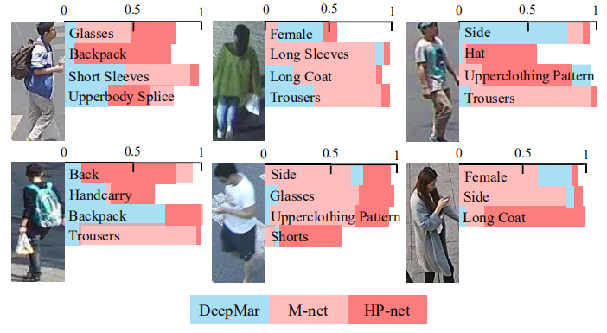

【实验结果】