Logistic回归

Logistic函数

定性因变量的特殊问题

1.离散非正态误差项

\[\begin{align*}

& \epsilon_i=y_i-(\beta_0+\beta_1x_i)只能取两个值\\

& y_i=1时,\epsilon_i=1-\beta_0-\beta_1x_i=1-\pi_i\ \quad (p(y_i=1)=\pi_i)\\

& y_i=0时,\epsilon_i=-\beta_0-\beta_1x_i=-\pi \\

& \epsilon_i是两点型离散分布,正态误差回归模型的假定不适用

\end{align*}

\]

2.0均值异方差性

\[\begin{align*}

& E(\epsilon_i)=0\\

& y_i与\epsilon_i只相差一个常数\beta_0+\beta_ix_i,因此y_i与\epsilon_i的方差相等\\

& 0-1型随机变量\epsilon_i的方差为:\\

& D(\epsilon_i)=D(y_i)=\pi_i(1-\pi_i)=(\beta_0+\beta_1x_i)(1-\beta_0-\beta_1x_i)\\

& \epsilon_i方差依赖于x_i,是异方差,因此最小二乘估计不适用

\end{align*}

\]

3.回归方程限制

\[\begin{align*}

&因变量为0-1时,回归方程y_i=\beta_0+\beta_1x_i+\epsilon_i\\

&y只取0,1情况下,E(y_i)=\beta_0+\beta_1x_i有特殊意义\\

&y_i是0-1型贝努力随机变量\\

&p(y_i=1)=\pi_i,p(y_i=0)=1-\pi_i\\

&E(y_i)=1 \times\pi_i+0\times(1-\pi_i)=\pi_i=\beta_0+\beta_1x_i\\

&即E(y_i)=\beta_0+\beta_1x_i是自变量为x_i时y=1的概率,则因变量均值受到限制0\leq E(y_i)=\pi_i \leq1

\end{align*}

\]

对0-1型因变量问题作出改进

1.回归函数限制在[0,1]区间内的连续曲线

\[\begin{align*}

& 限制曲线常用Logistic与正态分布函数\\

& Logistic函数形式:f(x)=\frac{e^x}{1+e^x}=\frac{1}{1+e^{-x}}

\end{align*}

\]

2.\(y_i\)只取0,1,不适合作为因变量

\[\begin{align*}

& E(y_i)=\pi_i=f(\beta_0+\beta_1x_i)便是y_i=1的概率,因此可以用概率作为因变量\\

& Logistic回归方程为:p_i=\frac{e^{\beta_0+\beta_1x_i}}{1+e^{\beta_0+\beta_1x_i}},i=1,2,...,c,c为分组数据的组数\\

& 将上述回归方程作线性变换,令p_i'=ln(\frac{p_i}{1-p_i})--逻辑变换\\

& 变换后线性回归模型为:p_i'=\beta_0+\beta_1x_i+\epsilon_i\\

& 未分组数据的Logistic回归模型,y_i与x_{i1},x_{i2},...,x_{ip}的关系如下\\

& E(y_i)=\pi_i=f(\beta_0+\beta_1x_{i1}+\beta_2x_{i2}+...+\beta_px_{ip})\\

& y_i服从0-1型分布,p(y_i=1)=\pi_i,p(y_i=0)=1-\pi_i\\

& 概率密度为p(y_i)=\pi_i^{y_i}(1-\pi^{y_i}),y_i=0,1;i=1,2,3,...,n\\

& y_1,y_2,...,y_n似然函数为:L=\prod_{i=1}^np(y_i)=\prod_{i=1}^n\pi_i^{y_i}(1-\pi_i)^{y_i}\\

& 取对数lnL=\sum_{i=1}^n[y_iln\pi_i+(1-y_i)ln(1-\pi_i)]

\end{align*}

\]

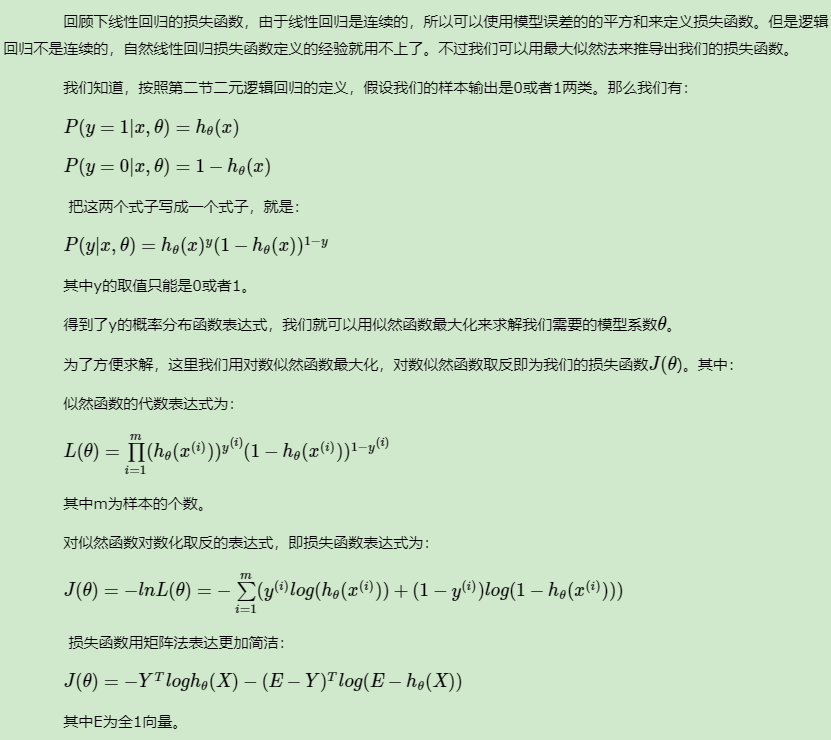

Logistic回归损失函数

\[J(\theta)=-\frac{1}{m} \sum_{i=1}^{m}\left[y^{i} \ln \left(h_{\theta}\left(x^{i}\right)\right)+\left(1-y^{i}\right) \ln \left(1-h_{\theta}\left(x^{i}\right)\right)\right]

\]

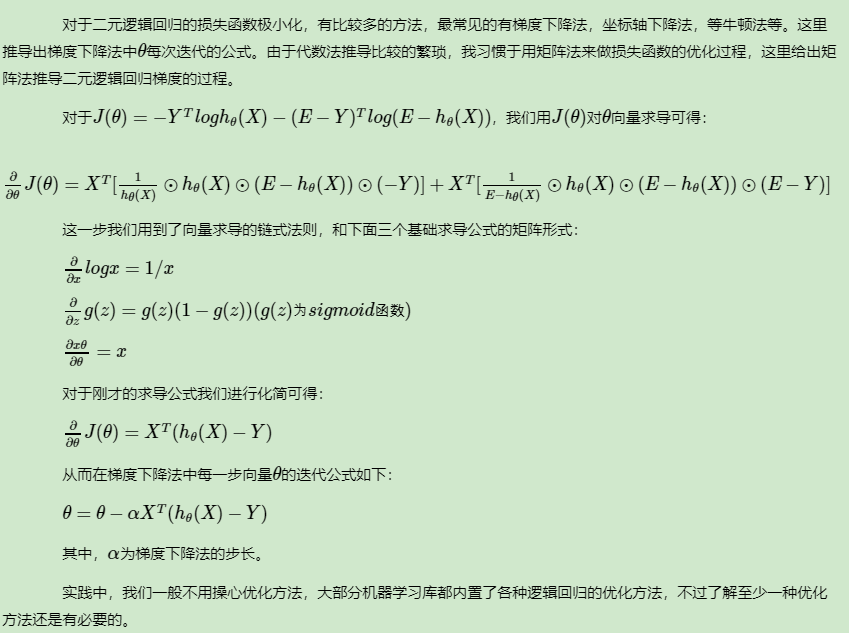

逻辑回归的损失函数的优化方法

Logistic回归的梯度下降法

\[\begin{aligned}

\frac{\partial J(\theta)}{\partial \theta_{j}} &=\frac{\partial}{\partial \theta_{j}}\left[-\frac{1}{m} \sum_{i=1}^{m}\left[-y^{i} \ln \left(1+e^{-\theta^{T} x^{i}}\right)-\left(1-y^{i}\right) \ln \left(1+e^{\theta^{T} x^{t}}\right)\right]\right] \\

&=-\frac{1}{m} \sum_{i=1}^{m}\left[-y^{i} \frac{-x_{j}^{i} e^{-\theta^{T} x^{i}}}{1+e^{-\theta^{T} x^{i}}}-\left(1-y^{i}\right) \frac{x_{j}^{i} e^{\theta^{T} x^{i}}}{1+e^{\theta^{T} x^{i}}}\right] \\

&=-\frac{1}{m} \sum_{i=1}^{m}\left[y^{i} \frac{x_{j}^{i}}{1+e^{\theta^{i} x^{i}}}-\left(1-y^{i}\right) \frac{x_{j}^{i} e^{\theta^{T} x^{i}}}{1+e^{\theta^{T} x^{i}}}\right] \\

&=-\frac{1}{m} \sum_{i=1}^{m} \frac{y^{i} x_{j}^{i}-x_{j}^{i} e^{\theta^{T} x^{i}}+y^ix_j^ie^{\theta^Tx_i}}{1+e^{\theta^{T} x^{i}}} \\

&=-\frac{1}{m} \sum_{i=1}^{m} \frac{y^{i}\left(1+e^{\theta^{T} x^{i}}\right)-e^{\theta^{T} x}}{1+e^{\theta^{T} x^{i}}} x_{j}^{i}\\

&=-\frac{1}{m} \sum_{i=1}^{m}\left(y^{i}-\frac{e^{\theta^{r} x^{i}}}{1+e^{\theta^{r} x^{i}}}\right) x_{j}^{i}\\

&=-\frac{1}{m} \sum_{i=1}^{m}\left(y^{i}-\frac{1}{1+e^{-\theta^{T} x^{i}}}\right) x_{j}^{i}\\

&=-\frac{1}{m} \sum_{i=1}^{m}\left(y^{i}-h_{\theta}\left(x^{i}\right)\right) x_{j}^{i}\\

&=\frac{1}{m} \sum_{i=1}^{m}\left(h_{\theta}\left(x^{i}\right)-y^{i}\right) x_{j}^{i}

\end{aligned}

\]

\[\begin{equation}

梯度更新\

\theta_{j^{*}}=\theta_{j}-\alpha \frac{1}{m} \sum_{i=1}^{m}\left(h_{\theta}\left(x^{i}\right)-y^{i}\right) x_{j}^{i}

\end{equation}

\]

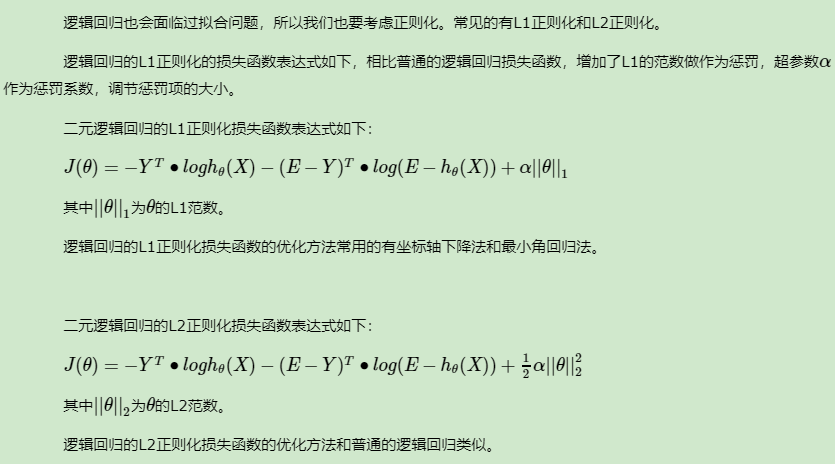

逻辑回归的正则化

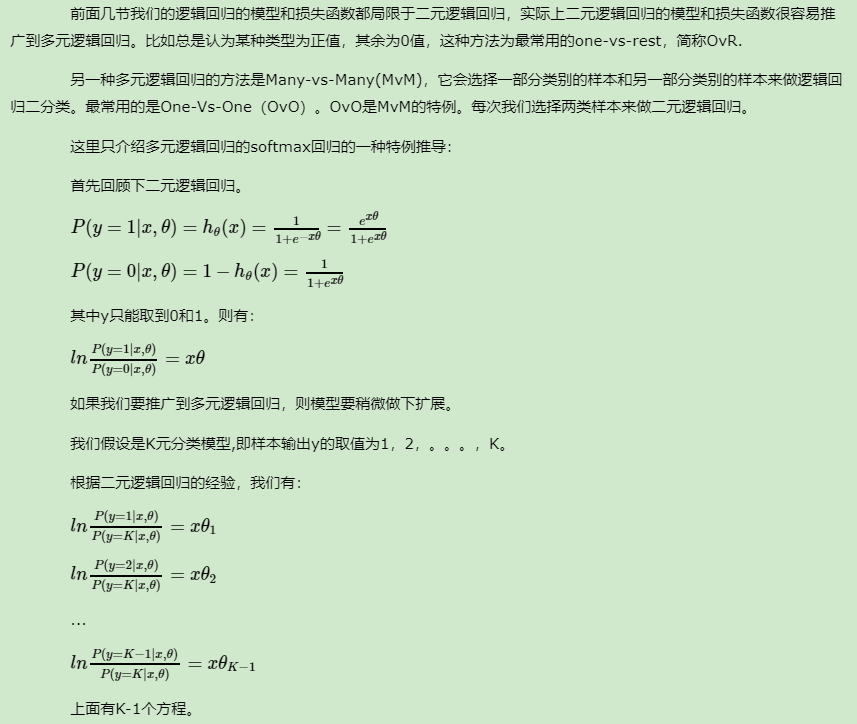

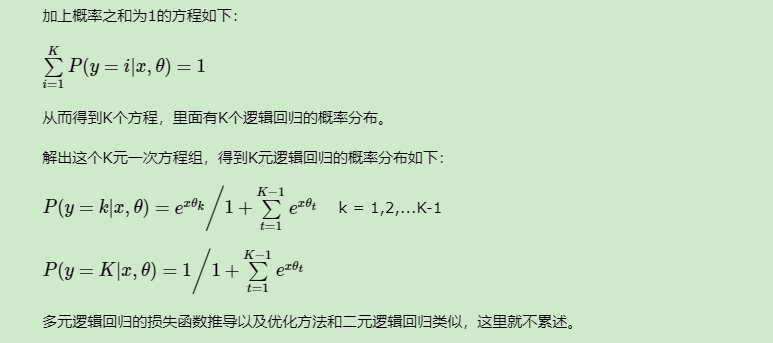

Logistic回归的多分类

为什么sigmod函数可以表示概率?

逻辑回归中的sigmod源自于广义线性模型,因为我们是目标是\(p(y|x)\),二分类就看成是一个伯努利分布,伯努利分布属于指数分布簇,指数簇分布是给定某些统计量下熵最大的分布,例如伯努利分布就是只有两个取值且给定期望值为 \(\phi\)下的熵最大的分布(最大熵理论,熵最大的模型是最好的)

\[p(y;\phi)=\phi^y(1-\phi)^{1-y}=exp(log\phi^y(1-\phi)^{1-y})=exp(ylog\phi+(1-y)log(1-\phi)) \\

=exp(log\frac{\phi}{1-\phi}y+log(1-\phi))\\

指数分布簇形式为p(x|\eta)=h(x)exp\{\eta^TT(x)-A(\eta)\}\\

h(x)=1\\

T(x)=y\\

A(\eta)=-log(1-\phi)=log\frac{1}{1-\frac{1}{1+e^{-\eta}}}=log\frac{1+e^{-\eta}}{1+e^{-\eta}-1}=log(1+e^{\eta})\\

\eta^T=log\frac{\phi}{1-\phi} \Longrightarrow \phi=\frac{1}{1+e^{-\eta}}

\]

这里还有个假设,即\(\eta=wx+b\)存在线性关系

即一旦我们假设以 x 为条件的 y的分布是伯努利分布,那么概率就是sigmod函数

如何理解逻辑回归的两种损失函数?

两种损失函数都基于交叉熵\(H(p,q)=\sum\limits_x p(x)log \frac{1}{q(x)}=-\sum\limits_x p(x )log q(x)\)

这里的\(p(x)\)表示概率,对于分类目标来说,只有发生和不发生,发生的时候为1,不发生的时候为0

\(y\in\{0,1\}\)时,\(q(y=1|x_i)=\frac{1}{1+exp(-w^Tx)}\),交叉熵损失函数为\(-[y_i ln(q(x_i))+(1-y_i)ln(1-q(x_i))]\)

\(y\in\{-1,+1\}\)时,\(q(y=\pm1|x,w)=\frac{1}{1+exp(-y(w^Tx+b))}\),交叉熵损失函数为\(-[ln\frac{1}{1+exp(-y_i(w^Tx+b))}]=ln(1+exp(-y_i(w^Tx_i+b)))\)

浙公网安备 33010602011771号

浙公网安备 33010602011771号