线性回归

一元线性回归

我们假设以房屋交易为例,这里我们只有一个自变量(房屋的大小,x),还有一个因变量(房屋的价格,y),那么我们要做的就是根据已知的样本数据(x,y)发现一个规则(也可以称为映射),之后如果有人问你他的房子值多少钱时,你就可以依据他房子的大小根据我们发现的规则很容易的给出他房子的近似价格。具体如下:

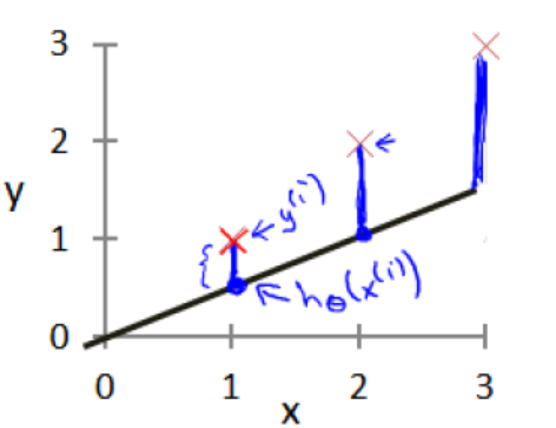

我们给定若干训练数据(小大,价格),然后我们所有数据投影到二维空间中,以房屋大小为x轴,以价格为y轴。这样我们就可以用一个函数

![]()

取近似拟合我们的数据。因其只有一个自变量(输入变量或特征),因此这样的问题我们叫做一元线性回归。

代价函数

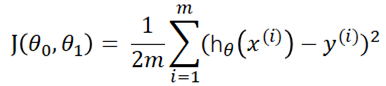

代价函数的作用是有助于找到与我们数据集最相吻合的拟合曲线。假设我们的假设函数为![]() ,我们的训练样本为

,我们的训练样本为![]() ,我们如何才能衡量假设函数对样本拟合的好坏呢?线性回归中我们最常用的代价函数是平方误差代价函数,平方误差是解决回归问题最常用的手段。

,我们如何才能衡量假设函数对样本拟合的好坏呢?线性回归中我们最常用的代价函数是平方误差代价函数,平方误差是解决回归问题最常用的手段。

故,得到:

通常我们选取的拟合直线参数![]() 要使得代价函数最小。

要使得代价函数最小。

多元线性回归

到目前为为止,我们探讨了一元线性回归模型。自然界中一切事物都不是受到单一元素的影响,而是是同时受到多个因素的共同相互作用影响,房价也不列外。我们可以想像,房家除了受到占地面积影响,还有很多影响因素,如:地理位置(是不是在市区),楼层数,周围交通便利程度等等,这都有可能成为影响我们房价的因素。既然有这么多因素,现在我们如何表示我们的假设函数呢?

![]()

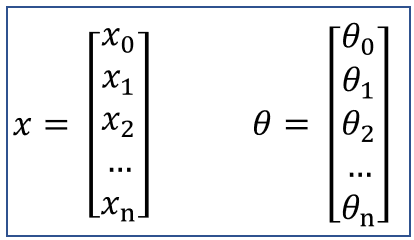

若我们令![]() ,则我们的假设函数可以写成:

,则我们的假设函数可以写成:

![]()

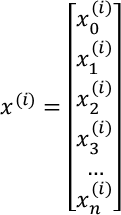

这时我们训练样本为![]() ,每个样本的特征都是一个n+1维的向量:

,每个样本的特征都是一个n+1维的向量:

![]() 就表示的是第i个样本的第n个特征。所以,参数

就表示的是第i个样本的第n个特征。所以,参数![]() 也都是一个n+1维的向量。

也都是一个n+1维的向量。

故,我们的假设函数可以写成:![]()