1.请分析SparkSQL出现的原因,并简述SparkSQL的起源与发展。

原因:关系数据库库在大数据时代已经不能满足要求,SparkSQL的出现,首先可以提供DataFrame API,可以对内部和外部各种数据执行各种关系型操作。其次,可以支持大数据中的大量数据源和数据分析算法。SparkSQL可以融合传统关系数据库的结构化数据管理能力和机器学习算法的数据处理能力。

起源和发展:

2. 简述RDD 和DataFrame的联系与区别?

区别:RDD是分布式的Java对象的集合,而DataFrame是分布式的Row对象的集合;Spark的RDD本身不了解内部结构,而DataFrame带有schema元信息,清楚地知道该数据集合包含哪些列,每列的名称和类型。

联系:DataFrame能做的事情RDD都能做,RDD能做的事情DataFrame不一定能做。

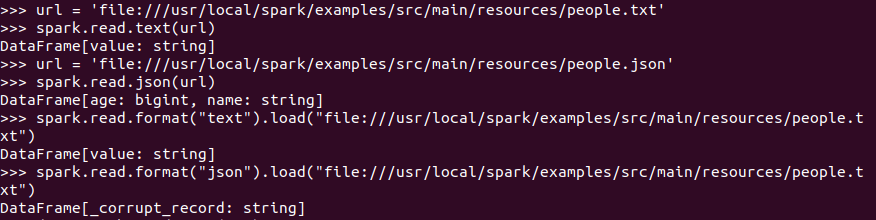

3.DataFrame的创建

spark.read.text(url)

spark.read.json(url) 注意从不同文件类型生成DataFrame的区别。

spark.read.format("text").load("people.txt")

spark.read.format("json").load("people.json")

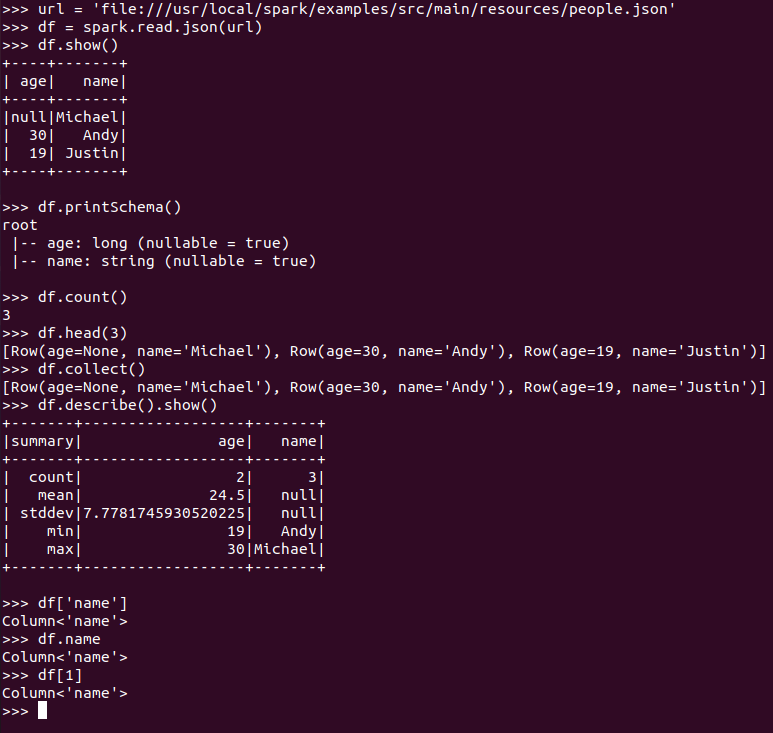

4. PySpark-DataFrame各种常用操作

基于df的操作:

打印数据 df.show()默认打印前20条数据

打印概要 df.printSchema()

查询总行数 df.count()

df.head(3) #list类型,list中每个元素是Row类

输出全部行 df.collect() #list类型,list中每个元素是Row类

查询概况 df.describe().show()

取列 df[‘name’], df.name, df[1]

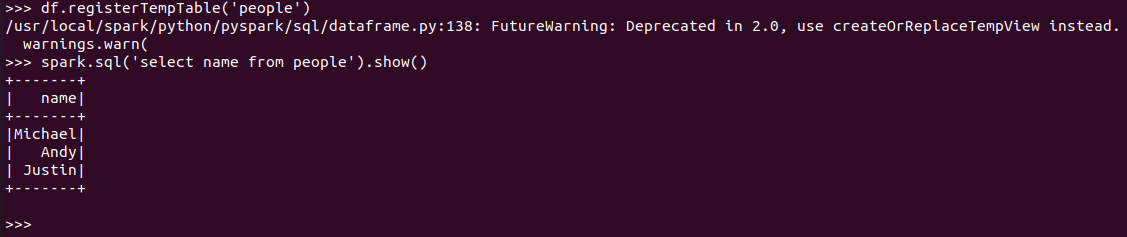

基于spark.sql的操作:

创建临时表虚拟表 df.registerTempTable('people')

spark.sql执行SQL语句 spark.sql('select name from people').show()

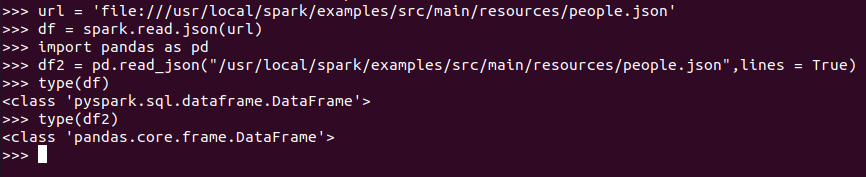

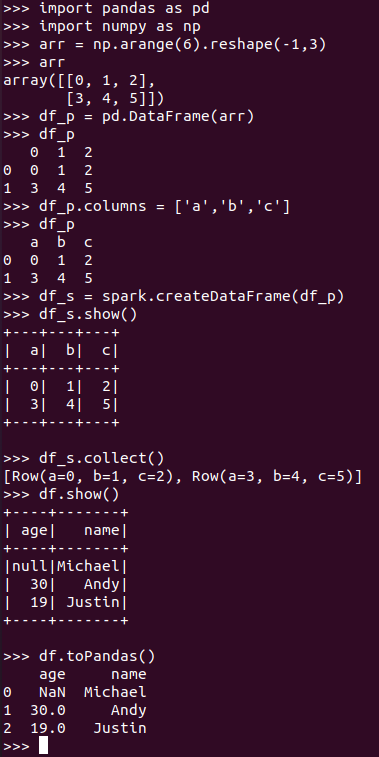

5. Pyspark中DataFrame与pandas中DataFrame

分别从文件创建DataFrame

比较两者的异同

pandas中DataFrame转换为Pyspark中DataFrame

Pyspark中DataFrame转换为pandas中DataFrame

6.从RDD转换得到DataFrame

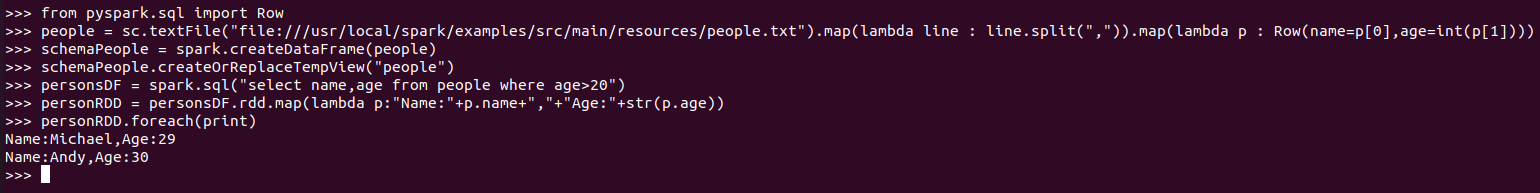

6.1 利用反射机制推断RDD模式

创建RDD sc.textFile(url).map(),读文件,分割数据项

每个RDD元素转换成 Row

由Row-RDD转换到DataFrameurl

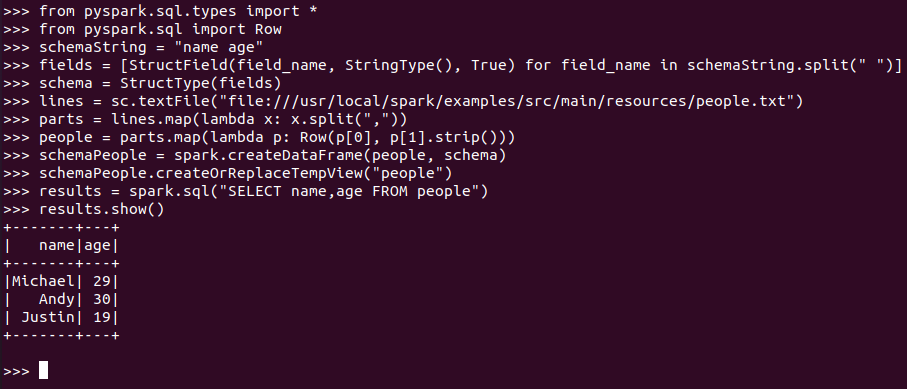

6.2 使用编程方式定义RDD模式

#下面生成“表头”

#下面生成“表中的记录”

#下面把“表头”和“表中的记录”拼装在一起

7. DataFrame的保存

df.write.text(dir)

df.write.json(dri)

df.write.format("text").save(dir)

df.write.format("json").save(dir)